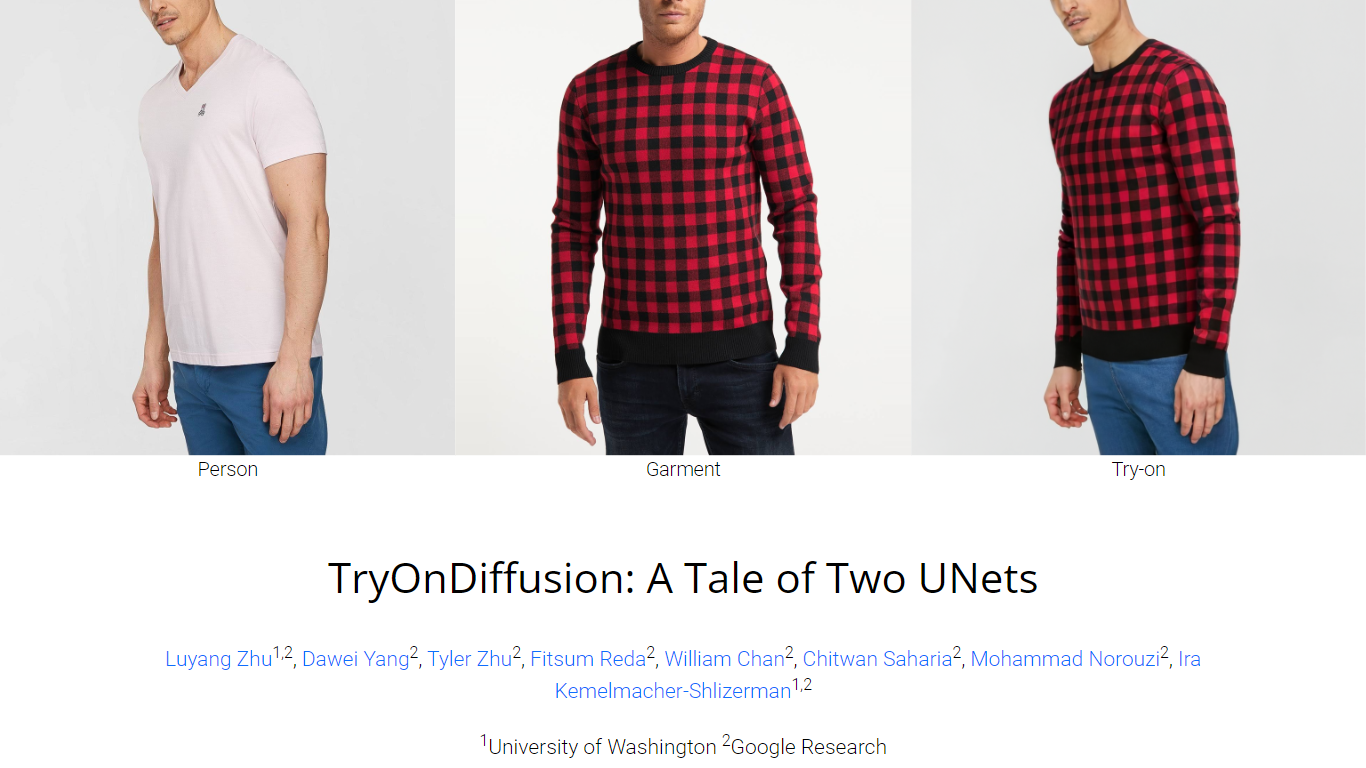

TryOnDiffusion

TryOnDiffusion 展示了一项突破性的技术,可以生成人们穿着实际上并不穿的衣服的逼真图像。这种特殊的方法利用了一种称为 Parallel-UNet 的技术,它是两种 UNet 架构的融合,可以解决将特定服装的细节和纹理转移到不同姿势或形状的个人图像上的复杂挑战。该项目由谷歌研究院和华盛顿大学的一组专家发起,推进了虚拟试穿体验,使用户能够仅通过图像来想象自己或他人身上的衣服。 TryOnDiffusion 在 2023 年著名的 IEEE 计算机视觉和模式识别会议 (CVPR) 上揭晓,TryOnDiffusion 在美学细节和使服装适合不同体型和姿势的实用性方面都表现出色。

统一双 UNet 架构: 两个称为 Parallel-UNet 的 UNet 的集成可以同时实现不同体型和姿势的细节保留和服装变形。

交叉注意机制: 一种创新技术,允许服装图像隐式变形,以无缝贴合目标人物的图像。

超分辨率扩散: 128x128 试戴图像增强为高分辨率 1024x1024 输出,保持高质量的视觉效果。

实验验证: 通过广泛的定性和定量测试证明了最先进的性能。

多功能试穿: 能够想象多个人穿着同一件衣服以及单个人穿着不同的衣服。

什么是 TryOnDiffusion?

TryOnDiffusion 是一项技术,通过合成考虑到个人体型和姿势的逼真图像,创建穿着实际上并未穿着的服装的人们的图像。

TryOnDiffusion 如何在使服装变形的同时保留服装细节?

两个 UNet 以并行配置的方式使用,以实现逼真的虚拟试穿图像所需的细节保留和服装变形。

TryOnDiffusion 中的 Parallel-UNet 有何独特之处?

Parallel-UNet 架构将服装变形和人体混合整合为一个统一的流程,而不是将它们作为单独的任务处理。

TryOnDiffusion 是否与其他最先进的方法进行了比较?

是的,TryOnDiffusion 已被证实优于其他方法,在 FID(Frechet 起始距离)和 KID(内核起始距离)方面展示了领先的结果。

TryOnDiffusion 是在哪里引入的?

该技术已在 2023 年 IEEE 计算机视觉和模式识别会议 (CVPR) 上发布。