Claude 3 \ Anthropic vs Chinchilla

En la competencia entre Claude 3 \ Anthropic vs Chinchilla, ¿cuál herramienta AI Large Language Model (LLM) es la campeona? Evaluamos precios, alternativas, votos positivos, características, opiniones, y más.

Si tuvieras que elegir entre Claude 3 \ Anthropic y Chinchilla, ¿cuál elegirías?

Al examinar Claude 3 \ Anthropic y Chinchilla, ambas son herramientas habilitadas por inteligencia artificial en la categoría de large language model (llm), ¿qué características únicas descubrimos? El conteo de votos positivos favorece a Claude 3 \ Anthropic, convirtiéndolo en el claro ganador. El número de votos positivos para Claude 3 \ Anthropic es de 7, y para Chinchilla es de 6.

¿Quieres cambiar la historia? ¡Vota por tu herramienta favorita y cambia el juego!

Claude 3 \ Anthropic

¿Qué es Claude 3 \ Anthropic?

Descubra el futuro de la inteligencia artificial con el lanzamiento de la familia de modelos Claude 3 de Anthropic. Esta innovadora introducción marca el comienzo de una nueva era en las capacidades de computación cognitiva. La familia consta de tres modelos: Claude 3 Haiku, Claude 3 Sonnet y Claude 3 Opus, cada uno de los cuales ofrece distintos niveles de potencia para adaptarse a una amplia gama de aplicaciones.

Con avances en procesamiento en tiempo real, capacidades de visión y comprensión matizada, los modelos Claude 3 están diseñados para ofrecer comprensión casi humana y creación de contenido sofisticado.

Optimizados para brindar velocidad y precisión, estos modelos se adaptan a tareas como automatización de tareas, automatización de ventas, servicio al cliente y mucho más. Diseñado teniendo en cuenta la confianza y la seguridad, Claude 3 mantiene altos estándares de privacidad y mitigación de prejuicios, listo para transformar industrias en todo el mundo.

Chinchilla

¿Qué es Chinchilla?

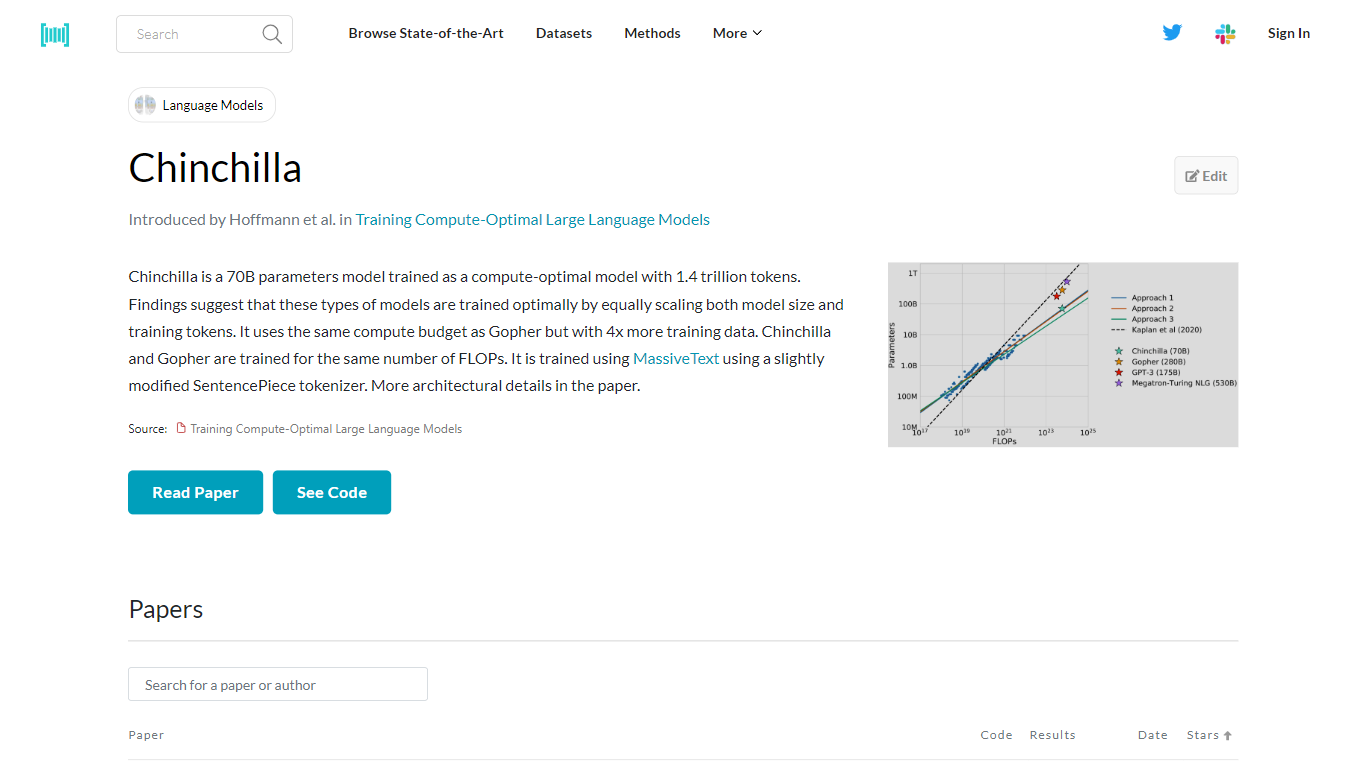

Chinchilla es un modelo avanzado de inteligencia artificial con 70 mil millones de parámetros, desarrollado para optimizar tanto el tamaño del modelo como el volumen de datos de entrenamiento para un aprendizaje eficiente. Fue entrenado utilizando la extraordinaria cantidad de 1,4 billones de tokens, con énfasis en escalar el modelo y los datos proporcionalmente. Este método de entrenamiento se basa en investigaciones que sugieren que el entrenamiento óptimo ocurre cuando el tamaño del modelo y los tokens de entrenamiento aumentan en conjunto. Chinchilla comparte su presupuesto de computación con otro modelo llamado Gopher, pero se distingue por aprovechar cuatro veces más datos de entrenamiento. A pesar de esta diferencia, ambos modelos están diseñados para funcionar con la misma cantidad de FLOP, lo que garantiza una utilización eficiente de los recursos informáticos. Chinchilla aprovecha MassiveText, un vasto conjunto de datos, y emplea una adaptación del tokenizador SentencePieza para interpretar y procesar datos. Para una comprensión detallada de su arquitectura y formación, se puede consultar el artículo que detalla estos aspectos.

Claude 3 \ Anthropic Votos positivos

Chinchilla Votos positivos

Claude 3 \ Anthropic Características principales

Modelos de IA de próxima generación: Presentamos la familia de modelos Claude 3 de última generación, que incluye Haiku, Sonnet y Opus.

Rendimiento avanzado: Cada modelo de la familia está diseñado con capacidades cada vez mayores, ofreciendo un equilibrio entre inteligencia, velocidad y costo.

Visión de última generación: Los modelos Claude 3 vienen con la capacidad de procesar información visual compleja comparable a la vista humana.

Recuerdo y precisión mejorados: Recuerdo casi perfecto en tareas de contexto prolongado y precisión mejorada con respecto a modelos anteriores.

Diseño responsable y seguro: Compromiso con los estándares de seguridad, incluidos sesgos reducidos y enfoques integrales de mitigación de riesgos.

Chinchilla Características principales

Entrenamiento óptimo en computación: Un modelo de parámetros de 70 B entrenado con un enfoque en el escalado ideal del tamaño del modelo y los datos de entrenamiento.

Amplios datos de capacitación: Utiliza 1,4 billones de tokens, lo que indica un conjunto de datos rico y diverso para un aprendizaje en profundidad.

Recursos informáticos equilibrados: Coincide con el presupuesto informático de Gopher y ofrece 4 veces la cantidad de datos de entrenamiento.

Asignación eficiente de recursos: Mantiene la capacitación bajo el mismo número de FLOP que su contraparte, Gopher.

Utilización de MassiveText: Entrena utilizando un tokenizador SentencePieza ligeramente modificado en el conjunto de datos de MassiveText, lo que proporciona un amplio corpus para el aprendizaje de modelos.

Claude 3 \ Anthropic Categoría

- Large Language Model (LLM)

Chinchilla Categoría

- Large Language Model (LLM)

Claude 3 \ Anthropic Tipo de tarificación

- Freemium

Chinchilla Tipo de tarificación

- Freemium