Última actualización 02-10-2024

Categoría:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

Chinchilla

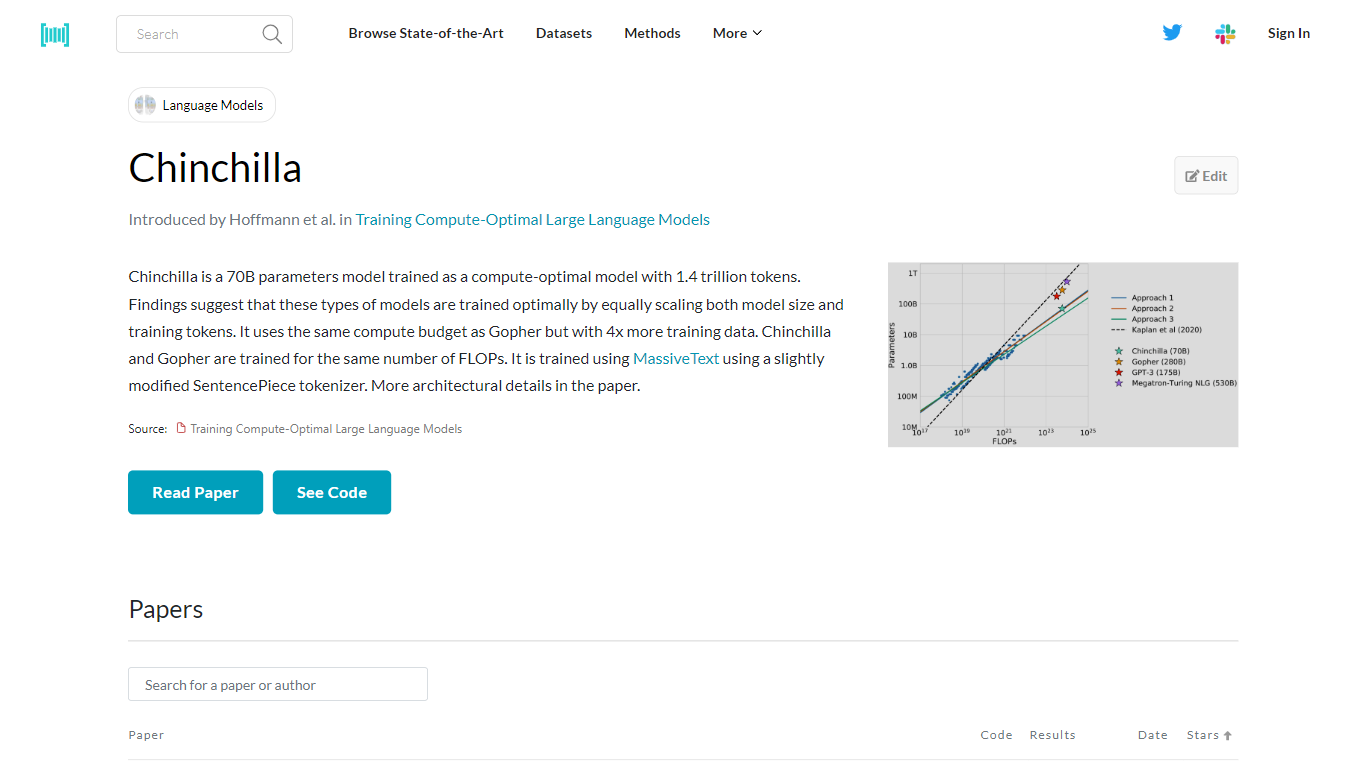

Chinchilla es un modelo avanzado de inteligencia artificial con 70 mil millones de parámetros, desarrollado para optimizar tanto el tamaño del modelo como el volumen de datos de entrenamiento para un aprendizaje eficiente. Fue entrenado utilizando la extraordinaria cantidad de 1,4 billones de tokens, con énfasis en escalar el modelo y los datos proporcionalmente. Este método de entrenamiento se basa en investigaciones que sugieren que el entrenamiento óptimo ocurre cuando el tamaño del modelo y los tokens de entrenamiento aumentan en conjunto. Chinchilla comparte su presupuesto de computación con otro modelo llamado Gopher, pero se distingue por aprovechar cuatro veces más datos de entrenamiento. A pesar de esta diferencia, ambos modelos están diseñados para funcionar con la misma cantidad de FLOP, lo que garantiza una utilización eficiente de los recursos informáticos. Chinchilla aprovecha MassiveText, un vasto conjunto de datos, y emplea una adaptación del tokenizador SentencePieza para interpretar y procesar datos. Para una comprensión detallada de su arquitectura y formación, se puede consultar el artículo que detalla estos aspectos.

Entrenamiento óptimo en computación: Un modelo de parámetros de 70 B entrenado con un enfoque en el escalado ideal del tamaño del modelo y los datos de entrenamiento.

Amplios datos de capacitación: Utiliza 1,4 billones de tokens, lo que indica un conjunto de datos rico y diverso para un aprendizaje en profundidad.

Recursos informáticos equilibrados: Coincide con el presupuesto informático de Gopher y ofrece 4 veces la cantidad de datos de entrenamiento.

Asignación eficiente de recursos: Mantiene la capacitación bajo el mismo número de FLOP que su contraparte, Gopher.

Utilización de MassiveText: Entrena utilizando un tokenizador SentencePieza ligeramente modificado en el conjunto de datos de MassiveText, lo que proporciona un amplio corpus para el aprendizaje de modelos.

1) ¿Qué es Chinchilla en el contexto de los modelos de IA?

Chinchilla es un modelo de IA de 70 mil millones de parámetros diseñado para optimizar la relación entre el tamaño del modelo y los datos de entrenamiento, entrenado con 1,4 billones de tokens.

2) ¿En qué se diferencia Chinchilla del modelo de IA Gopher?

Chinchilla se entrenó con el mismo presupuesto informático que Gopher, pero utilizó cuatro veces la cantidad de datos de entrenamiento para garantizar un aprendizaje óptimo.

3) ¿Qué son los FLOP en el contexto de Chinchilla y Gopher?

Chinchilla y Gopher fueron entrenados para la misma cantidad de FLOP, que significa operaciones de punto flotante por segundo, lo que indica la potencia computacional asignada a cada modelo.

4) ¿Para qué se utiliza el tokenizador MassiveText y SentencePieza en el entrenamiento de Chinchilla?

Chinchilla fue entrenada utilizando el conjunto de datos MassiveText y una versión modificada del tokenizador SentencePieza para interpretar los datos de entrenamiento.

5) ¿Existe algún trabajo de investigación disponible para obtener más información sobre el modelo Chinchilla?

Sí, se pueden encontrar más detalles arquitectónicos y conocimientos sobre la formación y el diseño del modelo Chinchilla en el artículo de investigación asociado.