Chinchilla vs ggml.ai

Al comparar Chinchilla vs ggml.ai, ¿cuál herramienta AI Large Language Model (LLM) brilla con más intensidad? Examinamos precios, alternativas, votos positivos, características, opiniones, y más.

En una comparación entre Chinchilla y ggml.ai, ¿cuál sale por encima?

Cuando ponemos Chinchilla y ggml.ai uno al lado del otro, ambas siendo herramientas impulsadas por inteligencia artificial en la categoría de large language model (llm), El conteo de votos positivos está muy parejo para tanto Chinchilla como ggml.ai. Únete a los usuarios de aitools.fyi para decidir al ganador emitiendo tu voto.

¿Crees que nos equivocamos? ¡Emite tu voto y muéstranos quién manda!

Chinchilla

¿Qué es Chinchilla?

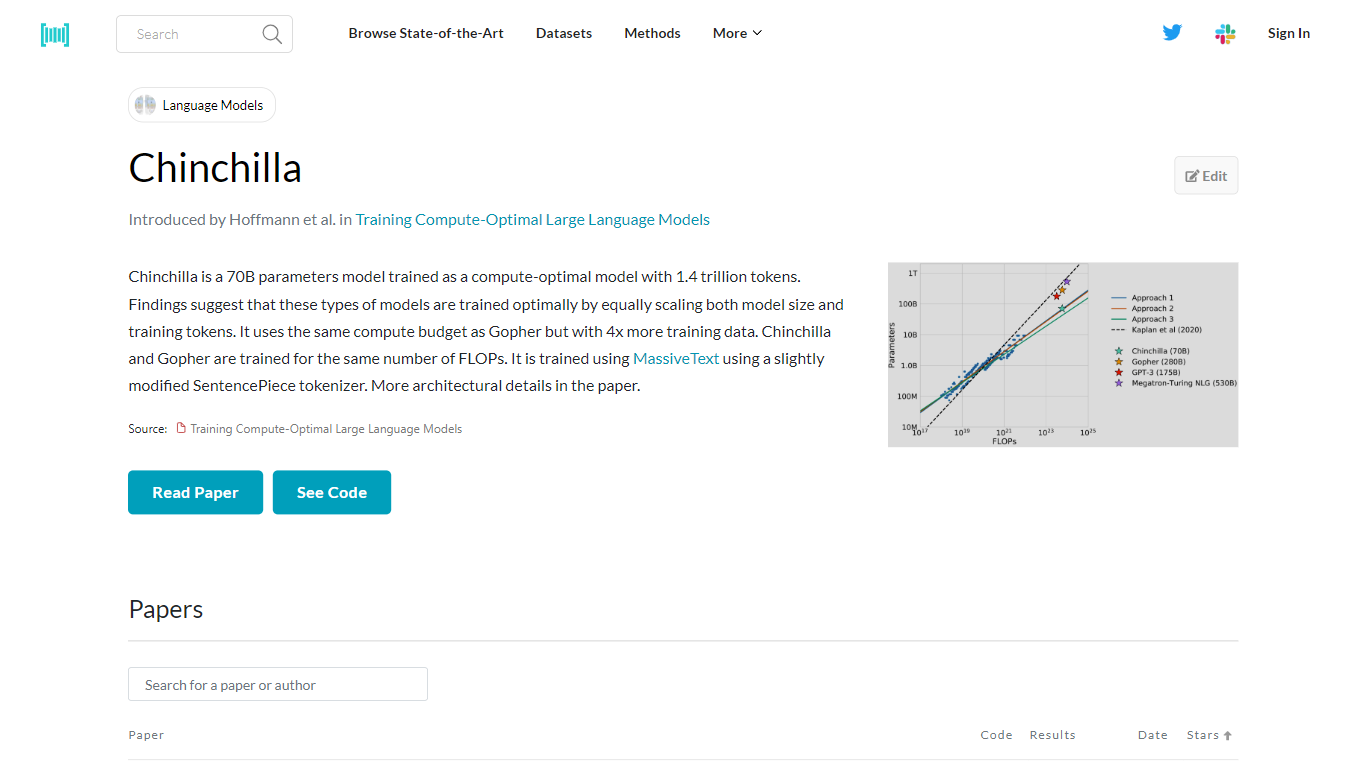

Chinchilla es un modelo avanzado de inteligencia artificial con 70 mil millones de parámetros, desarrollado para optimizar tanto el tamaño del modelo como el volumen de datos de entrenamiento para un aprendizaje eficiente. Fue entrenado utilizando la extraordinaria cantidad de 1,4 billones de tokens, con énfasis en escalar el modelo y los datos proporcionalmente. Este método de entrenamiento se basa en investigaciones que sugieren que el entrenamiento óptimo ocurre cuando el tamaño del modelo y los tokens de entrenamiento aumentan en conjunto. Chinchilla comparte su presupuesto de computación con otro modelo llamado Gopher, pero se distingue por aprovechar cuatro veces más datos de entrenamiento. A pesar de esta diferencia, ambos modelos están diseñados para funcionar con la misma cantidad de FLOP, lo que garantiza una utilización eficiente de los recursos informáticos. Chinchilla aprovecha MassiveText, un vasto conjunto de datos, y emplea una adaptación del tokenizador SentencePieza para interpretar y procesar datos. Para una comprensión detallada de su arquitectura y formación, se puede consultar el artículo que detalla estos aspectos.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

Chinchilla Votos positivos

ggml.ai Votos positivos

Chinchilla Características principales

Entrenamiento óptimo en computación: Un modelo de parámetros de 70 B entrenado con un enfoque en el escalado ideal del tamaño del modelo y los datos de entrenamiento.

Amplios datos de capacitación: Utiliza 1,4 billones de tokens, lo que indica un conjunto de datos rico y diverso para un aprendizaje en profundidad.

Recursos informáticos equilibrados: Coincide con el presupuesto informático de Gopher y ofrece 4 veces la cantidad de datos de entrenamiento.

Asignación eficiente de recursos: Mantiene la capacitación bajo el mismo número de FLOP que su contraparte, Gopher.

Utilización de MassiveText: Entrena utilizando un tokenizador SentencePieza ligeramente modificado en el conjunto de datos de MassiveText, lo que proporciona un amplio corpus para el aprendizaje de modelos.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

Chinchilla Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

Chinchilla Tipo de tarificación

- Freemium

ggml.ai Tipo de tarificación

- Freemium