RLAMA vs ggml.ai

Explora el enfrentamiento entre RLAMA vs ggml.ai y descubre qué herramienta AI Large Language Model (LLM) gana. Analizamos votos positivos, características, opiniones, precios, alternativas, y más.

Al comparar RLAMA y ggml.ai, ¿cuál se destaca por encima del otro?

Al contrastar RLAMA con ggml.ai, ambas son herramientas excepcionales operadas por inteligencia artificial en la categoría de large language model (llm), y al colocarlas lado a lado, podemos notar varias similitudes y divergencias cruciales. Ambas herramientas son igualmente favoritas, como lo indica el conteo idéntico de votos positivos. Puedes ayudarnos a determinar al ganador emitiendo tu voto y inclinando la balanza a favor de una de las herramientas.

¿Te sientes rebelde? ¡Emite tu voto y sacude las cosas!

RLAMA

¿Qué es RLAMA?

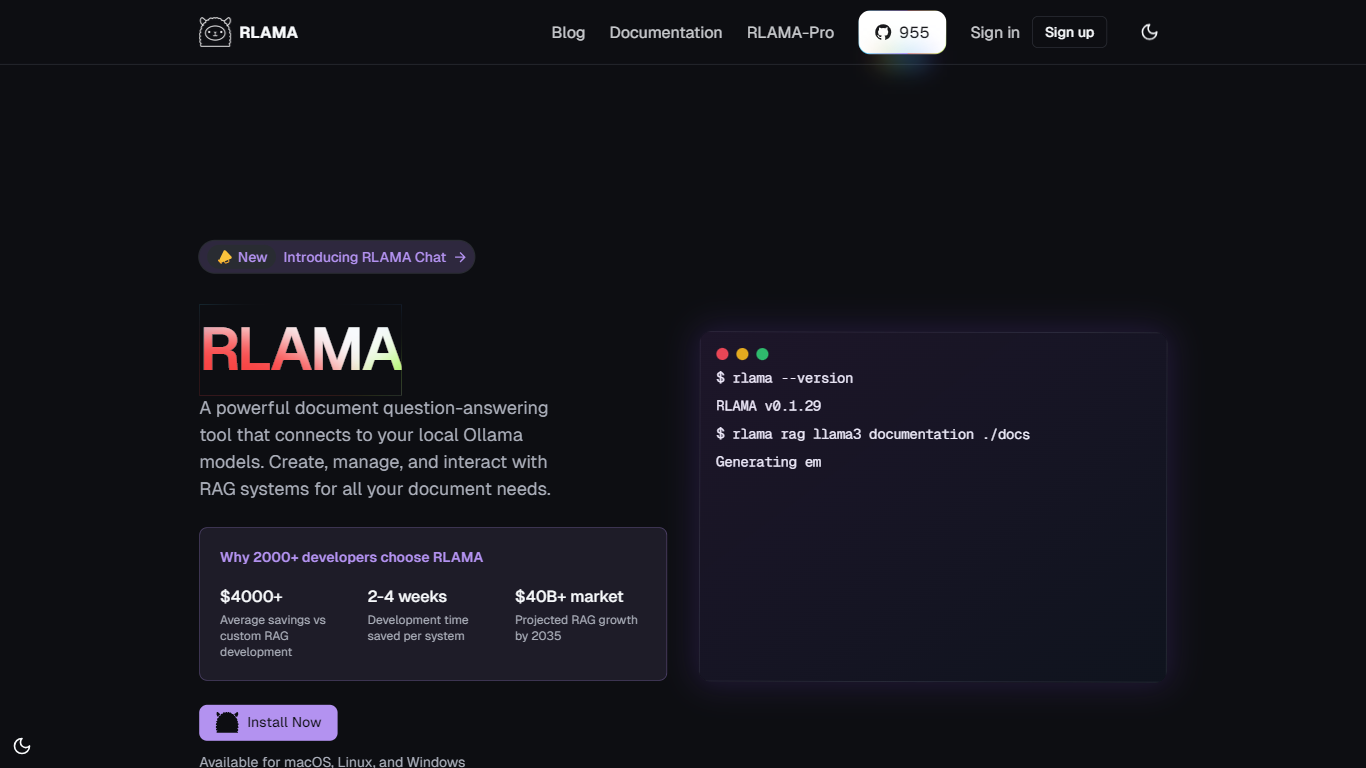

RLAMA es una potente herramienta de preguntas y respuestas para documentos, diseñada para conectarse a la perfección con los modelos locales de Ollama. Permite a los usuarios crear, gestionar e interactuar con sistemas de Recuperación-Generación Aumentada (RAG) diseñados específicamente para sus necesidades de documentación. La funcionalidad principal de RLAMA reside en su capacidad para ofrecer funciones avanzadas que van más allá de las RAG básicas, permitiendo a los usuarios integrar documentos fácilmente en sus flujos de trabajo. Esto la convierte en una solución ideal para desarrolladores y organizaciones que buscan optimizar sus procesos de gestión documental.

El público objetivo de RLAMA incluye desarrolladores, investigadores y organizaciones que requieren una gestión eficiente de documentos y capacidades de respuesta a preguntas. Con más de 2000 desarrolladores que ya eligen RLAMA, ha demostrado ser una herramienta fiable en el mercado. La propuesta de valor única de RLAMA reside en su naturaleza de código abierto, que permite a los usuarios personalizar y adaptar la herramienta a sus requisitos específicos sin incurrir en los altos costes asociados al desarrollo de RAG a medida.

Uno de los principales diferenciadores de RLAMA es su enfoque offline-first, que garantiza que todo el procesamiento se realiza localmente sin enviar datos a servidores externos. Esta función no solo mejora la privacidad, sino que también optimiza el rendimiento al reducir la latencia. Además, RLAMA admite múltiples formatos de documentos, como PDF, Markdown y archivos de texto, lo que lo hace versátil para diversos casos de uso. La función de fragmentación inteligente optimiza aún más la recuperación del contexto, garantizando que los usuarios obtengan la información más relevante de sus documentos.

Los detalles técnicos de la implementación destacan que RLAMA está disponible para macOS, Linux y Windows, lo que lo hace accesible a una amplia gama de usuarios. La herramienta también ofrece un generador visual de RAG, que permite a los usuarios crear potentes sistemas RAG en minutos sin necesidad de programar. Esta interfaz intuitiva está diseñada para que la creación de RAG sea accesible para todos, independientemente de su experiencia técnica. Con RLAMA, los usuarios pueden esperar un ahorro significativo en tiempo y costos de desarrollo al construir sistemas robustos de preguntas y respuestas basados en documentos.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

RLAMA Votos positivos

ggml.ai Votos positivos

RLAMA Características principales

Configuración sencilla: cree y configure sistemas RAG con solo unos pocos comandos y una configuración mínima, lo que hace que sea fácil para cualquier persona comenzar rápidamente.

Múltiples formatos de documentos: admite varios formatos como PDF, Markdown y archivos de texto, lo que permite a los usuarios trabajar con sus tipos de documentos preferidos.

Offline First: garantiza un procesamiento 100% local sin enviar datos a servidores externos, lo que mejora la privacidad y la seguridad de la información confidencial.

Segmentación inteligente: segmenta automáticamente los documentos para una recuperación óptima del contexto, lo que ayuda a los usuarios a encontrar las respuestas más relevantes de manera eficiente.

Visual RAG Builder: cree potentes sistemas RAG visualmente en solo 2 minutos sin escribir ningún código, haciéndolo accesible para todos los usuarios.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

RLAMA Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

RLAMA Tipo de tarificación

- Free

ggml.ai Tipo de tarificación

- Freemium