Última actualización 11-04-2025

Categoría:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

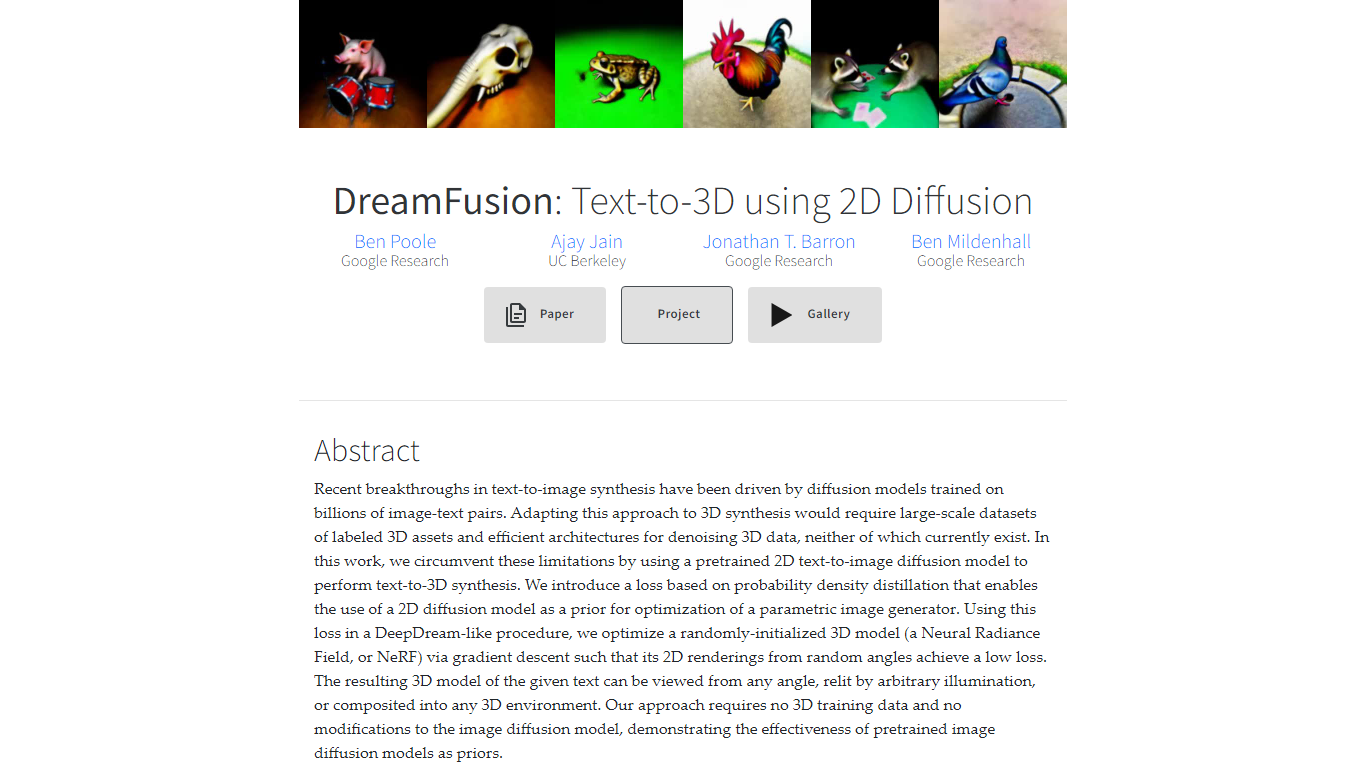

DreamFusion

DreamFusion transforma descripciones de texto en modelos 3D detallados utilizando un modelo de difusión de texto a imagen en 2D preentrenado. Evita la necesidad de grandes conjuntos de datos 3D al optimizar los campos de radiación neuronal (NeRF) mediante una novedosa pérdida de muestreo de destilación de puntuaciones (Score Distillation Sampling). Este método permite que DreamFusion genere escenas en 3D que se pueden ver desde cualquier ángulo, volver a iluminarlas con diferentes luces y integrarlas en diversos entornos 3D.

La herramienta está dirigida a creadores y desarrolladores que desean producir rápidamente activos en 3D sin requerir un conocimiento profundo en modelado 3D ni acceso a datos extensos en 3D. Ofrece una forma de generar objetos que se puedan volver a iluminar, con profundidad precisa y normales de superficie, mejorando el realismo en escenas virtuales.

El valor de DreamFusion radica en su capacidad para aprovechar modelos de difusión 2D existentes, como Imagen, para guiar la síntesis en 3D, evitando la complejidad de entrenar nuevos modelos 3D. También soporta la exportación de NeRFs a mallas mediante cubos de Marching (marching cubes), facilitando el uso de modelos generados en programas 3D comunes.

Desde un punto de vista técnico, DreamFusion utiliza la muestra de destilación de puntuaciones para optimizar los parámetros en 3D de modo que las imágenes renderizadas coincidan con las expectativas del modelo de difusión. Reguladores adicionales mejoran la calidad de la geometría, dando lugar a formas coherentes con propiedades superficiales detalladas.

Este enfoque demuestra cómo los priors de difusión en 2D pueden extenderse más allá de las imágenes hacia la creación de contenido en 3D, abriendo nuevas posibilidades para la generación de 3D basada en texto sin necesidad de datos o arquitecturas especializadas.

Los usuarios pueden explorar una galería de objetos y escenas diversos, mostrando la variedad de resultados posibles a partir de simples indicaciones de texto. DreamFusion sigue evolucionando como una plataforma basada en la investigación que conecta el texto, la difusión en 2D y el modelado en 3D.

🎨 La conversión de texto a 3D crea modelos 3D detallados a partir de indicaciones de texto simples

🔄 Visualiza objetos 3D generados desde cualquier ángulo para una exploración completa de la escena

💡 Los modelos con iluminación ajustable se adaptan a diferentes condiciones de luz de manera realista

🖥️ Exporta modelos NeRF a mallas para su uso en software 3D estándar

⚙️ Utiliza Score Distillation Sampling para optimizar escenas 3D con guía de difusión 2D

No se necesitan grandes conjuntos de datos de entrenamiento 3D ni arquitecturas 3D especializadas

Aprovecha potentes modelos de difusión 2D preentrenados para la síntesis 3D

Genera modelos 3D que se pueden reiluminar y visualizar con geometría precisa

Soporta la exportación de mallas para una fácil integración en flujos de trabajo 3D existentes

El enfoque de investigación abierto fomenta la experimentación y la innovación

Requiere recursos computacionales para la optimización de NeRF

Actualmente enfocado en la investigación; puede carecer de una interfaz amigable para todos los usuarios

La calidad de la salida depende de las capacidades del modelo de difusión y del diseño del prompt

¿Cómo genera DreamFusion modelos 3D a partir de texto sin datos de entrenamiento 3D?

DreamFusion utiliza un modelo de difusión 2D de texto a imagen preentrenado como un prior y optimiza un Neural Radiance Field para que sus renderizados 2D coincidan con las expectativas del modelo de difusión, evitando la necesidad de conjuntos de datos 3D.

¿Puedo exportar los modelos 3D de DreamFusion para usarlos en otro software?

Sí, DreamFusion permite exportar modelos NeRF a mallas usando el algoritmo marching cubes, haciéndolos compatibles con herramientas comunes de modelado y renderizado 3D.

¿Qué es Score Distillation Sampling en DreamFusion?

Score Distillation Sampling es una función de pérdida que guía la optimización de modelos 3D comparando las imágenes renderizadas con las salidas del modelo de difusión, permitiendo la síntesis 3D a partir de priors de difusión 2D.

¿Los modelos 3D generados son relightables bajo diferentes iluminaciones?

Sí, DreamFusion produce objetos 3D relightables con normales de superficie precisas, lo que permite cambios realistas de iluminación en diversos entornos.

¿Quién puede beneficiarse más del uso de DreamFusion?

Creadores, desarrolladores e investigadores que desean generar activos 3D a partir de texto sin necesidad de habilidades de modelado 3D o grandes conjuntos de datos 3D encontrarán DreamFusion valioso.

¿DreamFusion requiere modificaciones al modelo de difusión subyacente?

No, DreamFusion utiliza modelos de difusión 2D preentrenados sin cambios, aprovechándolos como priors para la optimización 3D.

¿Qué tipos de escenas 3D puede generar DreamFusion?

DreamFusion puede generar una amplia gama de objetos y escenas a partir de diversas descripciones de texto, como se muestra en su galería con cientos de activos generados.