GLM-130B vs Terracotta

Dans le choc de GLM-130B vs Terracotta, quel outil AI Large Language Model (LLM) émerge victorieux? Nous évaluons les avis, les prix, les alternatives, les fonctionnalités, les votes positifs, et plus encore.

Quand nous mettons GLM-130B et Terracotta côte à côte, lequel émerge comme le vainqueur?

Prenons un plus près regard sur GLM-130B et Terracotta, tous deux étant des outils large language model (llm) alimentés par l'IA, et voyons ce qui les distingue. GLM-130B est le grand gagnant en termes de votes positifs. GLM-130B a reçu 7 votes positifs des utilisateurs de aitools.fyi, tandis que Terracotta a reçu 6 votes positifs.

Pas votre tasse de thé? Votez pour votre outil préféré et remuez les choses!

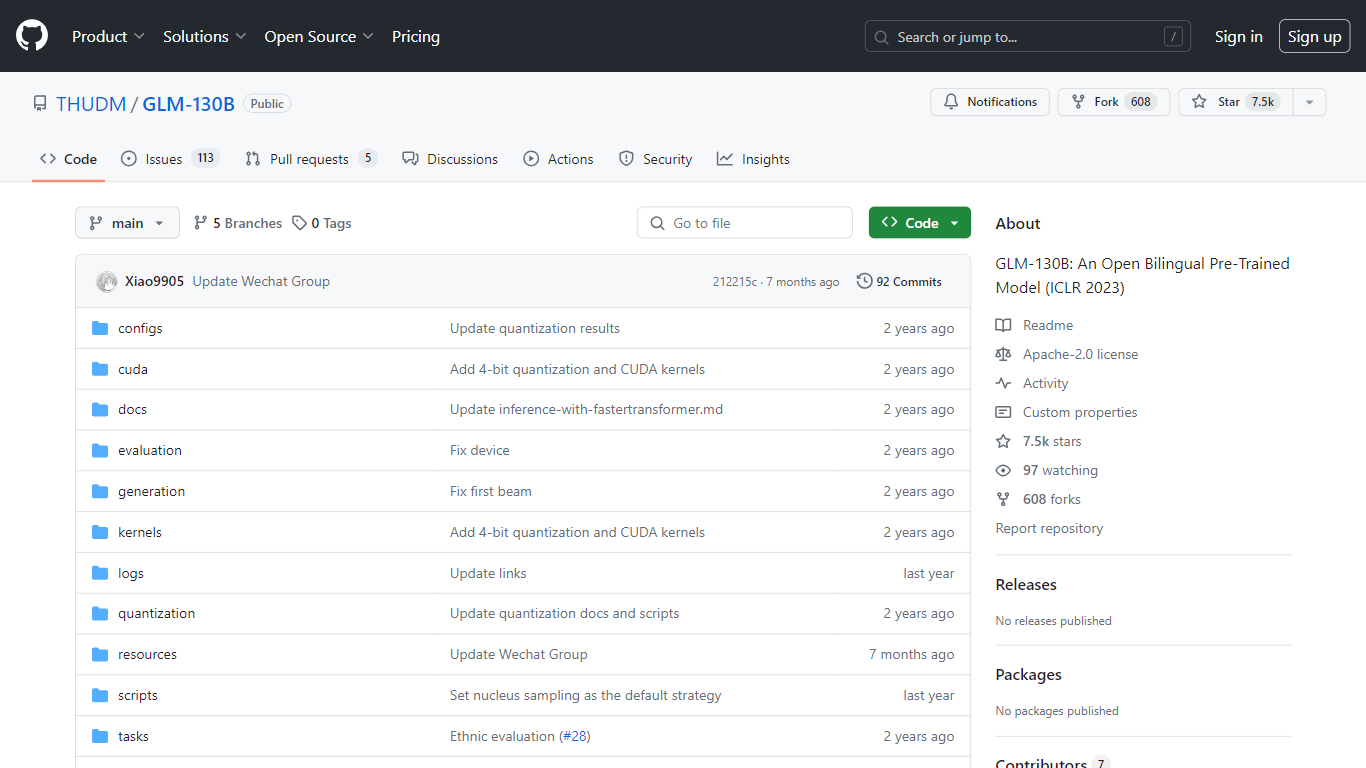

GLM-130B

Qu'est-ce que GLM-130B?

Le GLM-130B, présenté à l'ICLR 2023, représente un modèle pré-entraîné bilingue ouvert révolutionnaire qui se distingue par ses impressionnants 130 milliards de paramètres. Développé pour la modélisation dense bidirectionnelle en anglais et en chinois, le GLM-130B exploite l'algorithme General Language Model (GLM) pour la pré-formation et est optimisé pour exécuter des tâches d'inférence sur une configuration de serveur unique, qu'il s'agisse de l'A100 (40G * 8). ou le V100 (32G8). De plus, sa compatibilité avec la quantification INT4 signifie que les exigences matérielles déjà modestes peuvent être encore réduites, permettant à un serveur avec 4 RTX 3090 (24G) de prendre en charge le modèle avec une dégradation minimale des performances.

Dans le cadre de son processus de formation, le GLM-130B a digéré un vaste ensemble de données composé de plus de 400 milliards de jetons de texte, répartis à parts égales entre le chinois et l'anglais. Il offre un support bilingue exceptionnel, des performances supérieures sur divers ensembles de données par rapport à ses homologues et offre des temps d'inférence rapides. De plus, ce référentiel favorise également la reproductibilité en facilitant les points de contrôle du code open source et des modèles pour plus de 30 tâches.

Terracotta

Qu'est-ce que Terracotta?

Terracotta est une plate-forme de pointe conçue pour améliorer le flux de travail des développeurs et des chercheurs travaillant avec de grands modèles de langage (LLM). Cette plate-forme intuitive et conviviale vous permet de gérer, d'itérer et d'évaluer facilement vos modèles affinés. Avec Terracotta, vous pouvez télécharger des données en toute sécurité, affiner les modèles pour diverses tâches telles que la classification et la génération de texte, et créer des évaluations complètes pour comparer les performances des modèles à l'aide de mesures qualitatives et quantitatives. Notre outil prend en charge les connexions aux principaux fournisseurs comme OpenAI et Cohere, vous garantissant ainsi l'accès à un large éventail de fonctionnalités LLM. Terracotta est la création de Beri Kohen et Lucas Pauker, passionnés d'IA et diplômés de Stanford, qui se consacrent à l'avancement du développement du LLM. Rejoignez notre liste de diffusion pour rester informé des dernières mises à jour et fonctionnalités que Terracotta a à offrir.

GLM-130B Votes positifs

Terracotta Votes positifs

GLM-130B Fonctionnalités principales

Support bilingue : Le GLM-130B s'adresse aux modèles en anglais et en chinois.

Hautes performances : Des tests complets montrent que le GLM-130B surpasse les modèles concurrents sur divers ensembles de données.

Inférence rapide : utilise SAT et FasterTransformer pour une inférence rapide sur un seul serveur A100.

Reproductibilité : Résultats cohérents sur plus de 30 tâches, grâce au code open source et aux points de contrôle du modèle.

Compatibilité multiplateforme : Compatible avec une gamme de plates-formes, notamment NVIDIA, Hygon DCU, Ascend 910 et Sunway.

Terracotta Fonctionnalités principales

Gérez de nombreux modèles : Gérez de manière centralisée tous vos modèles optimisés en un seul endroit pratique.

Itérez rapidement : Rationalisez le processus d'amélioration du modèle grâce à des évaluations qualitatives et quantitatives rapides.

Fournisseurs multiples : Intégrez-vous de manière transparente aux services d'OpenAI et de Cohere pour dynamiser votre processus de développement.

Téléchargez vos données : Téléchargez et stockez en toute sécurité vos ensembles de données pour affiner les modèles.

Créer des évaluations : Réalisez des évaluations comparatives approfondies des performances des modèles en tirant parti de mesures telles que la précision BLEU et les matrices de confusion.

GLM-130B Catégorie

- Large Language Model (LLM)

Terracotta Catégorie

- Large Language Model (LLM)

GLM-130B Type de tarification

- Free

Terracotta Type de tarification

- Freemium