Dernière mise à jour 10-23-2025

Catégorie:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

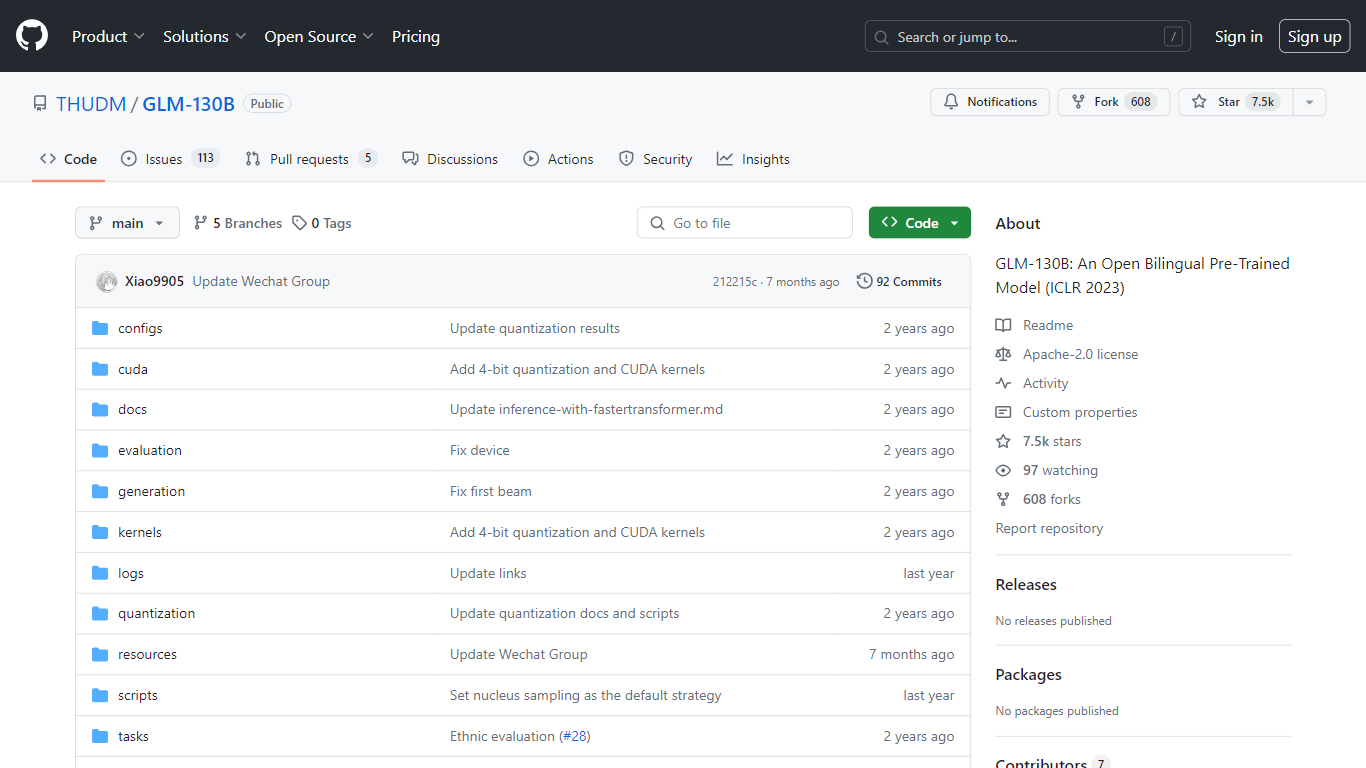

GLM-130B

Le GLM-130B, présenté à l'ICLR 2023, représente un modèle pré-entraîné bilingue ouvert révolutionnaire qui se distingue par ses impressionnants 130 milliards de paramètres. Développé pour la modélisation dense bidirectionnelle en anglais et en chinois, le GLM-130B exploite l'algorithme General Language Model (GLM) pour la pré-formation et est optimisé pour exécuter des tâches d'inférence sur une configuration de serveur unique, qu'il s'agisse de l'A100 (40G * 8). ou le V100 (32G8). De plus, sa compatibilité avec la quantification INT4 signifie que les exigences matérielles déjà modestes peuvent être encore réduites, permettant à un serveur avec 4 RTX 3090 (24G) de prendre en charge le modèle avec une dégradation minimale des performances.

Dans le cadre de son processus de formation, le GLM-130B a digéré un vaste ensemble de données composé de plus de 400 milliards de jetons de texte, répartis à parts égales entre le chinois et l'anglais. Il offre un support bilingue exceptionnel, des performances supérieures sur divers ensembles de données par rapport à ses homologues et offre des temps d'inférence rapides. De plus, ce référentiel favorise également la reproductibilité en facilitant les points de contrôle du code open source et des modèles pour plus de 30 tâches.

Support bilingue : Le GLM-130B s'adresse aux modèles en anglais et en chinois.

Hautes performances : Des tests complets montrent que le GLM-130B surpasse les modèles concurrents sur divers ensembles de données.

Inférence rapide : utilise SAT et FasterTransformer pour une inférence rapide sur un seul serveur A100.

Reproductibilité : Résultats cohérents sur plus de 30 tâches, grâce au code open source et aux points de contrôle du modèle.

Compatibilité multiplateforme : Compatible avec une gamme de plates-formes, notamment NVIDIA, Hygon DCU, Ascend 910 et Sunway.

Qu’est-ce que le GLM-130B ?

GLM-130B est un modèle dense bilingue et bidirectionnel avec 130 milliards de paramètres, pré-entraîné à l'aide de l'algorithme General Language Model (GLM).

Sur quelle quantité de données le GLM-130B a-t-il été formé ?

Le modèle a été formé sur plus de 400 milliards de jetons de texte, avec 200 milliards chacun pour le texte chinois et anglais.

Les résultats produits par GLM-130B peuvent-ils être reproduits ?

Oui, tous les résultats de plus de 30 tâches peuvent être facilement reproduits à l'aide du code open source fourni et des points de contrôle du modèle.

Le GLM-130B prend-il en charge plusieurs plates-formes matérielles ?

Le GLM-130B prend en charge non seulement NVIDIA, mais également Hygon DCU, Ascend 910 et bientôt les plates-formes Sunway pour la formation et l'inférence.

Quel est l’objectif principal du référentiel GLM-130B ?

Le référentiel se concentre principalement sur l'évaluation du GLM-130B, prenant en charge l'inférence rapide de modèle et la reproductibilité des résultats.