GLM-130B vs ggml.ai

Lors de la comparaison de GLM-130B vs ggml.ai, quel outil AI Large Language Model (LLM) brille le plus? Nous examinons les prix, les alternatives, les votes positifs, les fonctionnalités, les avis, et bien plus.

Entre GLM-130B et ggml.ai, lequel est supérieur?

Quand nous mettons GLM-130B et ggml.ai côte à côte, tous deux étant des outils large language model (llm) alimentés par l'IA, GLM-130B est le grand gagnant en termes de votes positifs. GLM-130B a été voté 7 fois par les utilisateurs de aitools.fyi, et ggml.ai a été voté 6 fois.

Pas votre tasse de thé? Votez pour votre outil préféré et remuez les choses!

GLM-130B

Qu'est-ce que GLM-130B?

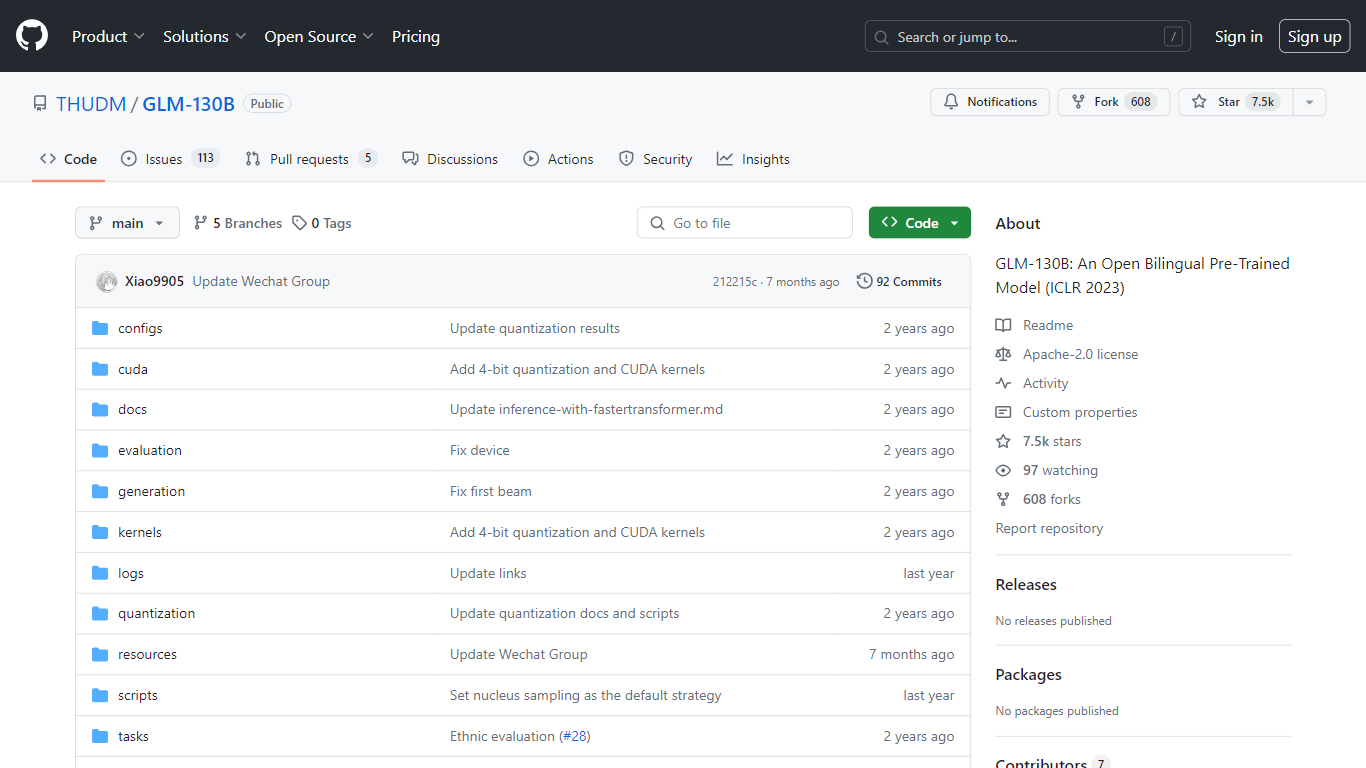

Le GLM-130B, présenté à l'ICLR 2023, représente un modèle pré-entraîné bilingue ouvert révolutionnaire qui se distingue par ses impressionnants 130 milliards de paramètres. Développé pour la modélisation dense bidirectionnelle en anglais et en chinois, le GLM-130B exploite l'algorithme General Language Model (GLM) pour la pré-formation et est optimisé pour exécuter des tâches d'inférence sur une configuration de serveur unique, qu'il s'agisse de l'A100 (40G * 8). ou le V100 (32G8). De plus, sa compatibilité avec la quantification INT4 signifie que les exigences matérielles déjà modestes peuvent être encore réduites, permettant à un serveur avec 4 RTX 3090 (24G) de prendre en charge le modèle avec une dégradation minimale des performances.

Dans le cadre de son processus de formation, le GLM-130B a digéré un vaste ensemble de données composé de plus de 400 milliards de jetons de texte, répartis à parts égales entre le chinois et l'anglais. Il offre un support bilingue exceptionnel, des performances supérieures sur divers ensembles de données par rapport à ses homologues et offre des temps d'inférence rapides. De plus, ce référentiel favorise également la reproductibilité en facilitant les points de contrôle du code open source et des modèles pour plus de 30 tâches.

ggml.ai

Qu'est-ce que ggml.ai?

ggml.ai est à la pointe de la technologie de l'IA, apportant de puissantes capacités d'apprentissage automatique directement à la périphérie grâce à sa bibliothèque de tenseurs innovante. Conçu pour la prise en charge de grands modèles et des performances élevées sur les plates-formes matérielles courantes, ggml.ai permet aux développeurs d'implémenter des algorithmes d'IA avancés sans avoir besoin d'équipement spécialisé. La plate-forme, écrite dans le langage de programmation C efficace, offre une prise en charge de la quantification flottante et entière 16 bits, ainsi que la différenciation automatique et divers algorithmes d'optimisation intégrés comme ADAM et L-BFGS. Il offre des performances optimisées pour Apple Silicon et exploite les intrinsèques AVX/AVX2 sur les architectures x86. Les applications basées sur le Web peuvent également exploiter ses capacités via la prise en charge de WebAssembly et WASM SIMD. Avec ses allocations de mémoire d'exécution nulles et son absence de dépendances tierces, ggml.ai présente une solution minimale et efficace pour l'inférence sur l'appareil.

Des projets tels que Whisper.cpp et Llama.cpp démontrent les capacités d'inférence hautes performances de ggml.ai, Whisper.cpp fournissant des solutions de synthèse vocale et Llama.cpp se concentrant sur l'inférence efficace du grand modèle de langage LLaMA de Meta. De plus, la société accueille favorablement les contributions à sa base de code et prend en charge un modèle de développement open-core via la licence MIT. Alors que ggml.ai continue de se développer, il recherche des développeurs à temps plein talentueux partageant une vision commune de l'inférence sur appareil pour rejoindre son équipe.

Conçu pour repousser les limites de l'IA à la pointe, ggml.ai témoigne de l'esprit de jeu et d'innovation de la communauté de l'IA.

GLM-130B Votes positifs

ggml.ai Votes positifs

GLM-130B Fonctionnalités principales

Support bilingue : Le GLM-130B s'adresse aux modèles en anglais et en chinois.

Hautes performances : Des tests complets montrent que le GLM-130B surpasse les modèles concurrents sur divers ensembles de données.

Inférence rapide : utilise SAT et FasterTransformer pour une inférence rapide sur un seul serveur A100.

Reproductibilité : Résultats cohérents sur plus de 30 tâches, grâce au code open source et aux points de contrôle du modèle.

Compatibilité multiplateforme : Compatible avec une gamme de plates-formes, notamment NVIDIA, Hygon DCU, Ascend 910 et Sunway.

ggml.ai Fonctionnalités principales

Écrit en C : Garantit des performances élevées et une compatibilité sur une gamme de plates-formes.

Optimisation pour Apple Silicon : Offre un traitement efficace et une latence réduite sur les appareils Apple.

Prise en charge de WebAssembly et WASM SIMD : Facilite l'utilisation des applications Web par les capacités d'apprentissage automatique.

Aucune dépendance tierce : Permet une base de code épurée et un déploiement pratique.

Prise en charge de la sortie linguistique guidée : Améliore l'interaction homme-machine avec des réponses plus intuitives générées par l'IA.

GLM-130B Catégorie

- Large Language Model (LLM)

ggml.ai Catégorie

- Large Language Model (LLM)

GLM-130B Type de tarification

- Free

ggml.ai Type de tarification

- Freemium