RLAMA vs ggml.ai

Explorez le face-à-face entre RLAMA vs ggml.ai et découvrez quel outil AI Large Language Model (LLM) gagne. Nous analysons les votes positifs, les fonctionnalités, les avis, les prix, les alternatives, et plus encore.

En comparant RLAMA et ggml.ai, lequel se démarque?

Quand nous contrastons RLAMA avec ggml.ai, tous deux étant des outils exceptionnels large language model (llm) opérés par l'IA, et les plaçons côte à côte, nous pouvons repérer plusieurs similitudes et divergences cruciales. Les deux outils sont également favorisés, comme l'indique le décompte identique des votes positifs. Vous pouvez nous aider à déterminer le gagnant en votant et en faisant pencher la balance en faveur de l'un des outils.

Vous vous sentez rebelle? Votez et secouez les choses!

RLAMA

Qu'est-ce que RLAMA?

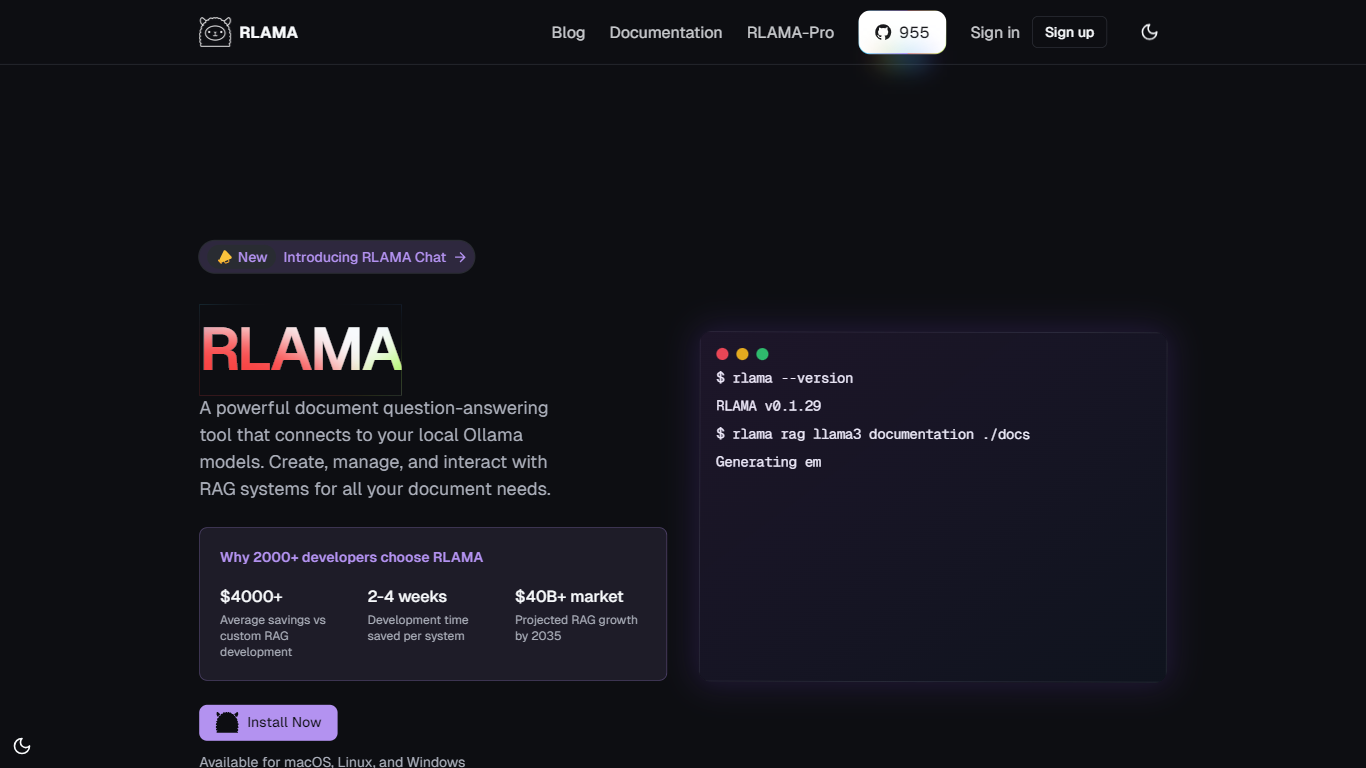

RLAMA est un puissant outil de gestion de documents par questions-réponses, conçu pour s'intégrer parfaitement aux modèles Ollama locaux. Il permet aux utilisateurs de créer, de gérer et d'interagir avec des systèmes de génération augmentée de données (RAG) adaptés spécifiquement à leurs besoins documentaires. RLAMA offre des fonctionnalités avancées qui vont au-delà du RAG de base, permettant aux utilisateurs d'intégrer facilement des documents à leurs flux de travail. C'est donc une solution idéale pour les développeurs et les organisations souhaitant optimiser leurs processus de gestion documentaire.

RLAMA s'adresse aux développeurs, aux chercheurs et aux organisations qui recherchent des fonctionnalités efficaces de gestion de documents et de gestion de documents par questions-réponses. Avec plus de 2 000 développeurs qui ont déjà choisi RLAMA, cet outil s'est avéré fiable sur le marché. Sa valeur ajoutée unique réside dans son caractère open source, qui permet aux utilisateurs de personnaliser et d'adapter l'outil à leurs besoins spécifiques sans engager les coûts élevés liés au développement de RAG personnalisés.

L'un des principaux atouts de RLAMA est son approche « hors ligne », qui garantit que tous les traitements sont effectués localement, sans envoi de données à des serveurs externes. Cette fonctionnalité améliore non seulement la confidentialité, mais aussi les performances en réduisant la latence. De plus, RLAMA prend en charge plusieurs formats de documents, notamment les PDF, Markdown et les fichiers texte, ce qui le rend polyvalent et s'adapte à divers cas d'utilisation. La fonction de segmentation intelligente optimise encore la récupération contextuelle, garantissant aux utilisateurs l'accès aux informations les plus pertinentes de leurs documents.

Les détails techniques de l'implémentation soulignent que RLAMA est disponible pour macOS, Linux et Windows, le rendant accessible à un large éventail d'utilisateurs. L'outil propose également un générateur RAG visuel, permettant aux utilisateurs de créer des systèmes RAG performants en quelques minutes, sans avoir à coder. Cette interface intuitive est conçue pour rendre la création de RAG accessible à tous, quel que soit leur niveau technique. Avec RLAMA, les utilisateurs peuvent espérer gagner du temps et de l'argent en développement tout en créant des systèmes de questions-réponses robustes basés sur des documents.

ggml.ai

Qu'est-ce que ggml.ai?

ggml.ai est à la pointe de la technologie de l'IA, apportant de puissantes capacités d'apprentissage automatique directement à la périphérie grâce à sa bibliothèque de tenseurs innovante. Conçu pour la prise en charge de grands modèles et des performances élevées sur les plates-formes matérielles courantes, ggml.ai permet aux développeurs d'implémenter des algorithmes d'IA avancés sans avoir besoin d'équipement spécialisé. La plate-forme, écrite dans le langage de programmation C efficace, offre une prise en charge de la quantification flottante et entière 16 bits, ainsi que la différenciation automatique et divers algorithmes d'optimisation intégrés comme ADAM et L-BFGS. Il offre des performances optimisées pour Apple Silicon et exploite les intrinsèques AVX/AVX2 sur les architectures x86. Les applications basées sur le Web peuvent également exploiter ses capacités via la prise en charge de WebAssembly et WASM SIMD. Avec ses allocations de mémoire d'exécution nulles et son absence de dépendances tierces, ggml.ai présente une solution minimale et efficace pour l'inférence sur l'appareil.

Des projets tels que Whisper.cpp et Llama.cpp démontrent les capacités d'inférence hautes performances de ggml.ai, Whisper.cpp fournissant des solutions de synthèse vocale et Llama.cpp se concentrant sur l'inférence efficace du grand modèle de langage LLaMA de Meta. De plus, la société accueille favorablement les contributions à sa base de code et prend en charge un modèle de développement open-core via la licence MIT. Alors que ggml.ai continue de se développer, il recherche des développeurs à temps plein talentueux partageant une vision commune de l'inférence sur appareil pour rejoindre son équipe.

Conçu pour repousser les limites de l'IA à la pointe, ggml.ai témoigne de l'esprit de jeu et d'innovation de la communauté de l'IA.

RLAMA Votes positifs

ggml.ai Votes positifs

RLAMA Fonctionnalités principales

Configuration simple : créez et configurez des systèmes RAG avec seulement quelques commandes et une configuration minimale, ce qui permet à chacun de démarrer rapidement.

Plusieurs formats de documents : prend en charge divers formats tels que les PDF, Markdown et les fichiers texte, permettant aux utilisateurs de travailler avec leurs types de documents préférés.

Offline First : garantit un traitement 100 % local sans envoi de données à des serveurs externes, améliorant ainsi la confidentialité et la sécurité des informations sensibles.

Découpage intelligent : segmente automatiquement les documents pour une récupération de contexte optimale, aidant les utilisateurs à trouver efficacement les réponses les plus pertinentes.

Visual RAG Builder : créez des systèmes RAG puissants visuellement en seulement 2 minutes sans écrire de code, les rendant accessibles à tous les utilisateurs.

ggml.ai Fonctionnalités principales

Écrit en C : Garantit des performances élevées et une compatibilité sur une gamme de plates-formes.

Optimisation pour Apple Silicon : Offre un traitement efficace et une latence réduite sur les appareils Apple.

Prise en charge de WebAssembly et WASM SIMD : Facilite l'utilisation des applications Web par les capacités d'apprentissage automatique.

Aucune dépendance tierce : Permet une base de code épurée et un déploiement pratique.

Prise en charge de la sortie linguistique guidée : Améliore l'interaction homme-machine avec des réponses plus intuitives générées par l'IA.

RLAMA Catégorie

- Large Language Model (LLM)

ggml.ai Catégorie

- Large Language Model (LLM)

RLAMA Type de tarification

- Free

ggml.ai Type de tarification

- Freemium