ggml.ai vs Sanctum

Compare ggml.ai vs Sanctum e veja qual ferramenta AI Large Language Model (LLM) é melhor quando comparamos recursos, avaliações, preços, alternativas, votos positivos, etc.

Qual é melhor? ggml.ai ou Sanctum?

Quando comparamos ggml.ai com Sanctum, ambas ferramentas são alimentadas por inteligência artificial na categoria de large language model (llm), Com mais votos positivos, Sanctum é a escolha preferida. Sanctum atraiu 8 votos positivos dos usuários da aitools.fyi, e ggml.ai atraiu 6 votos positivos.

Não é a sua praia? Vote em sua ferramenta preferida e mexa as coisas!

ggml.ai

O que é ggml.ai?

ggml.ai está na vanguarda da tecnologia de IA, trazendo poderosos recursos de aprendizado de máquina diretamente para o limite com sua inovadora biblioteca de tensores. Construído para suporte a grandes modelos e alto desempenho em plataformas de hardware comuns, ggml.ai permite que os desenvolvedores implementem algoritmos avançados de IA sem a necessidade de equipamento especializado. A plataforma, escrita na eficiente linguagem de programação C, oferece suporte para flutuação de 16 bits e quantização de inteiros, juntamente com diferenciação automática e vários algoritmos de otimização integrados, como ADAM e L-BFGS. Possui desempenho otimizado para Apple Silicon e aproveita os intrínsecos AVX/AVX2 em arquiteturas x86. Os aplicativos baseados na Web também podem explorar seus recursos por meio do suporte WebAssembly e WASM SIMD. Com zero alocações de memória em tempo de execução e ausência de dependências de terceiros, ggml.ai apresenta uma solução mínima e eficiente para inferência no dispositivo.

Projetos como whisk.cpp e llama.cpp demonstram os recursos de inferência de alto desempenho do ggml.ai, com o whisker.cpp fornecendo soluções de fala para texto e o llama.cpp focando na inferência eficiente do modelo de linguagem grande LLaMA da Meta. Além disso, a empresa aceita contribuições para a sua base de código e apoia um modelo de desenvolvimento de núcleo aberto através da licença MIT. À medida que a ggml.ai continua a se expandir, ela procura desenvolvedores talentosos em tempo integral com uma visão compartilhada de inferência no dispositivo para se juntarem à sua equipe.

Projetado para ir além dos limites da IA, ggml.ai é uma prova do espírito de diversão e inovação na comunidade de IA.

Sanctum

O que é Sanctum?

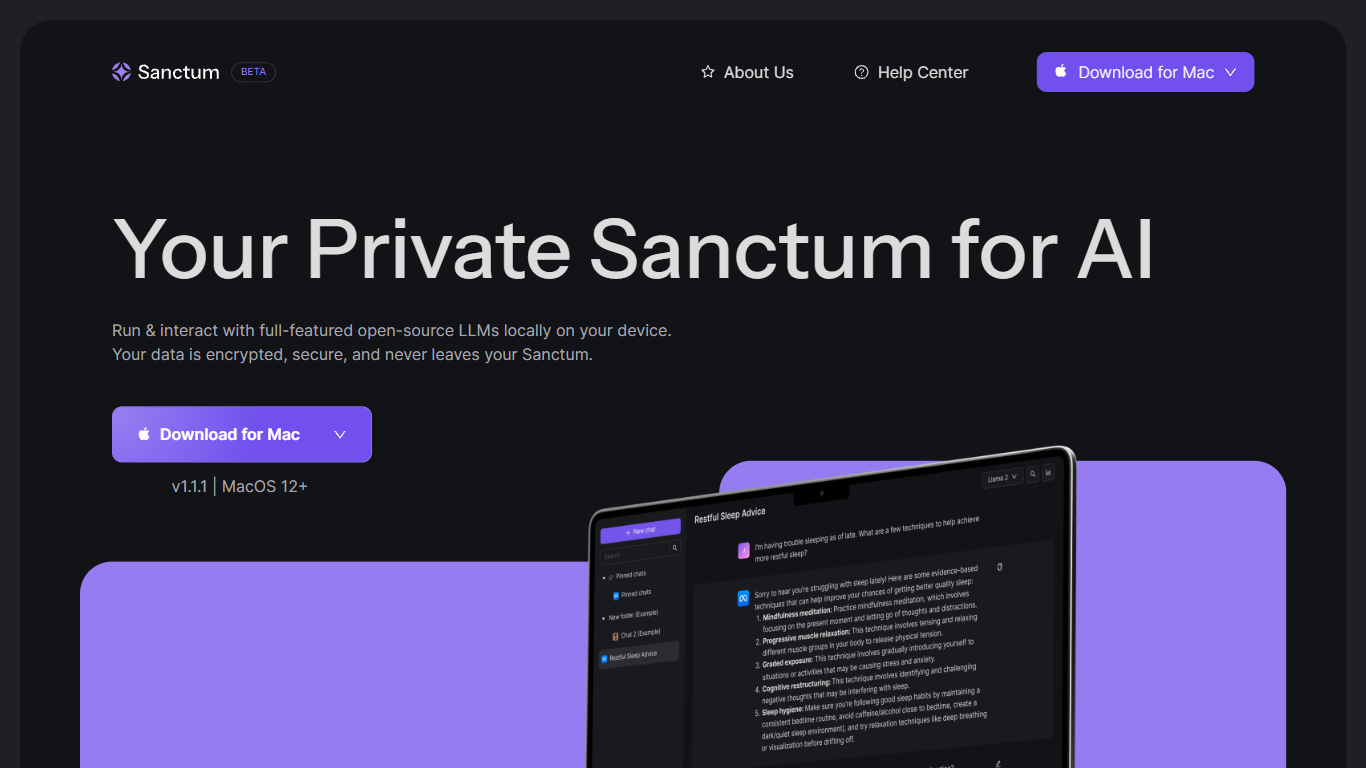

Apresentando o Sanctum, seu assistente privado de IA local que traz a sofisticação da IA diretamente à sua área de trabalho com a máxima privacidade e conveniência. Otimizado para o MacOS 12+ com suporte para processadores Apple Silicon e Intel, o Sanctum é uma ferramenta inovadora que permite que você funcione e interaja com os modelos de linguagem de grande porte de código aberto ricos em recursos (LLMS) diretamente em sua máquina local. Esqueça a nuvem - seus dados são criptografados, seguros e permanecem dentro dos limites do seu dispositivo, fornecendo privacidade incomparável. Seja para uso pessoal, tarefas sensíveis a dados ou projetos de desenvolvimento, o Sanctum adota uma abordagem de privacidade para garantir que suas interações de IA permaneçam suas. Com uma versão móvel antecipada e atualizações futuras, como suporte adicional de modelo e compatibilidade com várias plataformas, o Santum promete estar na vanguarda das ferramentas de IA acessíveis e seguras.

ggml.ai Votos positivos

Sanctum Votos positivos

ggml.ai Recursos principais

Escrito em C: Garante alto desempenho e compatibilidade em diversas plataformas.

Otimização para Apple Silicon: oferece processamento eficiente e menor latência em dispositivos Apple.

Suporte para WebAssembly e WASM SIMD: Facilita que aplicativos Web utilizem recursos de aprendizado de máquina.

Sem dependências de terceiros: Proporciona uma base de código organizada e uma implantação conveniente.

Suporte de saída de idioma guiado: Melhora a interação humano-computador com respostas mais intuitivas geradas por IA.

Sanctum Recursos principais

Execute IA localmente em seu dispositivo: aproveite os benefícios da IA avançada sem a necessidade de conectividade com a Internet depois que o Sanctum estiver instalado.

Criptografia de dados que prioriza a privacidade: fique tranquilo, pois seus dados são criptografados e processados no seu Mac, mantendo sua privacidade e controle.

Troca de modelo sem atrito: alterne facilmente entre diferentes modelos de código aberto para encontrar aquele que melhor atende às suas necessidades.

Casos de uso diversos: Use o Sanctum para analisar dados pessoais e financeiros, fazer brainstorming, criar conteúdo e muito mais, tudo isso mantendo a privacidade de suas informações.

Atualizações preparadas para o futuro: fique à frente dos próximos recursos, como suporte para modelos adicionais de aprendizado de máquina personalizado e recursos multiplataforma (IOS Android Windows Linux).

ggml.ai Categoria

- Large Language Model (LLM)

Sanctum Categoria

- Large Language Model (LLM)

ggml.ai Tipo de tarifação

- Freemium

Sanctum Tipo de tarifação

- Freemium