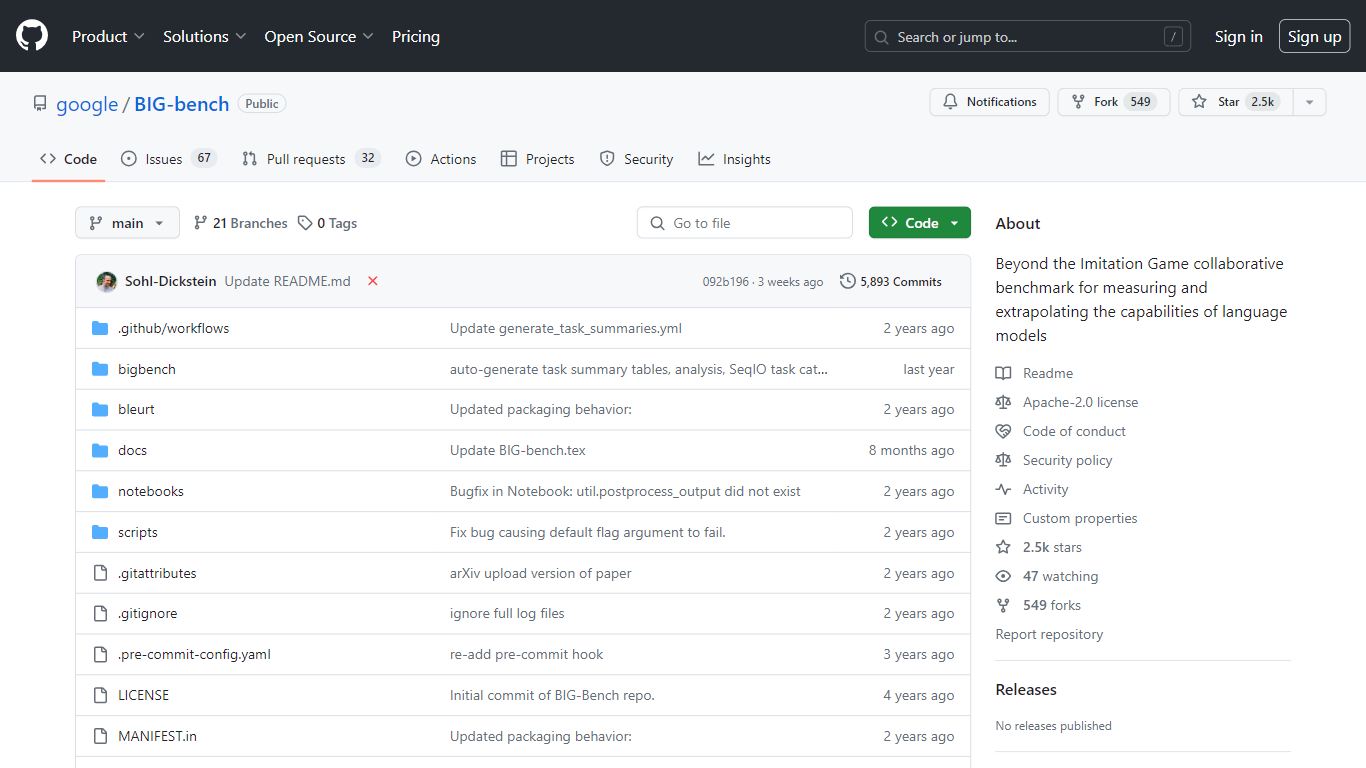

BIG-bench

GitHub 上提供的 Google BIG-bench 项目提供了一个名为 Beyond the Imitation Game (BIG-bench) 的开创性基准系统,致力于评估和理解语言模型当前和潜在的未来功能。 BIG-bench 是一项开放式协作计划,包括 200 多项不同的任务,满足语言理解和认知能力各个方面的需求。

任务是有组织的,可以通过关键字或任务名称进行探索。感兴趣的人可以公开获取讨论该基准及其对著名语言模型评估的科学预印本。该基准测试是研究人员和开发人员的重要资源,旨在衡量语言模型的性能并推断其发展轨迹。有关基准测试的更多详细信息,包括有关任务创建、模型评估和常见问题解答的说明,可以参阅 GitHub 存储库上提供的该项目的大量文档。

主要功能:

**协作基准测试:**旨在挑战和衡量语言模型的广泛任务。

广泛的任务集合: 超过 200 个任务可用于全面测试语言模型的各个方面。

BIG-bench Lite 排行榜: 基准测试的精简版本,提供模型性能的规范衡量标准,同时降低评估成本。

开源贡献: 促进社区贡献和对基准套件的改进。

全面的文档: 有关任务创建、模型评估和基准参与的详细指导。

常见问题:

什么是大板凳?

BIG-bench,即超越模仿游戏基准,是一个用于测量和推断语言模型能力的协作基准。

BIG-bench 中包含多少个任务?

BIG-bench 包含 200 多个任务来评估语言模型的各个方面。

BIG-bench Lite 的用途是什么?

BIG-bench Lite 是 BIG-bench 任务的子集,旨在提供模型性能的规范衡量标准,同时使评估更具成本效益。

如何为 BIG-bench 做出贡献?

可以通过添加新任务、提交模型评估或通过 GitHub 增强现有基准套件来做出贡献。

在哪里可以找到 BIG-bench 任务和结果?

任务和结果可以在 BIG-bench GitHub 存储库中找到,其中包含详细说明和排行榜的链接。

定价:

免费试用和收费混合

标签:

Language Models

Benchmarking

AI Research

Open Source

Model Performance

GitHub