fastchat 对比 ggml.ai

在比较 fastchat 和 ggml.ai 时,哪个 AI Large Language Model (LLM) 工具更出色?我们看看定价、替代品、赞成票、功能、评论等等。

在 fastchat 和 ggml.ai 的比较中,哪一个脱颖而出?

当我们将fastchat和ggml.ai并排放置时,这两个都是AI驱动的large language model (llm)工具, 点赞数显示平局,两种工具获得的点赞数相同。 由于其他 aitools.fyi 用户可能决定获胜者,现在轮到你投票并帮助我们决定获胜者了。

认为我们错了?投票并向我们展示谁才是老大!

fastchat

什么是 fastchat?

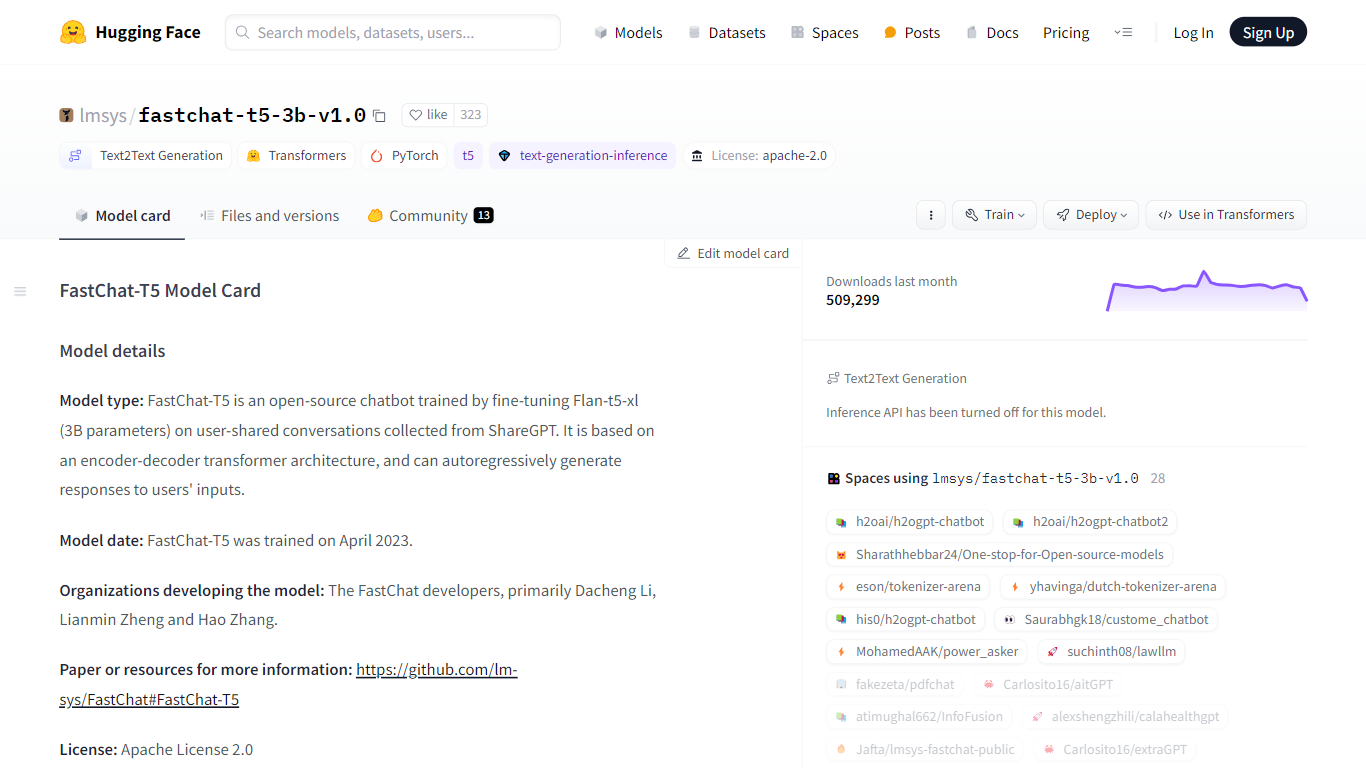

lmsys/fastchat-t5-3b-v1.0 模型托管在 Hugging Face 平台上,是一种尖端的人工智能解决方案,旨在将聊天机器人交互的流畅性和连贯性提升到新的高度。该模型是利用 Flan-T5 的强大功能创建的,具有惊人的 30 亿个参数,并根据来自 ShareGPT 的对话进行了微调。它不仅为开发用于商业应用的动态和响应式聊天机器人提供了无可挑剔的基础,而且还是研究人员深入研究自然语言处理和机器学习复杂性的重要资源。该模型由李大成、郑连民和张浩领导的 FastChat 团队于 2023 年 4 月开发,通过实现编码器-解码器转换器架构,实现了无与伦比的语言理解和生成能力。

它经过了 70,000 个对话数据集的精心训练,确保了对各种提示和查询的广泛理解。该模型经过了严格的测试,包括使用 GPT-4 进行的初步评估,展示了其提供信息丰富且对话相关响应的潜力。由于其在 Apache 2.0 许可证下的开源状态,该模型邀请协作和创新,使其成为开放科学和人工智能民主化的灯塔。

ggml.ai

什么是 ggml.ai?

ggml.ai 处于人工智能技术的前沿,通过其创新的张量库将强大的机器学习功能直接带到边缘。 ggml.ai 专为通用硬件平台上的大型模型支持和高性能而构建,使开发人员能够实现先进的人工智能算法,而无需专门的设备。该平台采用高效的 C 编程语言编写,提供 16 位浮点和整数量化支持,以及自动微分和各种内置优化算法(如 ADAM 和 L-BFGS)。它拥有针对 Apple Silicon 的优化性能,并在 x86 架构上利用 AVX/AVX2 内在函数。基于 Web 的应用程序还可以通过 WebAssembly 和 WASM SIMD 支持来利用其功能。凭借零运行时内存分配和不存在第三方依赖项,ggml.ai 为设备上推理提供了一种最小且高效的解决方案。

诸如whisper.cpp和llama.cpp之类的项目展示了ggml.ai的高性能推理能力,其中whisper.cpp提供语音到文本的解决方案,llama.cpp专注于Meta的LLaMA大语言模型的高效推理。此外,该公司欢迎对其代码库做出贡献,并通过 MIT 许可证支持开放核心开发模型。随着 ggml.ai 的不断扩张,它正在寻找对设备上推理有共同愿景的有才华的全职开发人员加入他们的团队。

ggml.ai 旨在突破边缘人工智能的极限,证明了人工智能社区的游戏和创新精神。

fastchat 赞同数

ggml.ai 赞同数

fastchat 顶级功能

模型架构: 采用 Flan-t5-xl 的编码器-解码器变压器架构的开源聊天机器人。

训练数据: 对ShareGPT收集的70K对话进行微调,实现多样化交互。

开发团队: 由 FastChat 开发人员李大成、郑连民和张浩打造,实现最先进的语言处理。

商业和研究应用: 非常适合对 NLP、ML 和 AI 感兴趣的企业家和研究人员。

许可证和访问: 通过 Apache License 2.0 促进开源开发的可访问性和创新。

ggml.ai 顶级功能

用 C 编写: 确保跨各种平台的高性能和兼容性。

针对 Apple Silicon 的优化: 在 Apple 设备上提供高效的处理和更低的延迟。

支持 WebAssembly 和 WASM SIMD: 促进 Web 应用程序利用机器学习功能。

没有第三方依赖项: 实现整洁的代码库和方便的部署。

引导语言输出支持: 通过更直观的 AI 生成响应来增强人机交互。

fastchat 类别

- Large Language Model (LLM)

ggml.ai 类别

- Large Language Model (LLM)

fastchat 定价类型

- Freemium

ggml.ai 定价类型

- Freemium