StableLM 对比 ggml.ai

在 StableLM 和 ggml.ai 的对决中,哪个 AI Large Language Model (LLM) 工具脱颖而出?我们评估评论、定价、替代品、功能、赞成票等等。

当我们把 StableLM 和 ggml.ai 放在一起时,哪一个会成为胜利者?

让我们仔细看看StableLM和ggml.ai,两者都是AI驱动的large language model (llm)工具,看看它们有什么不同。 StableLM 和 ggml.ai 的点赞数不相上下。 由于其他 aitools.fyi 用户可能决定获胜者,现在轮到你投票并帮助我们决定获胜者了。

不同意结果?投票并参与决策过程!

StableLM

什么是 StableLM?

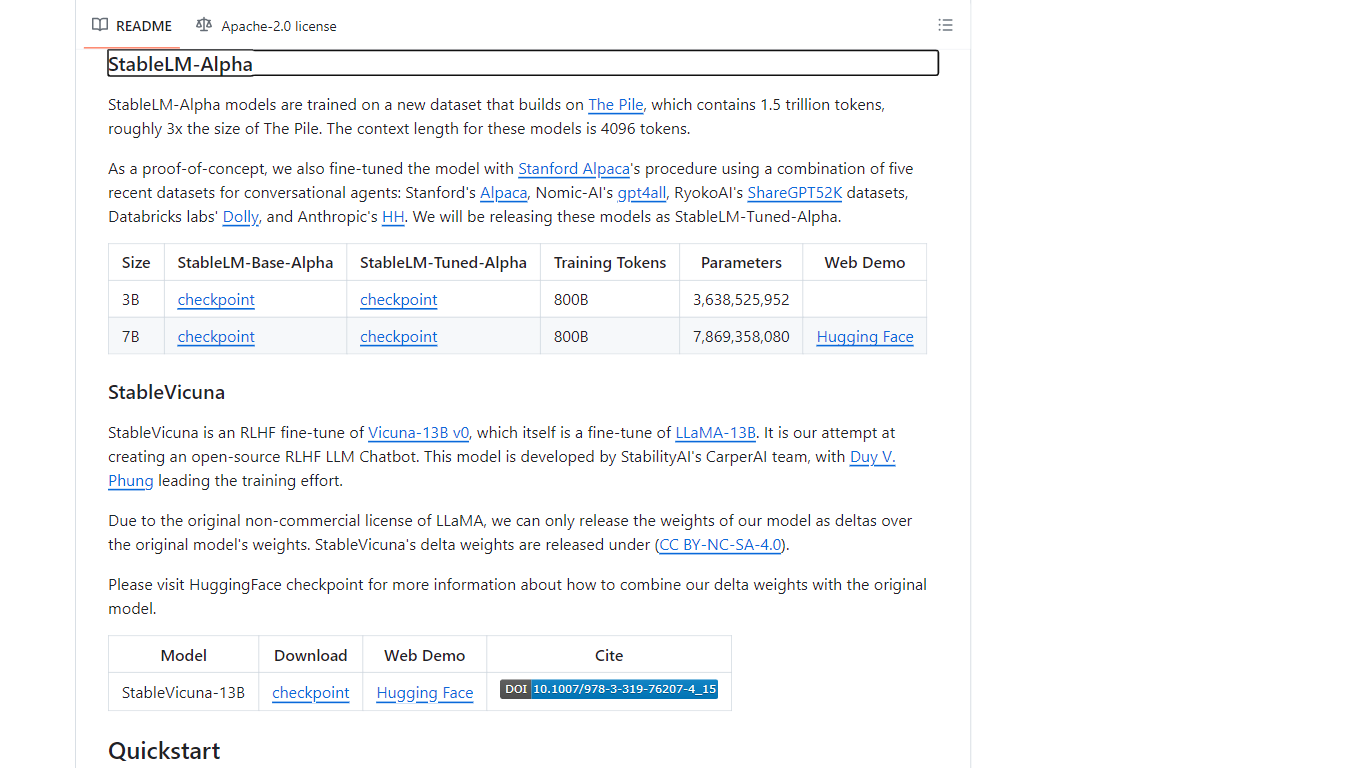

StableLM 是 Stability AI 提供的一套语言模型,旨在增强人工智能理解和生成类人文本的能力和有效性。这些语言模型可在 GitHub 上访问,为开发人员提供了将先进的人工智能语言处理集成到其应用程序中的工具。通过使用大量数据训练的模型,用户可以在各种 NLP 任务中获得强大的性能。通过为其持续开发做出贡献来加入 StableLM 社区,确保在 GitHub 上创建一个帐户,以便开始与 AI 领域的专家和爱好者合作。

ggml.ai

什么是 ggml.ai?

ggml.ai 处于人工智能技术的前沿,通过其创新的张量库将强大的机器学习功能直接带到边缘。 ggml.ai 专为通用硬件平台上的大型模型支持和高性能而构建,使开发人员能够实现先进的人工智能算法,而无需专门的设备。该平台采用高效的 C 编程语言编写,提供 16 位浮点和整数量化支持,以及自动微分和各种内置优化算法(如 ADAM 和 L-BFGS)。它拥有针对 Apple Silicon 的优化性能,并在 x86 架构上利用 AVX/AVX2 内在函数。基于 Web 的应用程序还可以通过 WebAssembly 和 WASM SIMD 支持来利用其功能。凭借零运行时内存分配和不存在第三方依赖项,ggml.ai 为设备上推理提供了一种最小且高效的解决方案。

诸如whisper.cpp和llama.cpp之类的项目展示了ggml.ai的高性能推理能力,其中whisper.cpp提供语音到文本的解决方案,llama.cpp专注于Meta的LLaMA大语言模型的高效推理。此外,该公司欢迎对其代码库做出贡献,并通过 MIT 许可证支持开放核心开发模型。随着 ggml.ai 的不断扩张,它正在寻找对设备上推理有共同愿景的有才华的全职开发人员加入他们的团队。

ggml.ai 旨在突破边缘人工智能的极限,证明了人工智能社区的游戏和创新精神。

StableLM 赞同数

ggml.ai 赞同数

StableLM 顶级功能

尖端人工智能模型: StableLM 系列包括复杂的语言模型,具有多达数十亿个参数,可实现深入的语言理解。

开源协作: 加入开发者社区,为 GitHub 上的项目做出贡献,以推动人工智能领域的集体进步。

持续更新: Stability AI 致力于定期更新 StableLM 项目的新模型和改进。

研究驱动的开发: StableLM 的方法基于最新研究,以确保模型具有最先进的性能。

**可访问性和许可:**模型根据知识共享和开源许可证发布,使其可供广泛使用。

ggml.ai 顶级功能

用 C 编写: 确保跨各种平台的高性能和兼容性。

针对 Apple Silicon 的优化: 在 Apple 设备上提供高效的处理和更低的延迟。

支持 WebAssembly 和 WASM SIMD: 促进 Web 应用程序利用机器学习功能。

没有第三方依赖项: 实现整洁的代码库和方便的部署。

引导语言输出支持: 通过更直观的 AI 生成响应来增强人机交互。

StableLM 类别

- Large Language Model (LLM)

ggml.ai 类别

- Large Language Model (LLM)

StableLM 定价类型

- Freemium

ggml.ai 定价类型

- Freemium