RWKV-LM

RWKV 是一种基于 RNN 的创新语言模型,可提供 Transformer 级大型语言模型 (LLM) 的卓越性能。 RNN 简单性与变压器效率的显着融合创建了一个高度并行化的模型,类似于 GPT 模型。 RWKV 不仅推理速度快,而且训练速度快,同时内存效率高,从而节省了宝贵的 VRAM。

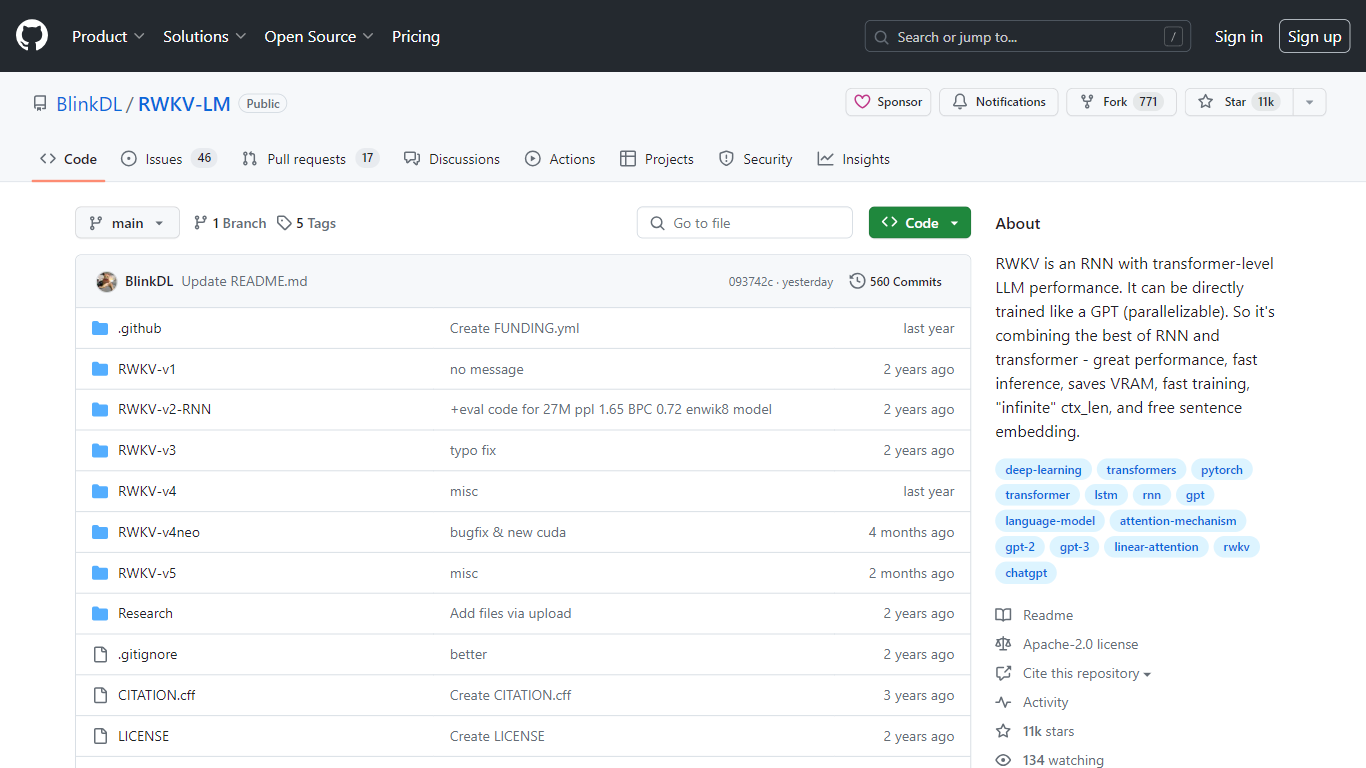

它支持“无限”上下文长度,使其能够无缝处理非常长的数据序列。此外,用户还可以从免费的句子嵌入功能中受益,从而增强其在各种自然语言处理应用程序中的实用性。作为 Apache-2.0 许可项目,它作为 GitHub 上的公共存储库,邀请协作和持续开发。

主要功能:

出色的性能: 在更紧凑的 RNN 架构中提供变压器级 LLM 性能。

快速推理: 专为快速响应而设计,使其适合实时应用程序。

VRAM 节省: 经过优化,可在不影响效率的情况下利用更少的 VRAM。

快速训练: 能够快速训练,减少开发稳健模型所需的时间。

无限上下文长度: 可容纳极长的序列,为处理大量数据提供灵活性。

常见问题:

什么是 RWKV?

RWKV 是一种具有 Transformer 级大型语言模型高性能的 RNN(循环神经网络)。

RWKV 可以并行训练吗?

是的,RWKV 支持并行训练,类似于 GPT 模型,使其高效且省时。

RWKV 相对于传统 RNN 的主要优点是什么?

RWKV 在性能、快速推理、节省 VRAM、快速训练、处理“无限”上下文长度以及提供免费句子嵌入方面表现出色。

RWKV 中“无限”上下文长度意味着什么?

RWKV 的“无限”上下文长度是指它能够处理非常长的数据序列,而没有其他模型中的典型限制。

RWKV 如何融入语言建模领域?

RWKV 结合了 RNN 和 Transformer 的优点,使其成为执行需要理解和生成人类语言的任务的强大工具。

定价:

免费

标签:

RNN

Transformer-Level Performance

Parallelizable Training

VRAM Efficient

Infinite Context Length