UniLM

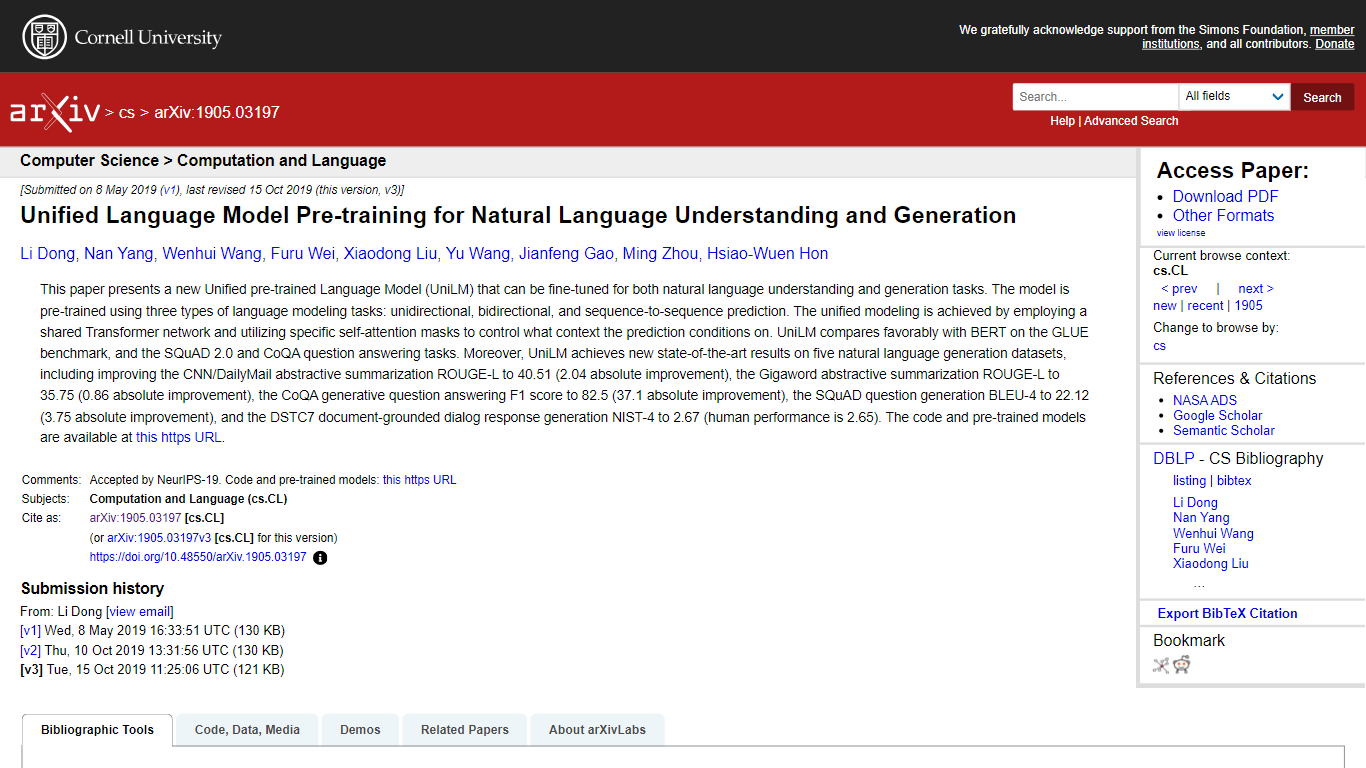

本文介绍了 UniLM,一种统一的预训练语言模型,它可以作为自然语言理解(NLU)和自然语言生成(NLG)任务的新基准。它的独特之处在于使用了共享 Transformer 网络,该网络在单向、双向和序列到序列任务上进行了预训练,并采用特殊的自注意力掩码进行上下文预测控制。 UniLM 在 GLUE 基准测试中优于 BERT,在 SQuAD 2.0 和 CoQA 问答中表现出色,在五个 NLG 数据集中创造了新记录,包括在 CNN/DailyMail 和 Gigaword 摘要任务中的显着改进。作者共享的模型和代码有助于研究社区取得进一步的进展。

主要功能:

全面的预训练: UniLM 针对单向、双向和序列到序列语言建模任务进行了预训练。

双用途设计: 针对自然语言理解和生成进行了优化,使其成为 NLP 中的多功能工具。

卓越的自注意力控制: 共享 Transformer 网络中独特的自注意力掩码允许特定于上下文的预测。

基准卓越: 在多个基准上取得了最先进的结果,超越了 BERT 等之前的模型。

开源贡献: 作者提供预训练模型和代码的访问权限,以供社区使用和改进。

常见问题:

什么是大学LM?

UniLM 代表统一预训练语言模型,专为自然语言理解和生成任务而设计。

UniLM 是如何预训练的?

该模型使用单向、双向和序列到序列语言建模任务进行预训练。

UniLM 的性能比 BERT 更好吗?

是的,UniLM 在 GLUE 基准以及 SQuAD 2.0 和 CoQA 问答任务上优于 BERT。

UniLM取得了哪些成就?

在五个 NLG 数据集上取得了最新的成果,包括 CNN/DailyMail 和 Gigaword 摘要任务的改进。

在哪里可以找到 UniLM 的代码和预训练模型?

您可以在作者提供的 GitHub 存储库中访问代码和预训练模型。

定价:

免费试用和收费混合

标签:

Natural Language Understanding

Natural Language Generation

Pre-trained Language Model

Transformer Network

Self-Attention Masks

GLUE Benchmark

SQuAD 2.0

CoQA

Question Answering

Text Summarization

NeurIPS