ALBERT vs ggml.ai

Sumérgete en la comparación de ALBERT vs ggml.ai y descubre cuál herramienta AI Large Language Model (LLM) se destaca. Analizamos alternativas, votos positivos, características, opiniones, precios, y más.

Al comparar ALBERT y ggml.ai, ¿cuál se destaca por encima del otro?

Al comparar ALBERT y ggml.ai, dos herramientas excepcionales de la categoría de large language model (llm) impulsadas por inteligencia artificial, y colocarlas lado a lado, se destacan varias similitudes y diferencias clave. El conteo de votos positivos está muy parejo para tanto ALBERT como ggml.ai. ¡El poder está en tus manos! Emite tu voto y participa en la decisión del ganador.

¿Quieres cambiar la historia? ¡Vota por tu herramienta favorita y cambia el juego!

ALBERT

¿Qué es ALBERT?

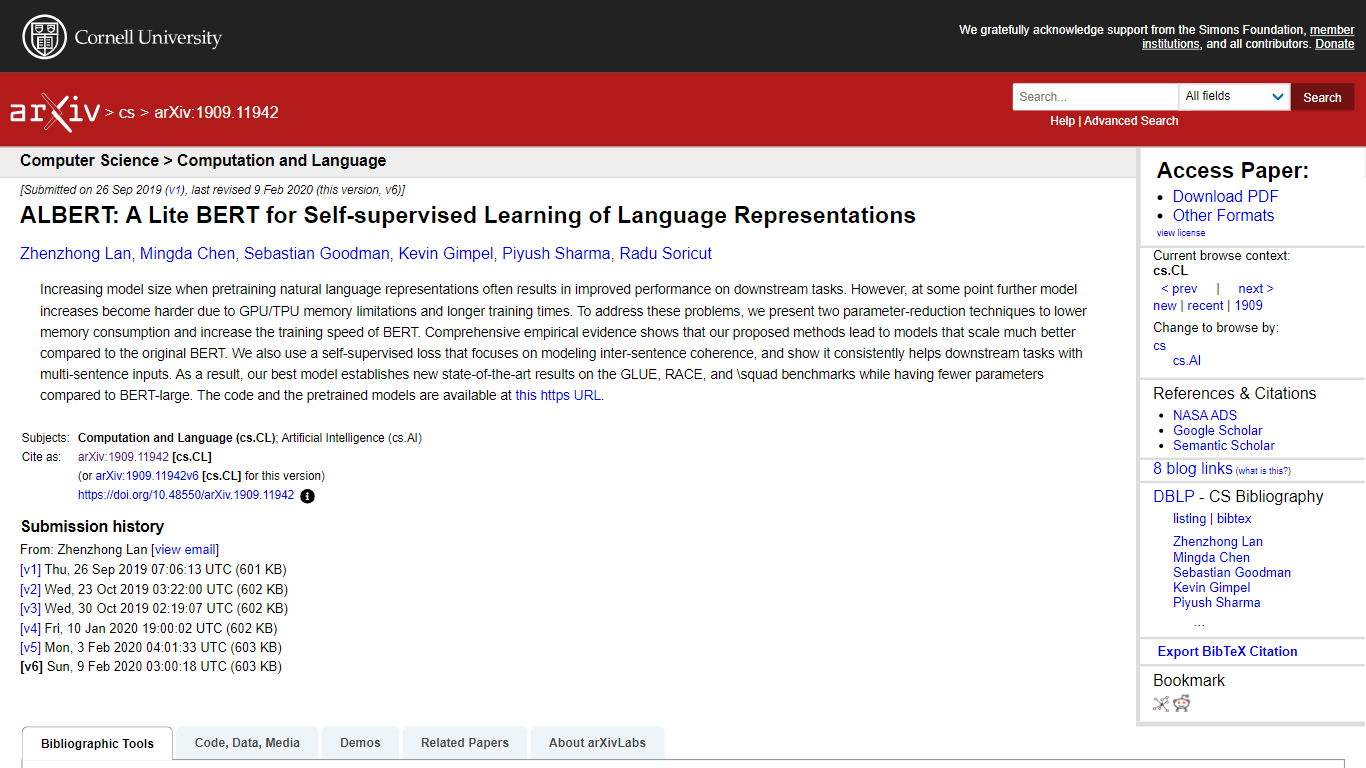

ALBERT, abreviatura de "A Lite BERT", es una versión optimizada del modelo BERT ampliamente utilizado para tareas de procesamiento del lenguaje natural. Presentado en el artículo arXiv por Zhenzhong Lan y sus colegas, ALBERT ofrece dos técnicas de reducción de parámetros que disminuyen significativamente el consumo de memoria y aumentan la velocidad de entrenamiento de BERT sin sacrificar el rendimiento.

Este avance aborda el desafío de las limitaciones de memoria de GPU/TPU y los tiempos de entrenamiento típicamente prolongados asociados con el aumento del tamaño de los modelos. El artículo demuestra a través de evidencia empírica que ALBERT no solo se desempeña mejor que BERT en una variedad de puntos de referencia, como GLUE, RACE y SQuAD, sino que también logra resultados de vanguardia con un menor número de parámetros. La investigación introduce además una función de pérdida autosupervisada que mejora la capacidad del modelo para comprender la coherencia entre oraciones, lo que lleva a una mejora sustancial en las tareas que requieren entradas de varias oraciones. Los autores proporcionan el código y los modelos previamente entrenados para ALBERT, haciéndolos accesibles para un uso generalizado en la comunidad de PNL.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

ALBERT Votos positivos

ggml.ai Votos positivos

ALBERT Características principales

Técnicas de reducción de parámetros: Técnicas que reducen el consumo de memoria y aumentan la velocidad de entrenamiento de BERT.

Escalado del modelo mejorado: ALBERT escala mejor que el BERT original, incluso con menos parámetros.

Rendimiento de última generación: Los logros incluyen nuevas puntuaciones altas en los puntos de referencia GLUE, RACE y SQuAD.

Función de pérdida autosupervisada: Una función de pérdida novedosa que mejora el modelado de la coherencia entre oraciones.

Modelos de código abierto: Los modelos previamente entrenados y el código base están disponibles públicamente para uso de la comunidad.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

ALBERT Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

ALBERT Tipo de tarificación

- Freemium

ggml.ai Tipo de tarificación

- Freemium