ELECTRA vs ggml.ai

Explora el enfrentamiento entre ELECTRA vs ggml.ai y descubre qué herramienta AI Large Language Model (LLM) gana. Analizamos votos positivos, características, opiniones, precios, alternativas, y más.

En un enfrentamiento entre ELECTRA y ggml.ai, ¿cuál se lleva la corona?

Al contrastar ELECTRA con ggml.ai, ambas son herramientas excepcionales operadas por inteligencia artificial en la categoría de large language model (llm), y al colocarlas lado a lado, podemos notar varias similitudes y divergencias cruciales. El conteo de votos positivos revela un empate, con ambas herramientas obteniendo la misma cantidad de votos positivos. ¡El poder está en tus manos! Emite tu voto y participa en la decisión del ganador.

¿Crees que nos equivocamos? ¡Emite tu voto y muéstranos quién manda!

ELECTRA

¿Qué es ELECTRA?

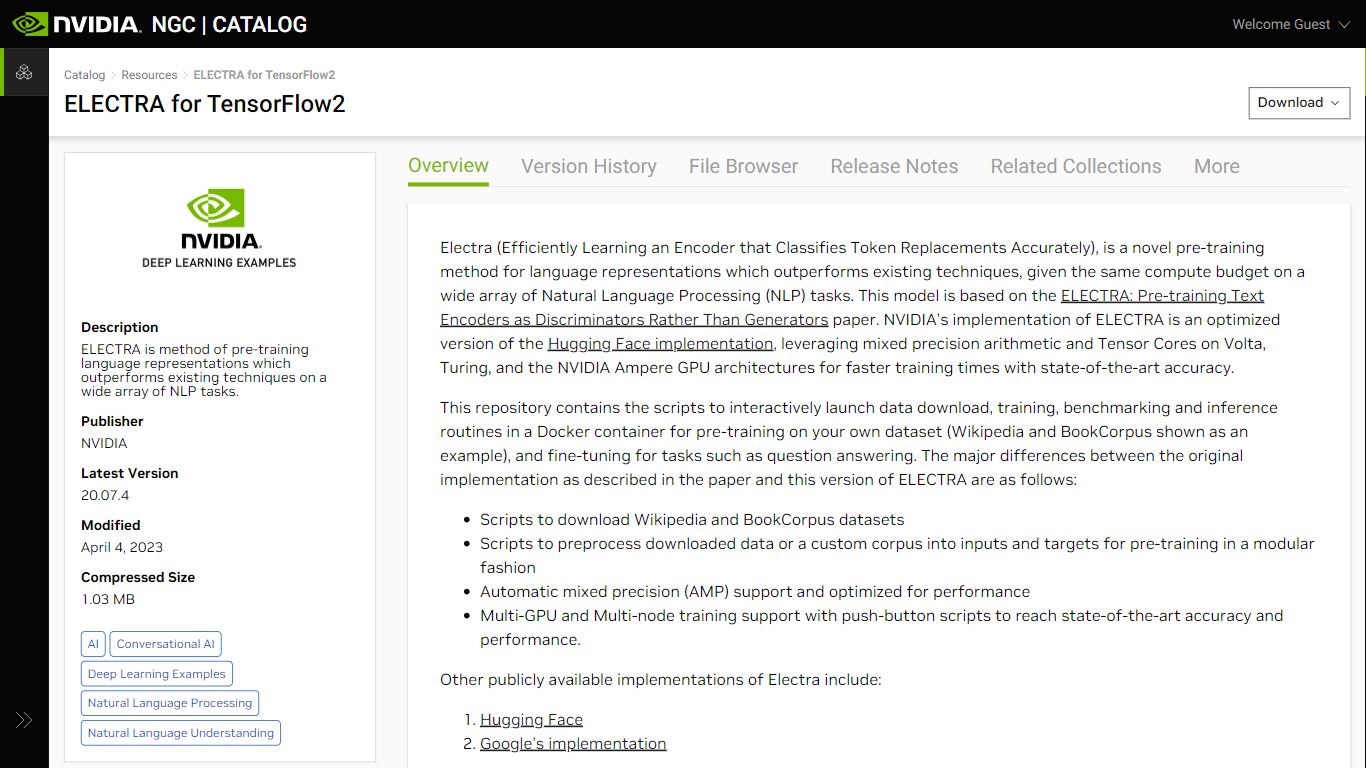

ELECTRA para TensorFlow2, disponible en NVIDIA NGC, representa un gran avance en la representación del lenguaje previo al entrenamiento para tareas de procesamiento del lenguaje natural (NLP). Al aprender de manera eficiente un codificador que clasifica los reemplazos de tokens con precisión, ELECTRA supera los métodos existentes dentro del mismo presupuesto computacional en varias aplicaciones de PNL. Desarrollado sobre la base de un artículo de investigación, este modelo se beneficia significativamente de las optimizaciones proporcionadas por NVIDIA, como la aritmética de precisión mixta y el uso de Tensor Core en las arquitecturas de GPU Volta, Turing y NVIDIA Ampere. No sólo logra tiempos de entrenamiento más rápidos sino que también garantiza una precisión de última generación.

Al comprender la arquitectura, ELECTRA se diferencia de los modelos convencionales como BERT al introducir un marco generador-discriminador que identifica los reemplazos de tokens de manera más eficiente, un enfoque inspirado en las redes generativas adversarias (GAN). Esta implementación es fácil de usar y ofrece scripts para descarga de datos, preprocesamiento, capacitación, evaluación comparativa e inferencia, lo que facilita a los investigadores trabajar con conjuntos de datos personalizados y ajustar tareas que incluyen la respuesta a preguntas.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

ELECTRA Votos positivos

ggml.ai Votos positivos

ELECTRA Características principales

Soporte de precisión mixta: velocidad de entrenamiento mejorada utilizando aritmética de precisión mixta en arquitecturas de GPU NVIDIA compatibles.

Entrenamiento de múltiples GPU y múltiples nodos: admite el entrenamiento distribuido en múltiples GPU y nodos, lo que facilita un desarrollo de modelos más rápido.

Secuencias de comandos de preentrenamiento y ajuste fino: Incluye secuencias de comandos para descargar y preprocesar conjuntos de datos, lo que permite una configuración sencilla para los procesos de preentrenamiento y ajuste fino.

Arquitectura de modelo avanzada: integra un esquema generador-discriminador para un aprendizaje más eficaz de las representaciones del lenguaje.

Rendimiento optimizado: aprovecha las optimizaciones para Tensor Cores y Automatic Mixed Precision (AMP) para un entrenamiento acelerado de modelos.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

ELECTRA Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

ELECTRA Tipo de tarificación

- Freemium

ggml.ai Tipo de tarificación

- Freemium