Inkpunk-Diffusion on Hugging Face vs Drag Your GAN

En la batalla de Inkpunk-Diffusion on Hugging Face vs Drag Your GAN, ¿cuál herramienta AI Image Generation Model sale victoriosa? Comparamos opiniones, precios, alternativas, votos positivos, características, y más.

Entre Inkpunk-Diffusion on Hugging Face y Drag Your GAN, ¿cuál es superior?

Al comparar Inkpunk-Diffusion on Hugging Face con Drag Your GAN, ambas herramientas son impulsadas por inteligencia artificial en la categoría de image generation model, Los usuarios han dejado clara su preferencia, Drag Your GAN lidera en votos positivos. El conteo de votos positivos para Drag Your GAN es de 8, y para Inkpunk-Diffusion on Hugging Face es de 6.

¿Te sientes rebelde? ¡Emite tu voto y sacude las cosas!

Inkpunk-Diffusion on Hugging Face

¿Qué es Inkpunk-Diffusion on Hugging Face?

Embárcate en un viaje innovador con Envvi/Inkpunk-Diffusion, donde la fusión del arte y la IA abre la puerta a una creatividad ilimitada. Nuestra plataforma ofrece una función única de conversión de texto a imagen impulsada por un modelo de difusión estable ajustado, Inkpunk-Diffusion, meticulosamente entrenado en Dreambooth. Inspirándose en estilos icónicos como Gorillaz y Yoji Shinkawa, Inkpunk-Diffusion invita a artistas y creadores a explorar paradigmas visuales novedosos. Al integrarnos con Gradio, proporcionamos una interfaz de usuario web fácil de usar que simplifica el proceso de dar vida a sus indicaciones imaginativas, garantizando accesibilidad y facilidad de uso para todos los usuarios. Con una sólida API de inferencia y la capacidad de descargar miles de imágenes de muestra, Inkpunk-Diffusion está a la vanguardia de la democratización y el avance de la inteligencia artificial en el campo de la ciencia abierta.

Drag Your GAN

¿Qué es Drag Your GAN?

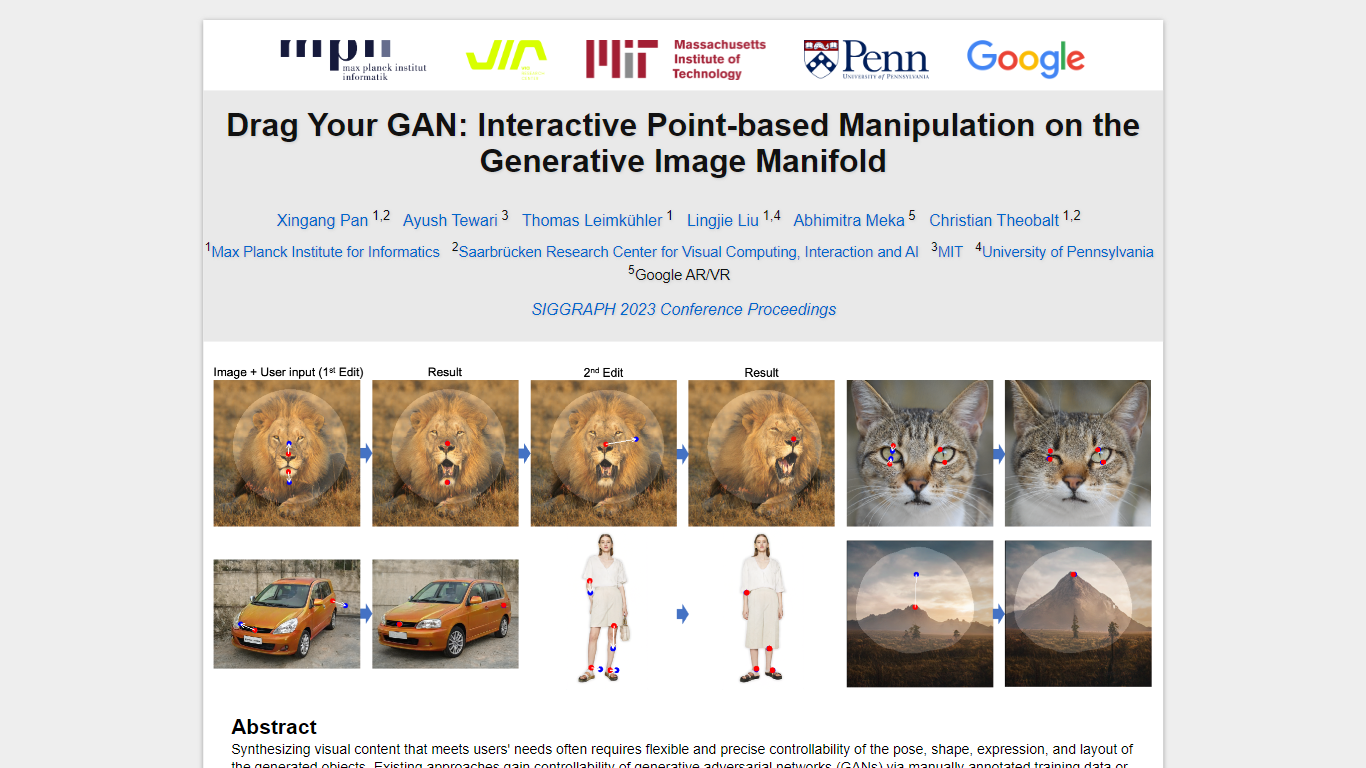

En el ámbito de la sintetización de contenido visual para satisfacer las necesidades de los usuarios, es esencial lograr un control preciso sobre la pose, la forma, la expresión y el diseño de los objetos generados. Los enfoques tradicionales para controlar las redes adversas generativas (GAN) se han basado en anotaciones manuales durante la capacitación o modelos 3D anteriores, a menudo carecen de la flexibilidad, la precisión y la versatilidad requeridas para diversas aplicaciones.

En nuestra investigación, exploramos un método innovador y relativamente desconocido para el control de GaN, la capacidad de "arrastrar" puntos de imagen específicos para alcanzar con precisión los puntos objetivo definidos por el usuario de manera interactiva (como se ilustra en la Fig.1). Este enfoque ha llevado al desarrollo de Draggan, un marco novedoso que comprende dos componentes centrales:

Supervisión de movimiento basada en características: este componente guía los puntos de manejo dentro de la imagen hacia sus posiciones objetivo previstas a través de la supervisión de movimiento basada en características.

Seguimiento de puntos: aprovechando las características discriminativas de GaN, nuestra nueva técnica de seguimiento de puntos localiza continuamente la posición de los puntos de manejo.

Draggan faculta a los usuarios para deformar las imágenes con notable precisión, permitiendo la manipulación de la pose, la forma, la expresión y el diseño en diversas categorías, como animales, automóviles, humanos, paisajes y más. Estas manipulaciones tienen lugar dentro del colector de imágenes generativas aprendidas de un GaN, lo que resulta en resultados realistas, incluso en escenarios complejos como generar contenido ocluido y formas deformantes mientras se adhieren a la rigidez del objeto.

Nuestras evaluaciones integrales, que abarcan comparaciones cualitativas y cuantitativas, destacan la superioridad de Draggan sobre los métodos existentes en tareas relacionadas con la manipulación de imágenes y el seguimiento de puntos. Además, demostramos sus capacidades para manipular imágenes del mundo real a través de la inversión de GaN, mostrando su potencial para diversas aplicaciones prácticas en el ámbito de la síntesis y control de contenido visual.

Inkpunk-Diffusion on Hugging Face Votos positivos

Drag Your GAN Votos positivos

Inkpunk-Diffusion on Hugging Face Características principales

Modelo ajustado: Aprovechando un modelo de Difusión estable ajustado con Dreambooth.

Inspiración artística: Elaborado con influencias de gente como Gorillaz y Yoji Shinkawa.

Interfaz fácil de usar: Utilice Inkpunk-Diffusion a través de la interfaz de usuario web de Gradio para una creación perfecta.

API robusta: Integración con una potente API de inferencia para desarrolladores y creativos.

Compromiso con la comunidad: Una comunidad próspera y colaboración de código abierto dentro de la plataforma.

Drag Your GAN Características principales

No se enumeran características principalesInkpunk-Diffusion on Hugging Face Categoría

- Image Generation Model

Drag Your GAN Categoría

- Image Generation Model

Inkpunk-Diffusion on Hugging Face Tipo de tarificación

- Freemium

Drag Your GAN Tipo de tarificación

- Free