LiteLLM vs ggml.ai

Explora el enfrentamiento entre LiteLLM vs ggml.ai y descubre qué herramienta AI Large Language Model (LLM) gana. Analizamos votos positivos, características, opiniones, precios, alternativas, y más.

En un enfrentamiento entre LiteLLM y ggml.ai, ¿cuál se lleva la corona?

Al contrastar LiteLLM con ggml.ai, ambas son herramientas excepcionales operadas por inteligencia artificial en la categoría de large language model (llm), y al colocarlas lado a lado, podemos notar varias similitudes y divergencias cruciales. El conteo de votos positivos revela un empate, con ambas herramientas obteniendo la misma cantidad de votos positivos. Dado que otros usuarios de aitools.fyi podrían decidir el ganador, ahora la pelota está en tu tejado para emitir tu voto y ayudarnos a determinar al ganador.

¿No estás de acuerdo con el resultado? ¡Emite tu voto y sé parte del proceso de toma de decisiones!

LiteLLM

¿Qué es LiteLLM?

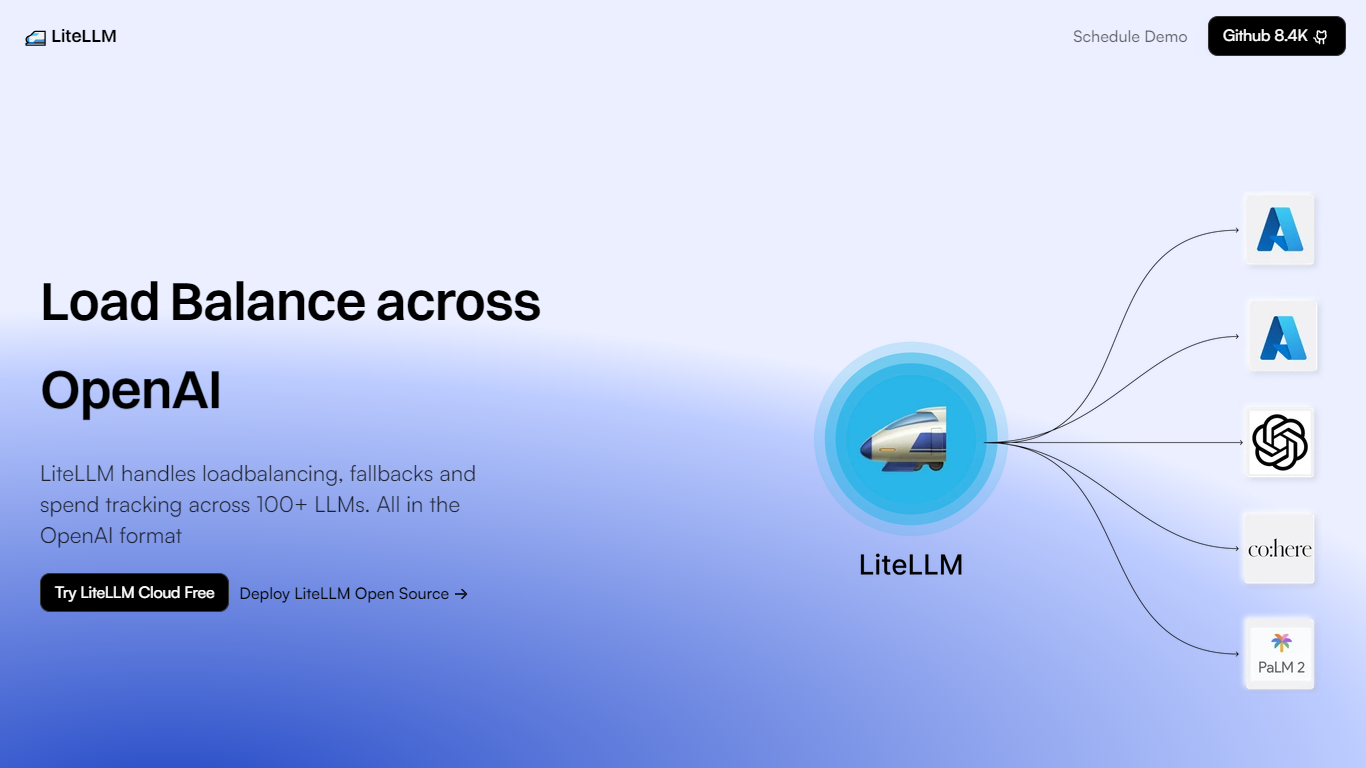

LiteLLM es una plataforma innovadora que se especializa en la gestión eficaz de grandes modelos de lenguaje (LLM) para empresas y desarrolladores. Agiliza las tareas complejas asociadas con estos modelos al ofrecer equilibrio de carga, soluciones alternativas y seguimiento de gastos en más de 100 LLM diferentes, manteniendo al mismo tiempo la compatibilidad del formato estándar OpenAI.

Esto hace que la integración y el funcionamiento de varios LLM sean más eficientes, confiables y rentables, ya que proporciona funciones como agregar modelos, equilibrar la carga entre diferentes recursos informáticos, crear claves para el control de acceso y realizar un seguimiento del gasto para gestionar mejor los presupuestos. Con LiteLLM, los clientes tienen la opción de probar su servicio en la nube de forma gratuita o implementar su solución de código abierto.

La plataforma está respaldada por una comunidad sólida, como se desprende de su repositorio de GitHub, que ha obtenido 8,4 mil estrellas, más de 40 000 extracciones de Docker y más de 20 millones de solicitudes atendidas con un tiempo de actividad del 99 %. La asistencia de más de 150 contribuyentes garantiza que LiteLLM continúe evolucionando y satisfaciendo las demandas de los usuarios de diversos sectores que buscan aprovechar el poder de los LLM.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

LiteLLM Votos positivos

ggml.ai Votos positivos

LiteLLM Características principales

Equilibrio de carga: Distribuye eficientemente las tareas de LLM en varias plataformas, incluidas Azure, Vertex AI y Bedrock.

Soluciones de respaldo: Garantiza la continuidad del servicio con mecanismos de respaldo.

Seguimiento de gastos: Supervisa y gestiona los gastos en operaciones de LLM.

Compatibilidad con el formato OpenAI: Mantiene el formato OpenAI estándar para una integración perfecta.

Soporte comunitario: Respaldado por una sólida comunidad de más de 150 contribuyentes con recursos y documentación.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

LiteLLM Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

LiteLLM Tipo de tarificación

- Freemium

ggml.ai Tipo de tarificación

- Freemium