mo-di-diffusion on Hugging Face vs Drag Your GAN

Compara mo-di-diffusion on Hugging Face vs Drag Your GAN y descubre cuál herramienta AI Image Generation Model es mejor cuando comparamos características, opiniones, precios, alternativas, votos positivos, etc.

¿Cuál es mejor? ¿mo-di-diffusion on Hugging Face o Drag Your GAN?

Cuando comparamos mo-di-diffusion on Hugging Face con Drag Your GAN, ambas herramientas son impulsadas por inteligencia artificial en la categoría de image generation model, La comunidad ha hablado, Drag Your GAN lidera con más votos positivos. El número de votos positivos para Drag Your GAN es de 8, y para mo-di-diffusion on Hugging Face es de 6.

¿No estás de acuerdo con el resultado? ¡Vota por tu herramienta favorita y ayúdala a ganar!

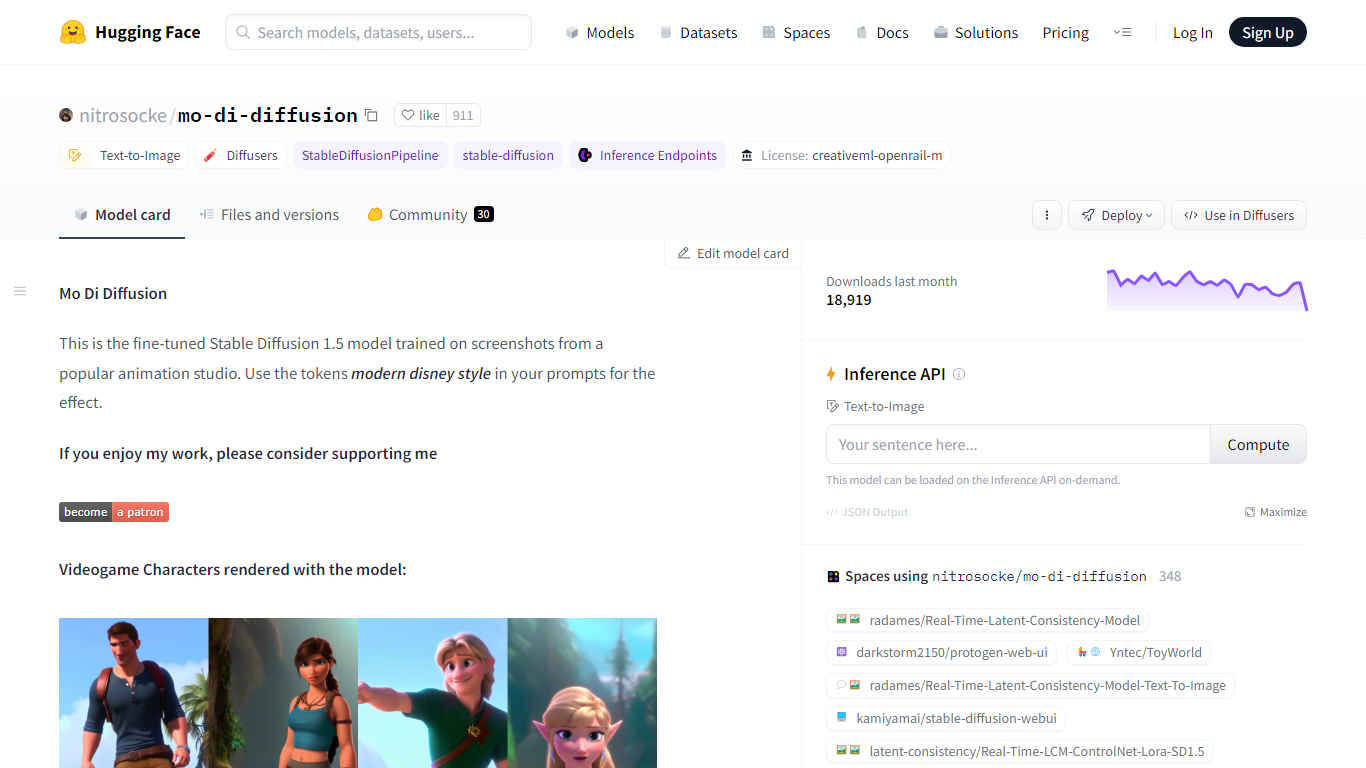

mo-di-diffusion on Hugging Face

¿Qué es mo-di-diffusion on Hugging Face?

Descubra el mundo de la inteligencia artificial y la generación de imágenes con nitrosocke/mo-di-diffusion, un modelo avanzado diseñado para hacer realidad sus visiones creativas. Ubicada dentro del ecosistema innovador de Hugging Face, esta herramienta Stable Diffusion 1.5 optimizada es su puerta de entrada para producir contenido visual cautivador. Aprovechando capturas de pantalla de un renombrado estudio de animación, el modelo proporciona un "estilo moderno de Disney" distintivo que agrega un toque mágico a las imágenes generadas. Ya sea que estés creando personajes de videojuegos, motivos de animales o paisajes encantadores, mo-di-diffusion transforma simples indicaciones de texto en impresionantes obras de arte. Al ofrecer una API sofisticada e interfaces fáciles de usar, Hugging Face garantiza un acceso perfecto a esta potencia creativa. Sumérjase en la simplicidad de la generación de imágenes basada en IA, donde su imaginación se une a la tecnología de código abierto: la solución perfecta para artistas, desarrolladores y creadores de contenido.

Drag Your GAN

¿Qué es Drag Your GAN?

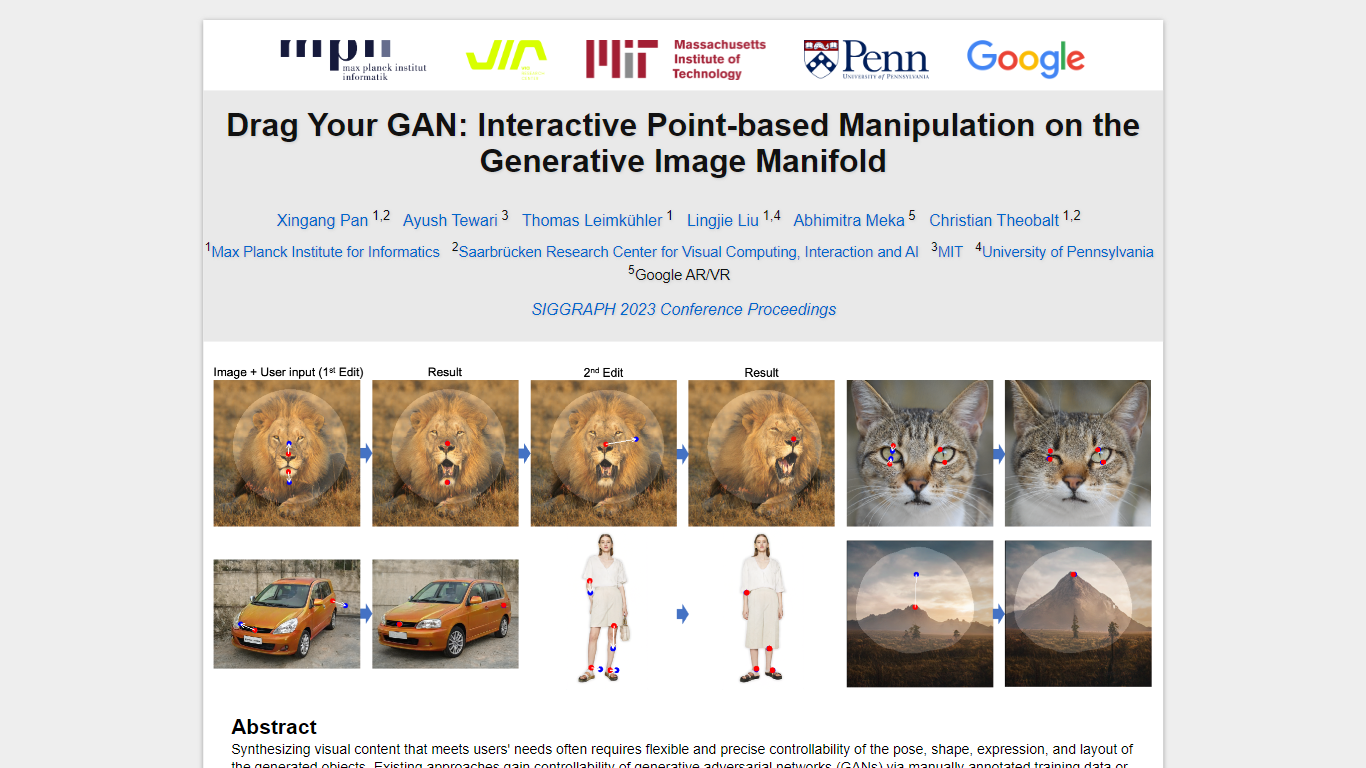

En el ámbito de la sintetización de contenido visual para satisfacer las necesidades de los usuarios, es esencial lograr un control preciso sobre la pose, la forma, la expresión y el diseño de los objetos generados. Los enfoques tradicionales para controlar las redes adversas generativas (GAN) se han basado en anotaciones manuales durante la capacitación o modelos 3D anteriores, a menudo carecen de la flexibilidad, la precisión y la versatilidad requeridas para diversas aplicaciones.

En nuestra investigación, exploramos un método innovador y relativamente desconocido para el control de GaN, la capacidad de "arrastrar" puntos de imagen específicos para alcanzar con precisión los puntos objetivo definidos por el usuario de manera interactiva (como se ilustra en la Fig.1). Este enfoque ha llevado al desarrollo de Draggan, un marco novedoso que comprende dos componentes centrales:

Supervisión de movimiento basada en características: este componente guía los puntos de manejo dentro de la imagen hacia sus posiciones objetivo previstas a través de la supervisión de movimiento basada en características.

Seguimiento de puntos: aprovechando las características discriminativas de GaN, nuestra nueva técnica de seguimiento de puntos localiza continuamente la posición de los puntos de manejo.

Draggan faculta a los usuarios para deformar las imágenes con notable precisión, permitiendo la manipulación de la pose, la forma, la expresión y el diseño en diversas categorías, como animales, automóviles, humanos, paisajes y más. Estas manipulaciones tienen lugar dentro del colector de imágenes generativas aprendidas de un GaN, lo que resulta en resultados realistas, incluso en escenarios complejos como generar contenido ocluido y formas deformantes mientras se adhieren a la rigidez del objeto.

Nuestras evaluaciones integrales, que abarcan comparaciones cualitativas y cuantitativas, destacan la superioridad de Draggan sobre los métodos existentes en tareas relacionadas con la manipulación de imágenes y el seguimiento de puntos. Además, demostramos sus capacidades para manipular imágenes del mundo real a través de la inversión de GaN, mostrando su potencial para diversas aplicaciones prácticas en el ámbito de la síntesis y control de contenido visual.

mo-di-diffusion on Hugging Face Votos positivos

Drag Your GAN Votos positivos

mo-di-diffusion on Hugging Face Características principales

Modelo de IA perfeccionado: Utilice un modelo de difusión estable especializado entrenado con arte de estudio de animación único.

Estilos personalizados: Incorpore fácilmente un "estilo Disney moderno" en sus imágenes con mensajes de texto específicos.

Herramientas accesibles: Integre con el modelo a través de la biblioteca de Difusores o explore con la interfaz de usuario web de Gradio y los cuadernos de Colab.

Licencia de acceso abierto: Utilice el modelo con la seguridad de la licencia OpenRAIL-M de CreativeML.

Capacidad de exportación: Flexibilidad para exportar el modelo a varios formatos, incluidos ONNX MPS y FLAX/JAX.

Drag Your GAN Características principales

No se enumeran características principalesmo-di-diffusion on Hugging Face Categoría

- Image Generation Model

Drag Your GAN Categoría

- Image Generation Model

mo-di-diffusion on Hugging Face Tipo de tarificación

- Freemium

Drag Your GAN Tipo de tarificación

- Free