ggml.ai vs Sanctum

Comparez ggml.ai vs Sanctum et voyez quel outil AI Large Language Model (LLM) est meilleur lorsque nous comparons les fonctionnalités, les avis, les prix, les alternatives, les votes positifs, etc.

Lequel est meilleur? ggml.ai ou Sanctum?

Quand nous comparons ggml.ai avec Sanctum, qui sont tous deux des outils large language model (llm) alimentés par l'IA, Avec plus de votes positifs, Sanctum est le choix préféré. Sanctum a attiré 8 votes positifs des utilisateurs de aitools.fyi, et ggml.ai a attiré 6 votes positifs.

Pas votre tasse de thé? Votez pour votre outil préféré et remuez les choses!

ggml.ai

Qu'est-ce que ggml.ai?

ggml.ai est à la pointe de la technologie de l'IA, apportant de puissantes capacités d'apprentissage automatique directement à la périphérie grâce à sa bibliothèque de tenseurs innovante. Conçu pour la prise en charge de grands modèles et des performances élevées sur les plates-formes matérielles courantes, ggml.ai permet aux développeurs d'implémenter des algorithmes d'IA avancés sans avoir besoin d'équipement spécialisé. La plate-forme, écrite dans le langage de programmation C efficace, offre une prise en charge de la quantification flottante et entière 16 bits, ainsi que la différenciation automatique et divers algorithmes d'optimisation intégrés comme ADAM et L-BFGS. Il offre des performances optimisées pour Apple Silicon et exploite les intrinsèques AVX/AVX2 sur les architectures x86. Les applications basées sur le Web peuvent également exploiter ses capacités via la prise en charge de WebAssembly et WASM SIMD. Avec ses allocations de mémoire d'exécution nulles et son absence de dépendances tierces, ggml.ai présente une solution minimale et efficace pour l'inférence sur l'appareil.

Des projets tels que Whisper.cpp et Llama.cpp démontrent les capacités d'inférence hautes performances de ggml.ai, Whisper.cpp fournissant des solutions de synthèse vocale et Llama.cpp se concentrant sur l'inférence efficace du grand modèle de langage LLaMA de Meta. De plus, la société accueille favorablement les contributions à sa base de code et prend en charge un modèle de développement open-core via la licence MIT. Alors que ggml.ai continue de se développer, il recherche des développeurs à temps plein talentueux partageant une vision commune de l'inférence sur appareil pour rejoindre son équipe.

Conçu pour repousser les limites de l'IA à la pointe, ggml.ai témoigne de l'esprit de jeu et d'innovation de la communauté de l'IA.

Sanctum

Qu'est-ce que Sanctum?

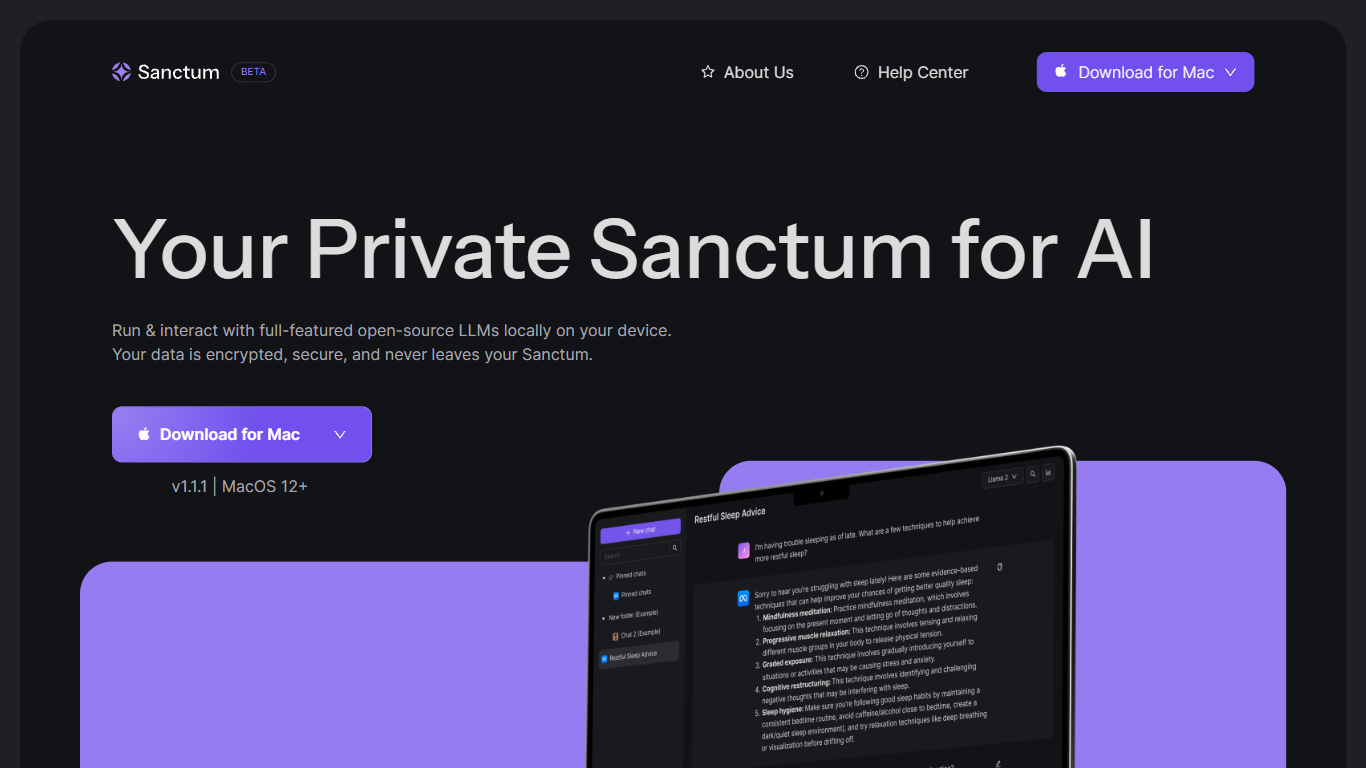

Présentation de Sanctum, votre assistant IA privé et local qui apporte la sophistication de l'IA directement sur votre bureau avec un maximum de confidentialité et de commodité. Optimisé pour MacOS 12+ avec prise en charge des processeurs Apple Silicon et Intel, Sanctum est un outil innovant qui vous permet d'exécuter et d'interagir avec des modèles grand langage (LLM) open source riches en fonctionnalités directement sur votre ordinateur local. Oubliez le cloud : vos données sont cryptées, sécurisées et restent dans les limites de votre appareil, offrant ainsi une confidentialité inégalée. Que ce soit pour un usage personnel, des tâches sensibles aux données ou des projets de développement, Sanctum adopte une approche axée sur la confidentialité pour garantir que vos interactions avec l'IA restent les vôtres. Avec une version mobile attendue et des mises à jour à venir telles que la prise en charge de modèles supplémentaires et la compatibilité multiplateforme, Sanctum promet d'être à la pointe des outils d'IA accessibles et sécurisés.

ggml.ai Votes positifs

Sanctum Votes positifs

ggml.ai Fonctionnalités principales

Écrit en C : Garantit des performances élevées et une compatibilité sur une gamme de plates-formes.

Optimisation pour Apple Silicon : Offre un traitement efficace et une latence réduite sur les appareils Apple.

Prise en charge de WebAssembly et WASM SIMD : Facilite l'utilisation des applications Web par les capacités d'apprentissage automatique.

Aucune dépendance tierce : Permet une base de code épurée et un déploiement pratique.

Prise en charge de la sortie linguistique guidée : Améliore l'interaction homme-machine avec des réponses plus intuitives générées par l'IA.

Sanctum Fonctionnalités principales

Exécutez l'IA localement sur votre appareil : profitez des avantages de l'IA avancée sans avoir besoin d'une connectivité Internet une fois Sanctum installé.

Cryptage des données axé sur la confidentialité : Ayez l'esprit tranquille en sachant que vos données sont cryptées et traitées sur votre Mac, en préservant votre confidentialité et votre contrôle.

Commutation de modèle sans friction : basculez facilement entre différents modèles open source pour trouver celui qui correspond le mieux à vos besoins.

Divers cas d'utilisation : utilisez Sanctum pour analyser des données personnelles et financières, créer du contenu et bien plus encore, tout en préservant la confidentialité de vos informations.

Mises à jour à l'épreuve du temps : gardez une longueur d'avance grâce aux fonctionnalités à venir telles que la prise en charge de modèles supplémentaires d'apprentissage automatique personnalisé et les capacités multiplateformes (IOS Android Windows Linux).

ggml.ai Catégorie

- Large Language Model (LLM)

Sanctum Catégorie

- Large Language Model (LLM)

ggml.ai Type de tarification

- Freemium

Sanctum Type de tarification

- Freemium