ICBINP | Civitai vs Drag Your GAN

Dans le duel entre ICBINP | Civitai vs Drag Your GAN, quel outil AI Image Generation Model prend la couronne? Nous scrutons les fonctionnalités, les alternatives, les votes positifs, les avis, les prix, et plus encore.

Quand nous mettons ICBINP | Civitai et Drag Your GAN côte à côte, lequel émerge comme le vainqueur?

Si nous devions analyser ICBINP | Civitai et Drag Your GAN, tous deux étant des outils image generation model alimentés par l'IA, que trouverions-nous ? Le décompte des votes positifs montre une nette préférence pour Drag Your GAN. Drag Your GAN a été voté 8 fois par les utilisateurs de aitools.fyi, et ICBINP | Civitai a été voté 6 fois.

Vous n'êtes pas d'accord avec le résultat? Votez pour nous aider à décider!

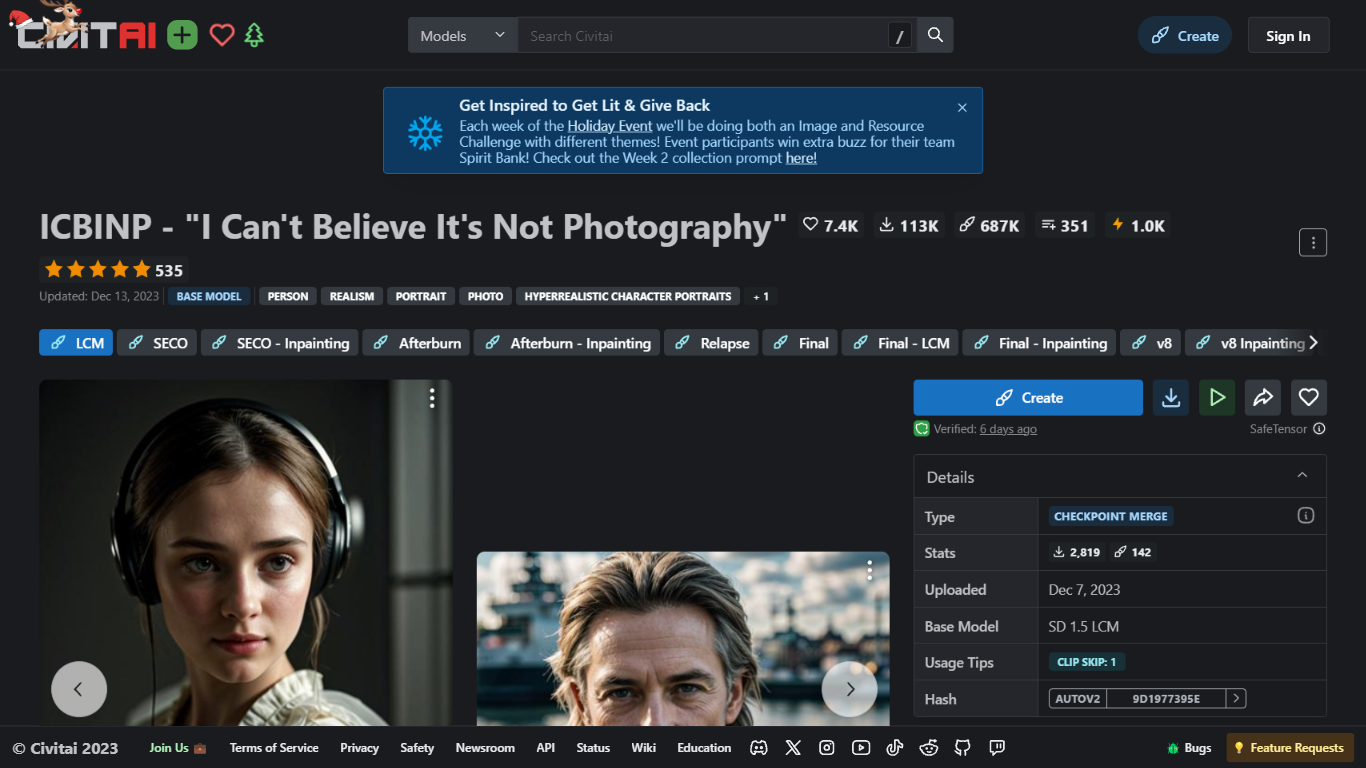

ICBINP | Civitai

Qu'est-ce que ICBINP | Civitai?

Faites l'expérience de la génération d'images hyperréalistes avec ICBINP - "I Can't Believe It's Not Photography" - un point de contrôle puissant pour le modèle Stable Diffusion disponible sur Civitai. Le point de contrôle ICBINP LCM est spécialement conçu pour produire des rendus d'images de haute qualité avec un nombre de pas remarquablement faible. En tirant parti de l'efficacité de l'intégration LCM_Lora, les utilisateurs peuvent s'attendre à générer de superbes exemples d'images en seulement 5 étapes à l'aide de l'échantillonneur DPM++ SDE Karras. Ce modèle excelle dans la création de personnages réalistes, de portraits et de représentations de personnages hyperréalistes, et peut également créer des personnages et des paysages CGI convaincants. Le point de contrôle est réduit à fp16 pour des performances optimales et intègre le VAE du SD-v2 840000 pour une meilleure qualité d'image. Pour ceux qui recherchent une génération d’images rapide et réaliste, ICBINP ouvre les possibilités de créativité et d’innovation dans les représentations visuelles.

Drag Your GAN

Qu'est-ce que Drag Your GAN?

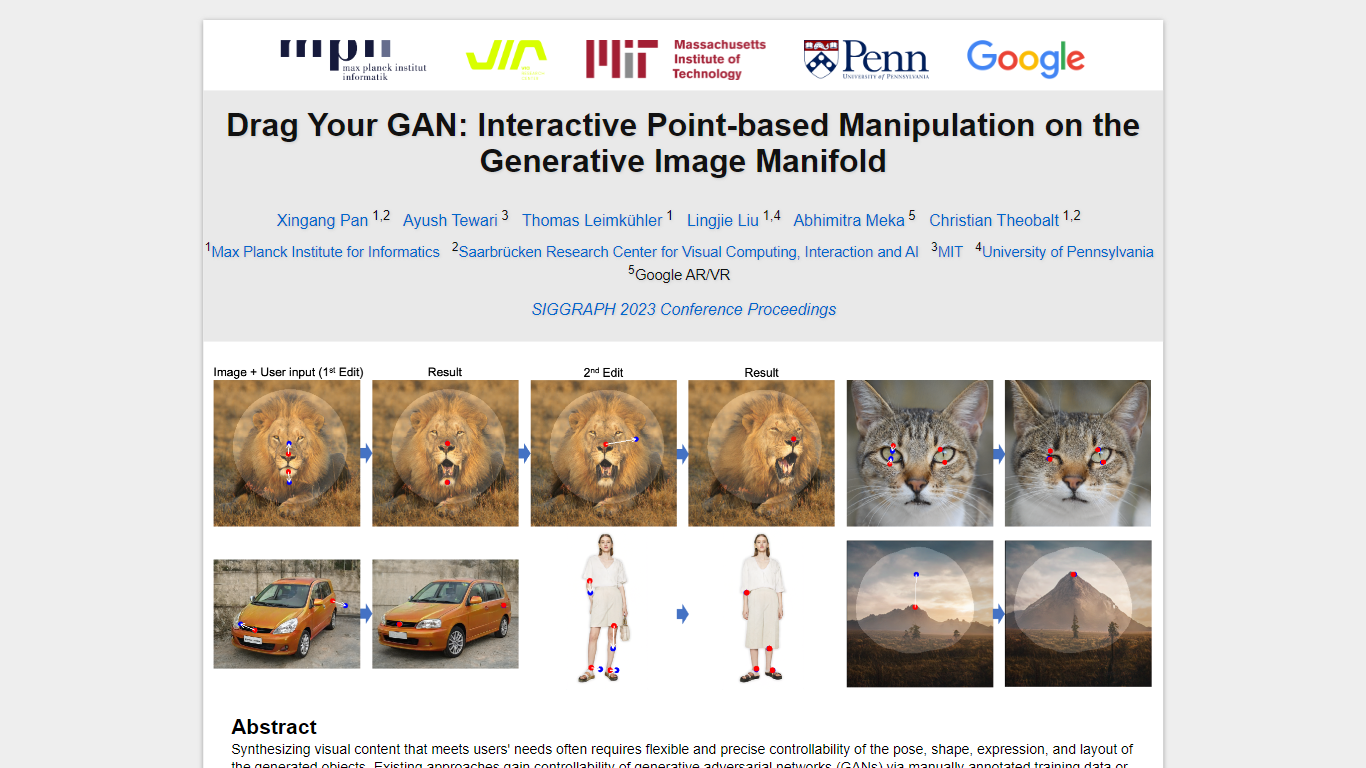

Dans le domaine de la synthèse de contenu visuel pour répondre aux besoins des utilisateurs, il est essentiel d'obtenir un contrôle précis sur la pose, la forme, l'expression et la disposition des objets générés. Les approches traditionnelles de contrôle des réseaux adverses génératifs (GAN) reposaient sur des annotations manuelles lors de la formation ou sur des modèles 3D préalables, manquant souvent de la flexibilité, de la précision et de la polyvalence requises pour diverses applications.

Dans notre recherche, nous explorons une méthode innovante et relativement inexplorée pour le contrôle du GAN : la possibilité de « faire glisser » des points d'image spécifiques pour atteindre avec précision des points cibles définis par l'utilisateur de manière interactive (comme illustré sur la figure 1). Cette approche a conduit au développement de DragGAN, un nouveau framework comprenant deux composants principaux :

Supervision de mouvement basée sur les fonctionnalités : ce composant guide les points de poignée dans l'image vers leurs positions cibles prévues grâce à une supervision de mouvement basée sur les fonctionnalités.

Suivi des points : tirant parti des fonctionnalités discriminantes du GAN, notre nouvelle technique de suivi des points localise en permanence la position des points de poignée.

DragGAN permet aux utilisateurs de déformer les images avec une précision remarquable, permettant ainsi la manipulation de la pose, de la forme, de l'expression et de la disposition dans diverses catégories telles que les animaux, les voitures, les humains, les paysages, etc. Ces manipulations ont lieu au sein de la variété d'images génératives apprises d'un GAN, ce qui donne des résultats réalistes, même dans des scénarios complexes tels que la génération de contenu occlus et la déformation de formes tout en adhérant à la rigidité de l'objet.

Nos évaluations complètes, comprenant des comparaisons qualitatives et quantitatives, mettent en évidence la supériorité de DragGAN sur les méthodes existantes dans les tâches liées à la manipulation d'images et au suivi de points. De plus, nous démontrons ses capacités à manipuler des images du monde réel via l'inversion GAN, démontrant ainsi son potentiel pour diverses applications pratiques dans le domaine de la synthèse et du contrôle de contenu visuel.

ICBINP | Civitai Votes positifs

Drag Your GAN Votes positifs

ICBINP | Civitai Fonctionnalités principales

Génération d'images hyperréalistes : Capable de produire des images très réalistes qui remettent en question la frontière entre l'art généré par l'IA et les photographies réelles.

Intégration LCM_Lora : Conçu pour des sorties de haute qualité avec un faible nombre d'étapes, augmentant ainsi l'efficacité sans compromettre la qualité.

Représentation visuelle polyvalente : Bien adapté à une gamme d'images, y compris des portraits réalistes de personnages et de paysages CGI.

Modèle élagué : Optimisé à fp16 pour garantir des performances plus rapides tout en conservant une sortie haute résolution.

VAE Baked In : Incorpore l'encodeur automatique variationnel du SD-v2 840000 pour améliorer la fidélité des images générées.

Drag Your GAN Fonctionnalités principales

Aucune fonctionnalité principale répertoriéeICBINP | Civitai Catégorie

- Image Generation Model

Drag Your GAN Catégorie

- Image Generation Model

ICBINP | Civitai Type de tarification

- Freemium

Drag Your GAN Type de tarification

- Free