Inkpunk-Diffusion on Hugging Face vs Drag Your GAN

Dans la bataille de Inkpunk-Diffusion on Hugging Face vs Drag Your GAN, quel outil AI Image Generation Model sort en tête? Nous comparons les avis, les prix, les alternatives, les votes positifs, les fonctionnalités, et plus encore.

Entre Inkpunk-Diffusion on Hugging Face et Drag Your GAN, lequel est supérieur?

En comparant Inkpunk-Diffusion on Hugging Face avec Drag Your GAN, qui sont tous deux des outils image generation model alimentés par l'IA, Les utilisateurs ont clairement exprimé leur préférence, Drag Your GAN mène en termes de votes positifs. Le décompte des votes positifs pour Drag Your GAN est de 8, et pour Inkpunk-Diffusion on Hugging Face il est de 6.

Vous vous sentez rebelle? Votez et secouez les choses!

Inkpunk-Diffusion on Hugging Face

Qu'est-ce que Inkpunk-Diffusion on Hugging Face?

Embarquez pour un voyage innovant avec Envvi/Inkpunk-Diffusion, où la fusion de l'art et de l'IA ouvre la porte à une créativité illimitée. Notre plate-forme offre une fonctionnalité texte-image unique alimentée par un modèle de diffusion stable affiné, Inkpunk-Diffusion, méticuleusement formé sur dreambooth. S'inspirant de styles emblématiques tels que Gorillaz et Yoji Shinkawa, Inkpunk-Diffusion invite les artistes et créateurs à explorer de nouveaux paradigmes visuels. En s'intégrant à Gradio, nous fournissons une interface utilisateur Web conviviale qui simplifie le processus permettant de donner vie à vos invites imaginatives, garantissant ainsi l'accessibilité et la facilité d'utilisation pour tous les utilisateurs. Avec une API d'inférence robuste et la capacité de télécharger des milliers d'images échantillons, Inkpunk-Diffusion est à l'avant-garde de la démocratisation et du progrès de l'intelligence artificielle dans le domaine de la science ouverte.

Drag Your GAN

Qu'est-ce que Drag Your GAN?

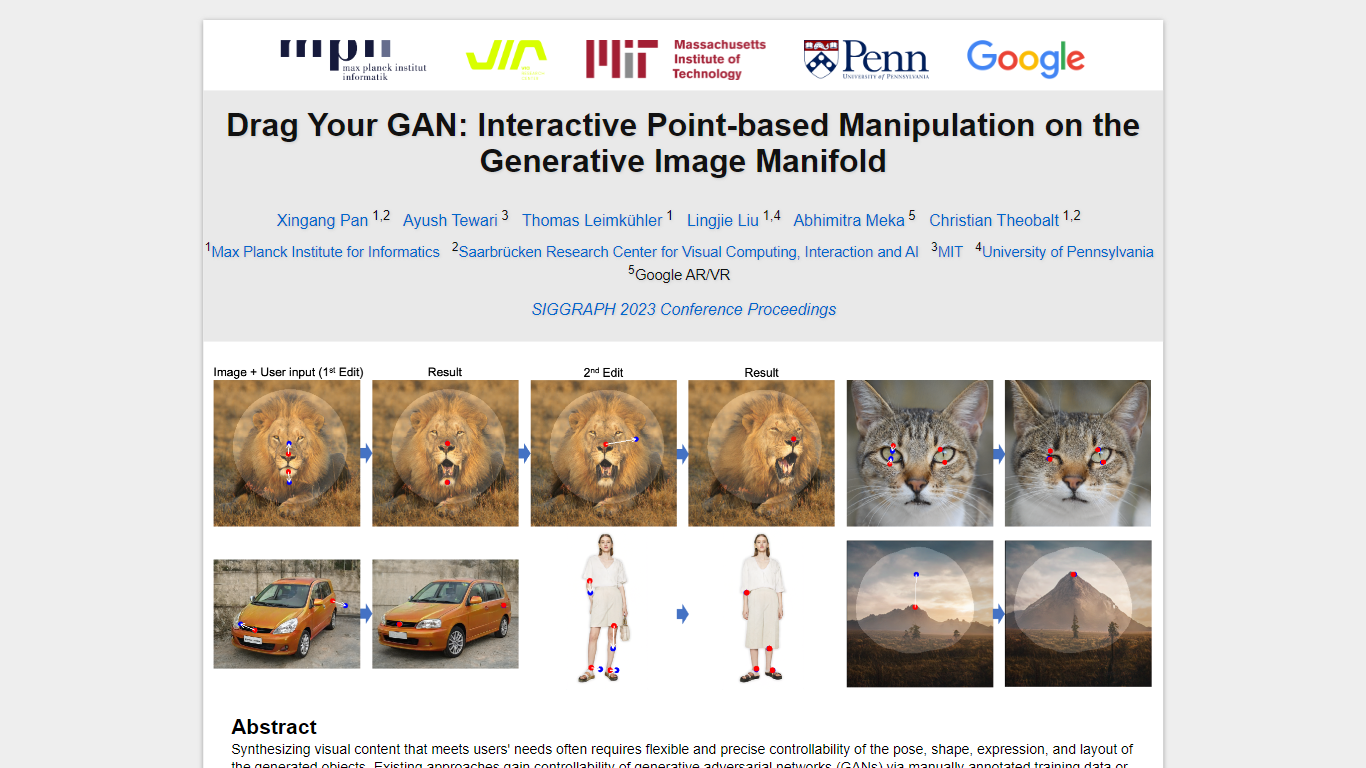

Dans le domaine de la synthèse de contenu visuel pour répondre aux besoins des utilisateurs, il est essentiel d'obtenir un contrôle précis sur la pose, la forme, l'expression et la disposition des objets générés. Les approches traditionnelles de contrôle des réseaux adverses génératifs (GAN) reposaient sur des annotations manuelles lors de la formation ou sur des modèles 3D préalables, manquant souvent de la flexibilité, de la précision et de la polyvalence requises pour diverses applications.

Dans notre recherche, nous explorons une méthode innovante et relativement inexplorée pour le contrôle du GAN : la possibilité de « faire glisser » des points d'image spécifiques pour atteindre avec précision des points cibles définis par l'utilisateur de manière interactive (comme illustré sur la figure 1). Cette approche a conduit au développement de DragGAN, un nouveau framework comprenant deux composants principaux :

Supervision de mouvement basée sur les fonctionnalités : ce composant guide les points de poignée dans l'image vers leurs positions cibles prévues grâce à une supervision de mouvement basée sur les fonctionnalités.

Suivi des points : tirant parti des fonctionnalités discriminantes du GAN, notre nouvelle technique de suivi des points localise en permanence la position des points de poignée.

DragGAN permet aux utilisateurs de déformer les images avec une précision remarquable, permettant ainsi la manipulation de la pose, de la forme, de l'expression et de la disposition dans diverses catégories telles que les animaux, les voitures, les humains, les paysages, etc. Ces manipulations ont lieu au sein de la variété d'images génératives apprises d'un GAN, ce qui donne des résultats réalistes, même dans des scénarios complexes tels que la génération de contenu occlus et la déformation de formes tout en adhérant à la rigidité de l'objet.

Nos évaluations complètes, comprenant des comparaisons qualitatives et quantitatives, mettent en évidence la supériorité de DragGAN sur les méthodes existantes dans les tâches liées à la manipulation d'images et au suivi de points. De plus, nous démontrons ses capacités à manipuler des images du monde réel via l'inversion GAN, démontrant ainsi son potentiel pour diverses applications pratiques dans le domaine de la synthèse et du contrôle de contenu visuel.

Inkpunk-Diffusion on Hugging Face Votes positifs

Drag Your GAN Votes positifs

Inkpunk-Diffusion on Hugging Face Fonctionnalités principales

Modèle affiné : Exploitation d'un modèle de diffusion stable affiné avec dreambooth.

Inspiration artistique : Conçu avec l'influence de Gorillaz et Yoji Shinkawa.

Interface conviviale : Utilisez Inkpunk-Diffusion via l'interface utilisateur Web de Gradio pour une création transparente.

API robuste : Intégration avec une puissante API d'inférence pour les développeurs et les créatifs.

Engagement communautaire : Une communauté florissante et une collaboration open source au sein de la plateforme.

Drag Your GAN Fonctionnalités principales

Aucune fonctionnalité principale répertoriéeInkpunk-Diffusion on Hugging Face Catégorie

- Image Generation Model

Drag Your GAN Catégorie

- Image Generation Model

Inkpunk-Diffusion on Hugging Face Type de tarification

- Freemium

Drag Your GAN Type de tarification

- Free