LiteLLM vs ggml.ai

Explorez le face-à-face entre LiteLLM vs ggml.ai et découvrez quel outil AI Large Language Model (LLM) gagne. Nous analysons les votes positifs, les fonctionnalités, les avis, les prix, les alternatives, et plus encore.

Dans un face-à-face entre LiteLLM et ggml.ai, lequel prend la couronne?

Quand nous contrastons LiteLLM avec ggml.ai, tous deux étant des outils exceptionnels large language model (llm) opérés par l'IA, et les plaçons côte à côte, nous pouvons repérer plusieurs similitudes et divergences cruciales. Le décompte des votes positifs révèle une égalité, les deux outils obtenant le même nombre de votes positifs. Puisque d'autres utilisateurs de aitools.fyi pourraient décider du gagnant, c'est maintenant à vous de jouer pour voter et nous aider à déterminer le gagnant.

Vous n'êtes pas d'accord avec le résultat? Votez et participez au processus de décision!

LiteLLM

Qu'est-ce que LiteLLM?

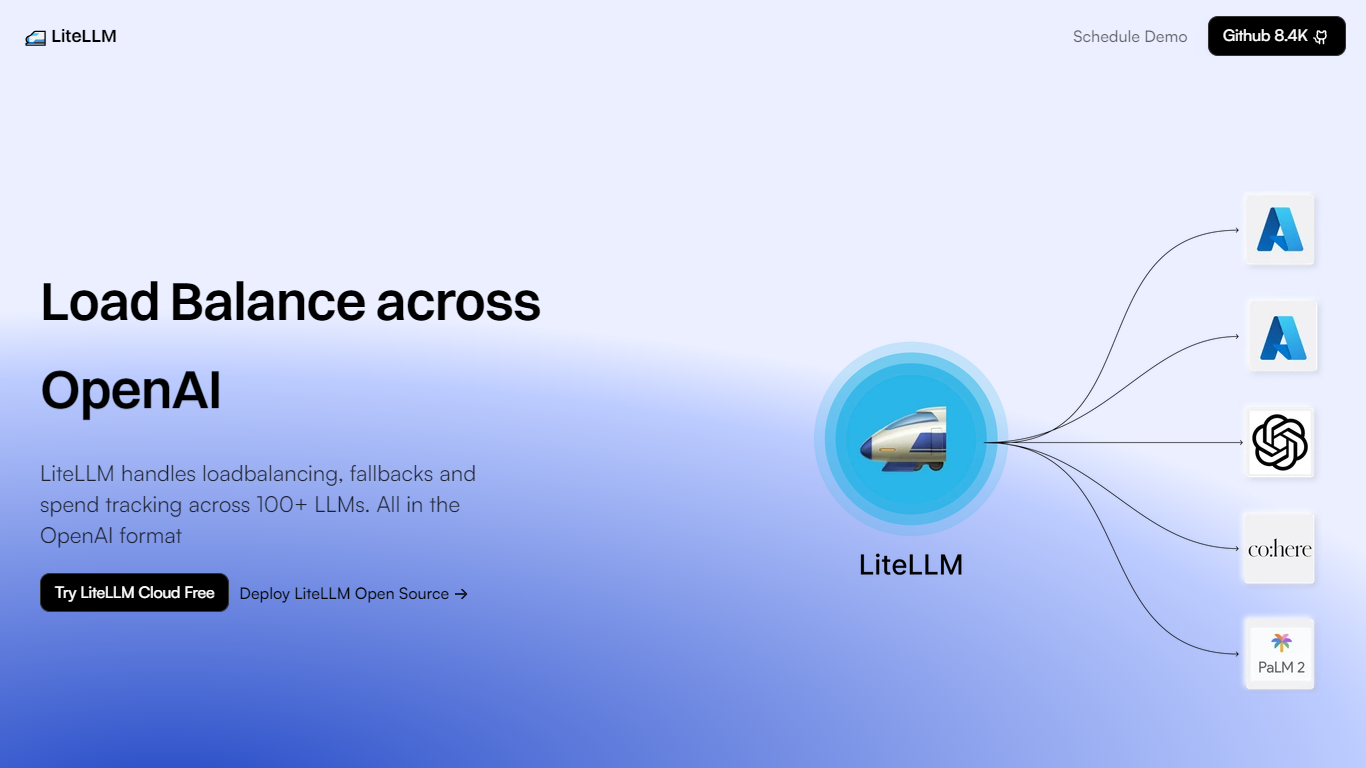

LiteLLM est une plateforme innovante spécialisée dans la gestion efficace des grands modèles de langage (LLM) pour les entreprises et les développeurs. Il rationalise les tâches complexes associées à ces modèles en proposant un équilibrage de charge, des solutions de secours et un suivi des dépenses sur plus de 100 LLM différents tout en conservant la compatibilité du format OpenAI standard.

Cela rend l'intégration et l'exploitation de plusieurs LLM plus efficaces, fiables et rentables, car il fournit des fonctionnalités telles que l'ajout de modèles, l'équilibrage de la charge entre différentes ressources de calcul, la création de clés pour le contrôle d'accès et le suivi des dépenses pour mieux gérer les budgets. Avec LiteLLM, les clients ont la possibilité d'essayer leur service cloud gratuitement ou de déployer leur solution open source.

La plate-forme est soutenue par une communauté solide, comme en témoigne son référentiel GitHub qui a récolté 8,4 000 étoiles, plus de 40 000 extractions Docker et plus de 20 millions de requêtes traitées avec une disponibilité de 99 %. L'assistance de plus de 150 contributeurs garantit que LiteLLM continue d'évoluer et de répondre aux demandes des utilisateurs de divers secteurs cherchant à tirer parti de la puissance des LLM.

ggml.ai

Qu'est-ce que ggml.ai?

ggml.ai est à la pointe de la technologie de l'IA, apportant de puissantes capacités d'apprentissage automatique directement à la périphérie grâce à sa bibliothèque de tenseurs innovante. Conçu pour la prise en charge de grands modèles et des performances élevées sur les plates-formes matérielles courantes, ggml.ai permet aux développeurs d'implémenter des algorithmes d'IA avancés sans avoir besoin d'équipement spécialisé. La plate-forme, écrite dans le langage de programmation C efficace, offre une prise en charge de la quantification flottante et entière 16 bits, ainsi que la différenciation automatique et divers algorithmes d'optimisation intégrés comme ADAM et L-BFGS. Il offre des performances optimisées pour Apple Silicon et exploite les intrinsèques AVX/AVX2 sur les architectures x86. Les applications basées sur le Web peuvent également exploiter ses capacités via la prise en charge de WebAssembly et WASM SIMD. Avec ses allocations de mémoire d'exécution nulles et son absence de dépendances tierces, ggml.ai présente une solution minimale et efficace pour l'inférence sur l'appareil.

Des projets tels que Whisper.cpp et Llama.cpp démontrent les capacités d'inférence hautes performances de ggml.ai, Whisper.cpp fournissant des solutions de synthèse vocale et Llama.cpp se concentrant sur l'inférence efficace du grand modèle de langage LLaMA de Meta. De plus, la société accueille favorablement les contributions à sa base de code et prend en charge un modèle de développement open-core via la licence MIT. Alors que ggml.ai continue de se développer, il recherche des développeurs à temps plein talentueux partageant une vision commune de l'inférence sur appareil pour rejoindre son équipe.

Conçu pour repousser les limites de l'IA à la pointe, ggml.ai témoigne de l'esprit de jeu et d'innovation de la communauté de l'IA.

LiteLLM Votes positifs

ggml.ai Votes positifs

LiteLLM Fonctionnalités principales

Équilibrage de charge : distribue efficacement les tâches LLM sur diverses plates-formes, notamment Azure, Vertex AI et Bedrock.

Solutions de repli : Assure la continuité du service grâce à des mécanismes de repli.

Suivi des dépenses : Surveille et gère les dépenses liées aux opérations LLM.

Compatibilité du format OpenAI : Conserve le format OpenAI standard pour une intégration transparente.

Soutien communautaire : Soutenu par une solide communauté de plus de 150 contributeurs avec des ressources et de la documentation.

ggml.ai Fonctionnalités principales

Écrit en C : Garantit des performances élevées et une compatibilité sur une gamme de plates-formes.

Optimisation pour Apple Silicon : Offre un traitement efficace et une latence réduite sur les appareils Apple.

Prise en charge de WebAssembly et WASM SIMD : Facilite l'utilisation des applications Web par les capacités d'apprentissage automatique.

Aucune dépendance tierce : Permet une base de code épurée et un déploiement pratique.

Prise en charge de la sortie linguistique guidée : Améliore l'interaction homme-machine avec des réponses plus intuitives générées par l'IA.

LiteLLM Catégorie

- Large Language Model (LLM)

ggml.ai Catégorie

- Large Language Model (LLM)

LiteLLM Type de tarification

- Freemium

ggml.ai Type de tarification

- Freemium