ELECTRA vs ggml.ai

Explore o confronto entre ELECTRA vs ggml.ai e descubra qual ferramenta AI Large Language Model (LLM) vence. Analisamos votos positivos, recursos, avaliações, preços, alternativas e muito mais.

Em um confronto entre ELECTRA e ggml.ai, qual leva a coroa?

Ao contrastar ELECTRA com ggml.ai, ambas são ferramentas excepcionais operadas por inteligência artificial na categoria de large language model (llm), e ao colocá-las lado a lado, podemos notar várias semelhanças e divergências cruciais. O número de votos positivos revela um empate, com ambas as ferramentas recebendo o mesmo número de votos positivos. O poder está em suas mãos! Vote e participe da decisão do vencedor.

Acha que erramos? Vote e mostre quem manda!

ELECTRA

O que é ELECTRA?

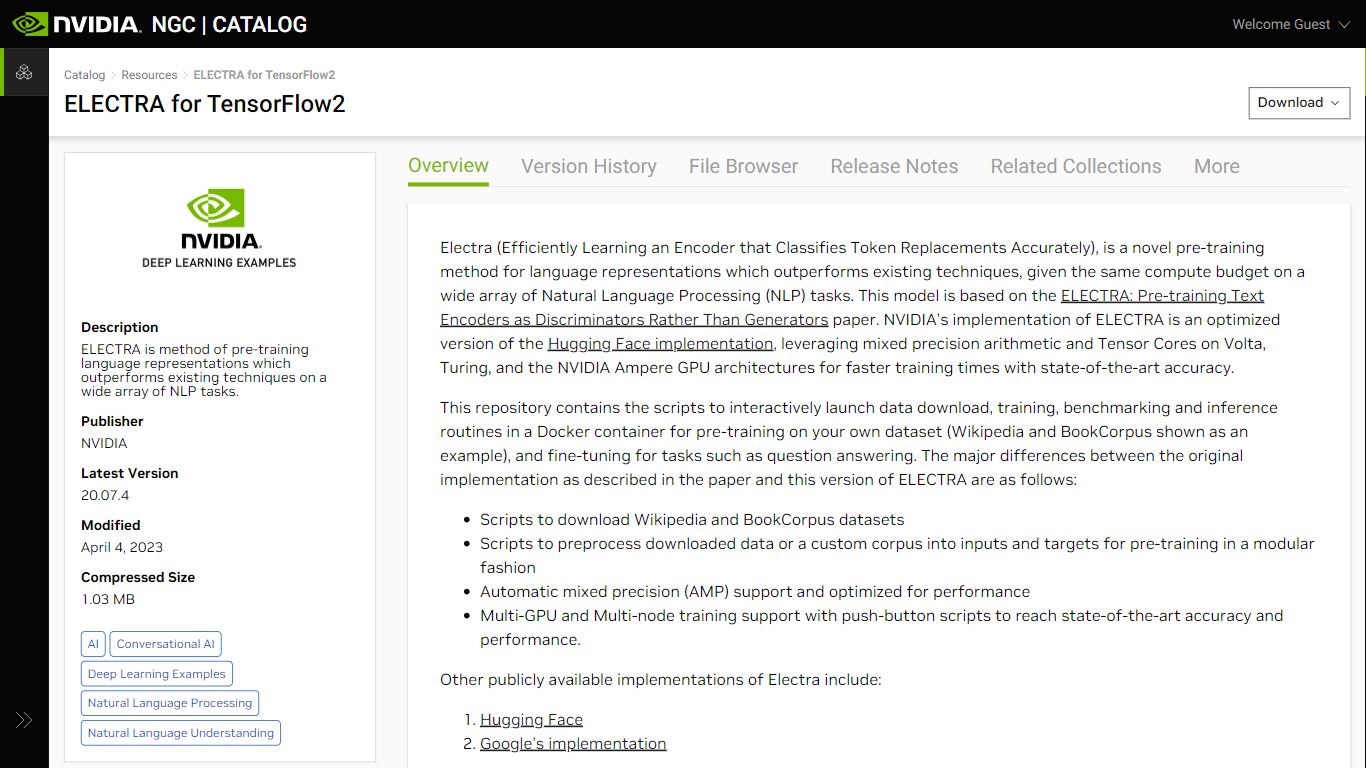

ELECTRA for TensorFlow2, disponível no NVIDIA NGC, representa um avanço na representação de linguagem de pré-treinamento para tarefas de processamento de linguagem natural (PNL). Ao aprender com eficiência um codificador que classifica com precisão as substituições de tokens, o ELECTRA supera os métodos existentes dentro do mesmo orçamento computacional em vários aplicativos de PNL. Desenvolvido com base em um artigo de pesquisa, este modelo se beneficia significativamente das otimizações fornecidas pela NVIDIA, como aritmética de precisão mista e utilizações de Tensor Core nas arquiteturas de GPU Volta, Turing e NVIDIA Ampere. Ele não apenas alcança tempos de treinamento mais rápidos, mas também garante precisão de última geração.

Compreendendo a arquitetura, o ELECTRA difere dos modelos convencionais como o BERT ao introduzir uma estrutura geradora-discriminadora que identifica substituições de tokens de forma mais eficiente – uma abordagem inspirada em redes adversárias generativas (GANs). Essa implementação é fácil de usar, oferecendo scripts para download de dados, pré-processamento, treinamento, benchmarking e inferência, tornando mais fácil para os pesquisadores trabalharem com conjuntos de dados personalizados e ajustarem tarefas, incluindo resposta a perguntas.

ggml.ai

O que é ggml.ai?

ggml.ai está na vanguarda da tecnologia de IA, trazendo poderosos recursos de aprendizado de máquina diretamente para o limite com sua inovadora biblioteca de tensores. Construído para suporte a grandes modelos e alto desempenho em plataformas de hardware comuns, ggml.ai permite que os desenvolvedores implementem algoritmos avançados de IA sem a necessidade de equipamento especializado. A plataforma, escrita na eficiente linguagem de programação C, oferece suporte para flutuação de 16 bits e quantização de inteiros, juntamente com diferenciação automática e vários algoritmos de otimização integrados, como ADAM e L-BFGS. Possui desempenho otimizado para Apple Silicon e aproveita os intrínsecos AVX/AVX2 em arquiteturas x86. Os aplicativos baseados na Web também podem explorar seus recursos por meio do suporte WebAssembly e WASM SIMD. Com zero alocações de memória em tempo de execução e ausência de dependências de terceiros, ggml.ai apresenta uma solução mínima e eficiente para inferência no dispositivo.

Projetos como whisk.cpp e llama.cpp demonstram os recursos de inferência de alto desempenho do ggml.ai, com o whisker.cpp fornecendo soluções de fala para texto e o llama.cpp focando na inferência eficiente do modelo de linguagem grande LLaMA da Meta. Além disso, a empresa aceita contribuições para a sua base de código e apoia um modelo de desenvolvimento de núcleo aberto através da licença MIT. À medida que a ggml.ai continua a se expandir, ela procura desenvolvedores talentosos em tempo integral com uma visão compartilhada de inferência no dispositivo para se juntarem à sua equipe.

Projetado para ir além dos limites da IA, ggml.ai é uma prova do espírito de diversão e inovação na comunidade de IA.

ELECTRA Votos positivos

ggml.ai Votos positivos

ELECTRA Recursos principais

Suporte de precisão mista: velocidade de treinamento aprimorada usando aritmética de precisão mista em arquiteturas de GPU NVIDIA compatíveis.

Treinamento multi-GPU e vários nós: oferece suporte ao treinamento distribuído em várias GPUs e nós, facilitando o desenvolvimento mais rápido de modelos.

Scripts de pré-treinamento e ajuste fino: inclui scripts para baixar e pré-processar conjuntos de dados, permitindo fácil configuração para processos de pré-treinamento e ajuste fino., -

Arquitetura de modelo avançado: Integra um esquema gerador-discriminador para um aprendizado mais eficaz de representações de linguagem.

Desempenho otimizado: aproveita otimizações para os Tensor Cores e Automatic Mixed Precision (AMP) para treinamento acelerado de modelo.

ggml.ai Recursos principais

Escrito em C: Garante alto desempenho e compatibilidade em diversas plataformas.

Otimização para Apple Silicon: oferece processamento eficiente e menor latência em dispositivos Apple.

Suporte para WebAssembly e WASM SIMD: Facilita que aplicativos Web utilizem recursos de aprendizado de máquina.

Sem dependências de terceiros: Proporciona uma base de código organizada e uma implantação conveniente.

Suporte de saída de idioma guiado: Melhora a interação humano-computador com respostas mais intuitivas geradas por IA.

ELECTRA Categoria

- Large Language Model (LLM)

ggml.ai Categoria

- Large Language Model (LLM)

ELECTRA Tipo de tarifação

- Freemium

ggml.ai Tipo de tarifação

- Freemium