GLM-130B vs Terracotta

No confronto entre GLM-130B vs Terracotta, qual ferramenta AI Large Language Model (LLM) sai vitoriosa? Avaliamos avaliações, preços, alternativas, recursos, votos positivos e muito mais.

Quando colocamos GLM-130B e Terracotta lado a lado, qual emerge como o vencedor?

Vamos dar uma olhada mais de perto em GLM-130B e Terracotta, ambas são ferramentas alimentadas por inteligência artificial na categoria de large language model (llm), e veja o que os distingue. GLM-130B é o claro vencedor em termos de votos positivos. GLM-130B recebeu 7 votos positivos dos usuários da aitools.fyi, enquanto Terracotta recebeu 6 votos positivos.

Não é a sua praia? Vote em sua ferramenta preferida e mexa as coisas!

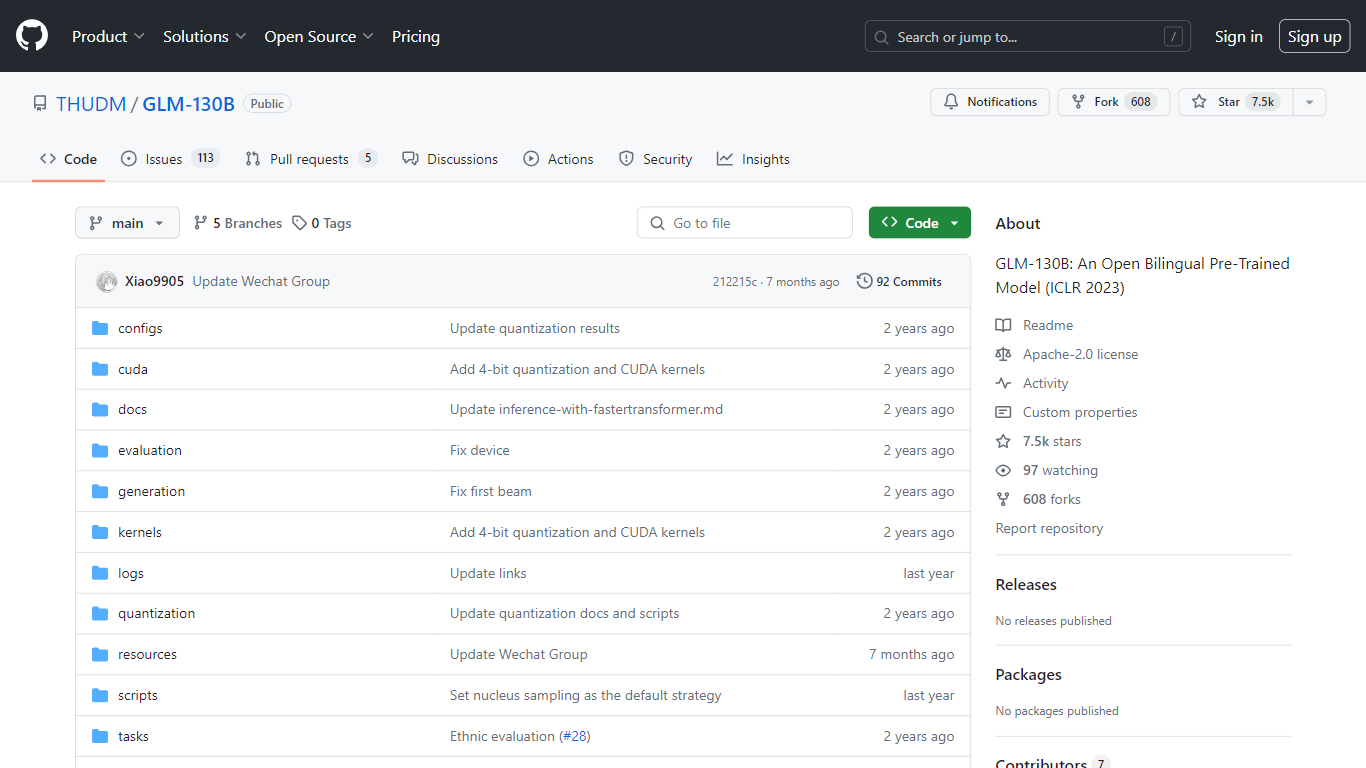

GLM-130B

O que é GLM-130B?

O GLM-130B, apresentado no ICLR 2023, representa um modelo pré-treinado bilíngue aberto inovador que se destaca por seus impressionantes 130 bilhões de parâmetros. Desenvolvido para modelagem densa bidirecional em inglês e chinês, o GLM-130B aproveita o algoritmo General Language Model (GLM) para pré-treinamento e é otimizado para executar tarefas de inferência em uma configuração de servidor único, seja ele o A100 (40G * 8) ou o V100 (32G * 8). Além disso, sua compatibilidade com a quantização INT4 significa que os já modestos requisitos de hardware podem ser reduzidos ainda mais, permitindo que um servidor com 4*RTX 3090 (24G) suporte o modelo com degradação mínima de desempenho.

Como parte do seu processo de treinamento, o GLM-130B digeriu um extenso conjunto de dados que consiste em mais de 400 bilhões de tokens de texto, divididos igualmente entre chinês e inglês. Possui suporte bilíngue excepcional, desempenho superior em vários conjuntos de dados quando comparado com seus equivalentes e oferece tempos de inferência rápidos. Além disso, este repositório também promove a reprodutibilidade, facilitando o código-fonte aberto e pontos de verificação de modelo para mais de 30 tarefas.

Terracotta

O que é Terracotta?

Terracotta é uma plataforma de ponta projetada para aprimorar o fluxo de trabalho para desenvolvedores e pesquisadores que trabalham com grandes modelos de linguagem (LLMs). Esta plataforma intuitiva e fácil de usar permite gerenciar, iterar e avaliar seus modelos ajustados com facilidade. Com o Terracotta, você pode fazer upload de dados com segurança, ajustar modelos para diversas tarefas, como classificação e geração de texto, e criar avaliações abrangentes para comparar o desempenho do modelo usando métricas qualitativas e quantitativas. Nossa ferramenta oferece suporte a conexões com grandes provedores como OpenAI e Cohere, garantindo que você tenha acesso a uma ampla gama de recursos de LLM. Terracotta é criação de Beri Kohen e Lucas Pauker, entusiastas de IA e graduados em Stanford, que se dedicam a promover o desenvolvimento de LLM. Cadastre-se em nossa lista de e-mail para se manter informado sobre as últimas atualizações e recursos que o Terracotta tem a oferecer.

GLM-130B Votos positivos

Terracotta Votos positivos

GLM-130B Recursos principais

Suporte bilíngue: O GLM-130B atende aos modelos em inglês e chinês.

Alto desempenho: Benchmarks abrangentes mostram que o GLM-130B supera os modelos rivais em diversos conjuntos de dados.

Inferência rápida: utiliza SAT e FasterTransformer para inferência rápida em um único servidor A100.

Reprodutibilidade: Resultados consistentes em mais de 30 tarefas, graças ao código-fonte aberto e aos pontos de verificação do modelo.

Compatibilidade entre plataformas: Acomoda uma variedade de plataformas, incluindo NVIDIA, Hygon DCU, Ascend 910 e Sunway.

Terracotta Recursos principais

Gerencie vários modelos: Gerencie centralmente todos os seus modelos ajustados em um local conveniente.

Iterar rapidamente: Simplifique o processo de melhoria do modelo com avaliações qualitativas e quantitativas rápidas.

Vários provedores: Integre-se perfeitamente aos serviços da OpenAI e Cohere para turbinar seu processo de desenvolvimento.

Carregue seus dados: carregue e armazene com segurança seus conjuntos de dados para o ajuste fino de modelos.

Crie avaliações: conduza avaliações comparativas aprofundadas do desempenho do modelo, aproveitando métricas como precisão BLEU e matrizes de confusão.

GLM-130B Categoria

- Large Language Model (LLM)

Terracotta Categoria

- Large Language Model (LLM)

GLM-130B Tipo de tarifação

- Free

Terracotta Tipo de tarifação

- Freemium