Última atualização 10-23-2025

Categoria:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

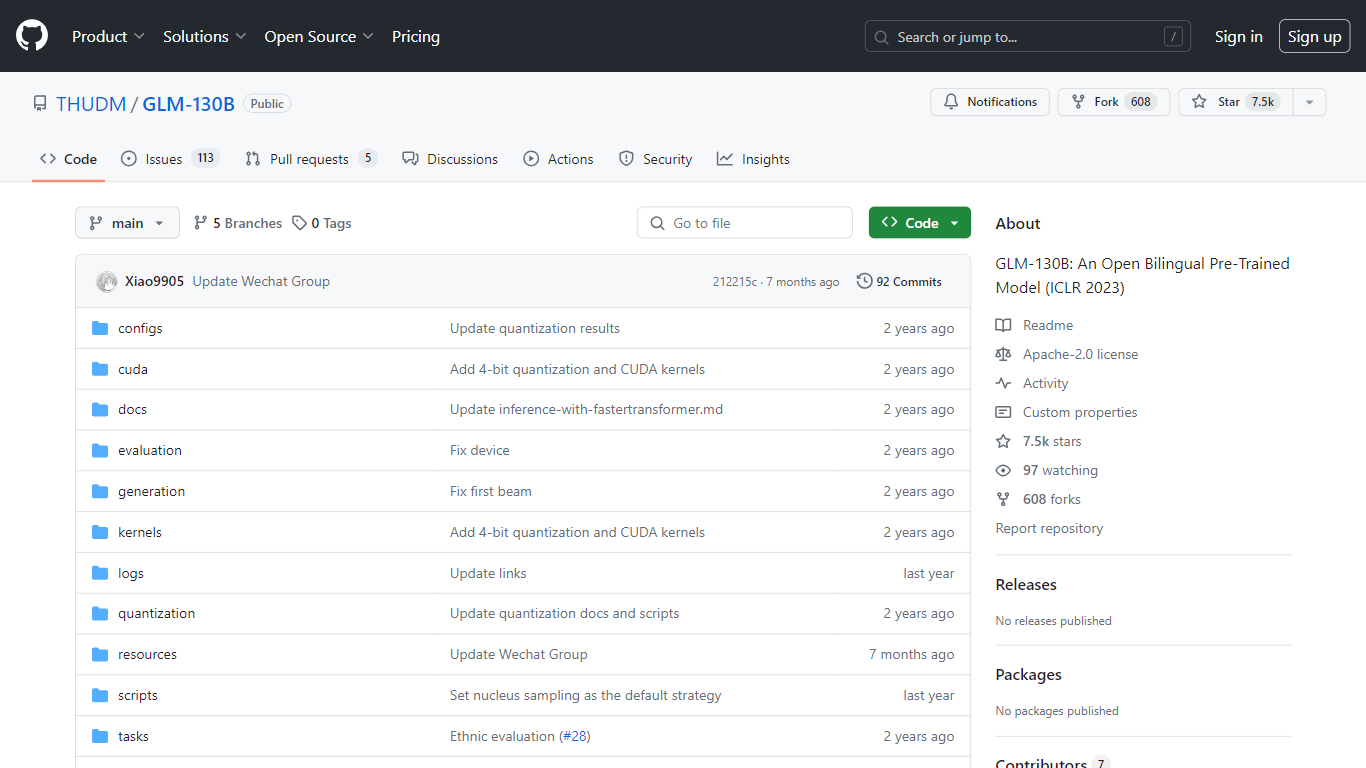

GLM-130B

O GLM-130B, apresentado no ICLR 2023, representa um modelo pré-treinado bilíngue aberto inovador que se destaca por seus impressionantes 130 bilhões de parâmetros. Desenvolvido para modelagem densa bidirecional em inglês e chinês, o GLM-130B aproveita o algoritmo General Language Model (GLM) para pré-treinamento e é otimizado para executar tarefas de inferência em uma configuração de servidor único, seja ele o A100 (40G * 8) ou o V100 (32G * 8). Além disso, sua compatibilidade com a quantização INT4 significa que os já modestos requisitos de hardware podem ser reduzidos ainda mais, permitindo que um servidor com 4*RTX 3090 (24G) suporte o modelo com degradação mínima de desempenho.

Como parte do seu processo de treinamento, o GLM-130B digeriu um extenso conjunto de dados que consiste em mais de 400 bilhões de tokens de texto, divididos igualmente entre chinês e inglês. Possui suporte bilíngue excepcional, desempenho superior em vários conjuntos de dados quando comparado com seus equivalentes e oferece tempos de inferência rápidos. Além disso, este repositório também promove a reprodutibilidade, facilitando o código-fonte aberto e pontos de verificação de modelo para mais de 30 tarefas.

Suporte bilíngue: O GLM-130B atende aos modelos em inglês e chinês.

Alto desempenho: Benchmarks abrangentes mostram que o GLM-130B supera os modelos rivais em diversos conjuntos de dados.

Inferência rápida: utiliza SAT e FasterTransformer para inferência rápida em um único servidor A100.

Reprodutibilidade: Resultados consistentes em mais de 30 tarefas, graças ao código-fonte aberto e aos pontos de verificação do modelo.

Compatibilidade entre plataformas: Acomoda uma variedade de plataformas, incluindo NVIDIA, Hygon DCU, Ascend 910 e Sunway.

O que é GLM-130B?

GLM-130B é um modelo denso bidirecional e bilíngue com 130 bilhões de parâmetros, pré-treinado usando o algoritmo General Language Model (GLM).

Em quantos dados o GLM-130B foi treinado?

O modelo foi treinado em mais de 400 bilhões de tokens de texto, sendo 200 bilhões cada para texto em chinês e inglês.

Os resultados produzidos pelo GLM-130B podem ser reproduzidos?

Sim, todos os resultados em mais de 30 tarefas podem ser facilmente reproduzidos usando o código-fonte aberto fornecido e os pontos de verificação do modelo.

O GLM-130B suporta múltiplas plataformas de hardware?

O GLM-130B suporta não apenas NVIDIA, mas também Hygon DCU, Ascend 910 e, em breve, plataformas Sunway para treinamento e inferência.

Qual é o foco principal do repositório GLM-130B?

O repositório concentra-se principalmente na avaliação do GLM-130B, suportando inferência rápida de modelos e reprodutibilidade de resultados.