RLAMA vs ggml.ai

Explore o confronto entre RLAMA vs ggml.ai e descubra qual ferramenta AI Large Language Model (LLM) vence. Analisamos votos positivos, recursos, avaliações, preços, alternativas e muito mais.

Ao comparar RLAMA e ggml.ai, qual se destaca?

Ao contrastar RLAMA com ggml.ai, ambas são ferramentas excepcionais operadas por inteligência artificial na categoria de large language model (llm), e ao colocá-las lado a lado, podemos notar várias semelhanças e divergências cruciais. Ambas as ferramentas são igualmente favorecidas, como indicado pelo mesmo número de votos positivos. Você pode nos ajudar a determinar o vencedor votando e inclinando a balança a favor de uma das ferramentas.

Se sentindo rebelde? Vote e agite as coisas!

RLAMA

O que é RLAMA?

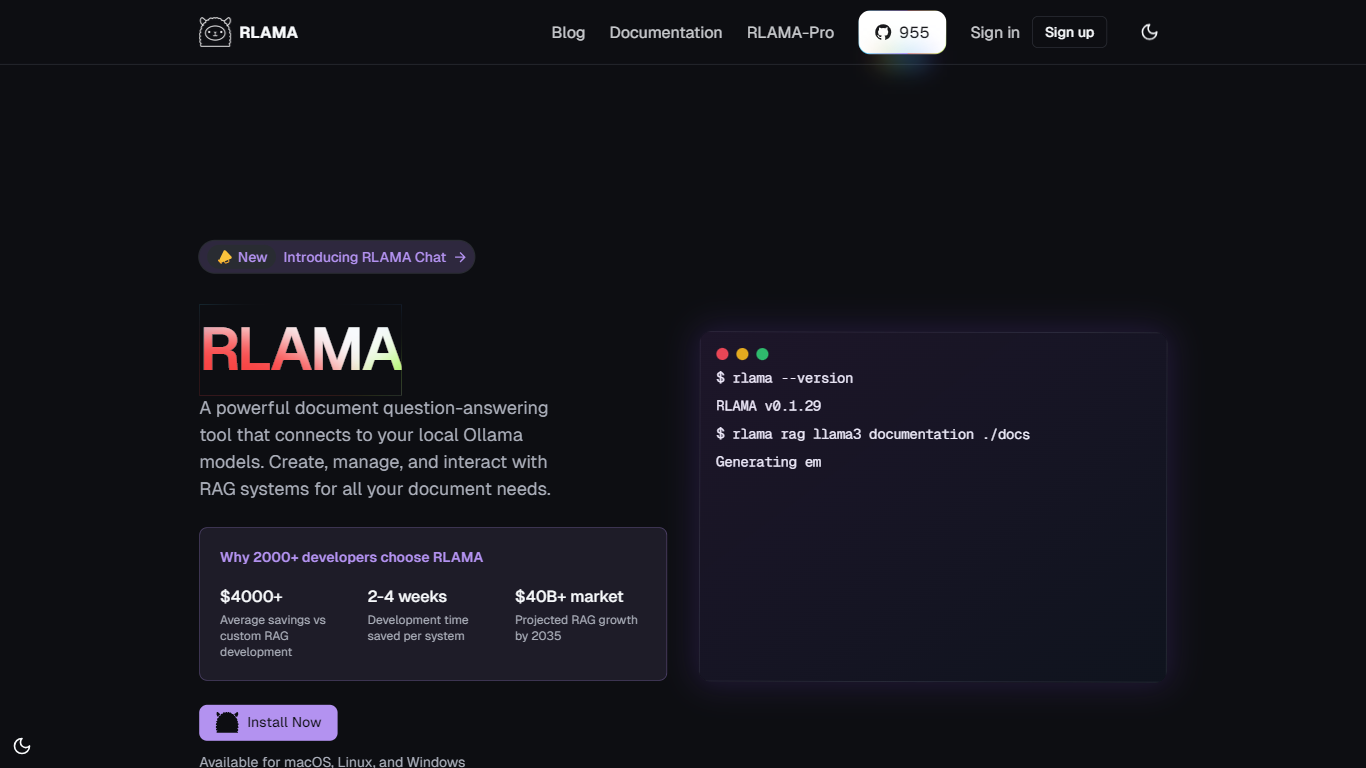

RLAMA é uma poderosa ferramenta de perguntas e respostas para documentos, projetada para se conectar perfeitamente aos modelos locais Ollama. Ela permite que os usuários criem, gerenciem e interajam com sistemas de Recuperação-Geração Aumentada (RAG) adaptados especificamente para suas necessidades de documentação. A principal funcionalidade da RLAMA reside em sua capacidade de fornecer recursos avançados que vão além da RAG básica, permitindo que os usuários integrem documentos sem esforço em seus fluxos de trabalho. Isso a torna uma solução ideal para desenvolvedores e organizações que buscam aprimorar seus processos de gerenciamento de documentos.

O público-alvo da RLAMA inclui desenvolvedores, pesquisadores e organizações que exigem recursos eficientes de manuseio de documentos e respostas a perguntas. Com mais de 2.000 desenvolvedores já optando pela RLAMA, ela provou ser uma ferramenta confiável no mercado. A proposta de valor exclusiva da RLAMA é sua natureza de código aberto, que permite aos usuários personalizar e adaptar a ferramenta às suas necessidades específicas sem incorrer nos altos custos associados ao desenvolvimento de RAG personalizado.

Um dos principais diferenciais da RLAMA é sua abordagem prioritariamente offline, garantindo que todo o processamento seja feito localmente, sem enviar dados para servidores externos. Este recurso não apenas aumenta a privacidade, mas também melhora o desempenho, reduzindo a latência. Além disso, o RLAMA suporta diversos formatos de documentos, incluindo PDFs, Markdown e arquivos de texto, tornando-o versátil para diversos casos de uso. O recurso de agrupamento inteligente otimiza ainda mais a recuperação de contexto, garantindo que os usuários obtenham as informações mais relevantes de seus documentos.

Os detalhes técnicos da implementação destacam que o RLAMA está disponível para macOS, Linux e Windows, tornando-o acessível a uma ampla gama de usuários. A ferramenta também oferece um construtor visual de RAGs, permitindo que os usuários criem sistemas RAG poderosos em minutos, sem a necessidade de codificação. Esta interface intuitiva foi projetada para tornar a criação de RAGs acessível a todos, independentemente de sua formação técnica. Com o RLAMA, os usuários podem esperar economizar tempo e custos significativos de desenvolvimento, ao mesmo tempo em que criam sistemas robustos de perguntas e respostas baseados em documentos.

ggml.ai

O que é ggml.ai?

ggml.ai está na vanguarda da tecnologia de IA, trazendo poderosos recursos de aprendizado de máquina diretamente para o limite com sua inovadora biblioteca de tensores. Construído para suporte a grandes modelos e alto desempenho em plataformas de hardware comuns, ggml.ai permite que os desenvolvedores implementem algoritmos avançados de IA sem a necessidade de equipamento especializado. A plataforma, escrita na eficiente linguagem de programação C, oferece suporte para flutuação de 16 bits e quantização de inteiros, juntamente com diferenciação automática e vários algoritmos de otimização integrados, como ADAM e L-BFGS. Possui desempenho otimizado para Apple Silicon e aproveita os intrínsecos AVX/AVX2 em arquiteturas x86. Os aplicativos baseados na Web também podem explorar seus recursos por meio do suporte WebAssembly e WASM SIMD. Com zero alocações de memória em tempo de execução e ausência de dependências de terceiros, ggml.ai apresenta uma solução mínima e eficiente para inferência no dispositivo.

Projetos como whisk.cpp e llama.cpp demonstram os recursos de inferência de alto desempenho do ggml.ai, com o whisker.cpp fornecendo soluções de fala para texto e o llama.cpp focando na inferência eficiente do modelo de linguagem grande LLaMA da Meta. Além disso, a empresa aceita contribuições para a sua base de código e apoia um modelo de desenvolvimento de núcleo aberto através da licença MIT. À medida que a ggml.ai continua a se expandir, ela procura desenvolvedores talentosos em tempo integral com uma visão compartilhada de inferência no dispositivo para se juntarem à sua equipe.

Projetado para ir além dos limites da IA, ggml.ai é uma prova do espírito de diversão e inovação na comunidade de IA.

RLAMA Votos positivos

ggml.ai Votos positivos

RLAMA Recursos principais

Configuração simples: crie e configure sistemas RAG com apenas alguns comandos e configuração mínima, facilitando o início rápido para qualquer pessoa.

Vários formatos de documento: suporta vários formatos, como PDFs, Markdown e arquivos de texto, permitindo que os usuários trabalhem com seus tipos de documentos preferidos.

Offline First: garante processamento 100% local, sem envio de dados para servidores externos, aumentando a privacidade e a segurança de informações confidenciais.

Fragmentação inteligente: segmenta documentos automaticamente para recuperação de contexto ideal, ajudando os usuários a encontrar as respostas mais relevantes de forma eficiente.

Visual RAG Builder: crie sistemas RAG poderosos visualmente em apenas 2 minutos sem escrever nenhum código, tornando-os acessíveis a todos os usuários.

ggml.ai Recursos principais

Escrito em C: Garante alto desempenho e compatibilidade em diversas plataformas.

Otimização para Apple Silicon: oferece processamento eficiente e menor latência em dispositivos Apple.

Suporte para WebAssembly e WASM SIMD: Facilita que aplicativos Web utilizem recursos de aprendizado de máquina.

Sem dependências de terceiros: Proporciona uma base de código organizada e uma implantação conveniente.

Suporte de saída de idioma guiado: Melhora a interação humano-computador com respostas mais intuitivas geradas por IA.

RLAMA Categoria

- Large Language Model (LLM)

ggml.ai Categoria

- Large Language Model (LLM)

RLAMA Tipo de tarifação

- Free

ggml.ai Tipo de tarifação

- Freemium