wav2vec 2.0

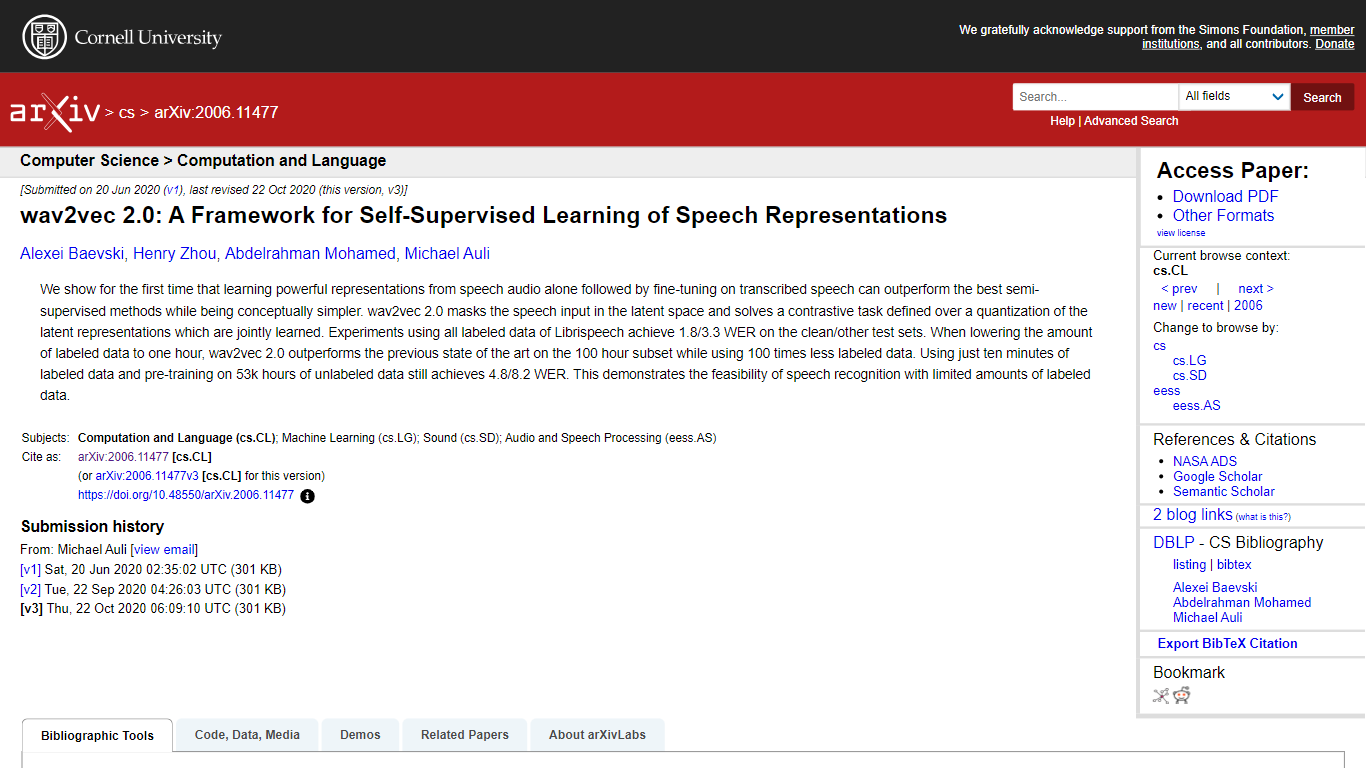

了解题为“wav2vec 2.0:语音表示自监督学习框架”的论文中提出的创新研究,该论文展示了语音处理技术中的突破性方法。本文由 Alexei Baevski、Henry Zhou、Abdelrahman Mohamed 和 Michael Auli 撰写,介绍了 wav2vec 2.0 框架,该框架旨在仅从语音音频中学习表示。通过对转录语音进行微调,它优于许多半监督方法,被证明是一种更简单但有效的解决方案。主要亮点包括能够屏蔽潜在空间中的语音输入,并解决量化潜在表示的对比任务。该研究展示了使用最少量标记数据进行语音识别的令人印象深刻的结果,改变了开发高效且有效的语音识别系统的前景。

自监督框架: 引入 wav2vec 2.0 作为语音处理的自监督学习框架。

卓越的性能: 证明该框架可以超越半监督方法,同时保持概念简单性。

对比任务方法: 在潜在空间中采用新颖的对比任务来增强学习。

最少的标记数据: 使用极其有限的标记数据量实现显着的语音识别结果。

广泛的实验: 分享利用 Librispeech 数据集的实验结果,以展示该框架的有效性。

什么是 wav2vec 2.0?

Wav2vec 2.0 是一个用于语音表示自监督学习的框架,它屏蔽了潜在空间中的语音输入,并解决了这些表示量化的对比任务。

wav2vec 2.0 论文的作者是谁?

Alexei Baevski、Henry Zhou、Abdelrahman Mohamed 和 Michael Auli 是 wav2vec 2.0 论文的作者。

wav2vec 2.0 能否超越半监督方法?

是的,wav2vec 2.0 框架可以通过从语音音频中学习并对转录语音进行微调来超越半监督方法。

wav2vec 2.0 背景下的对比任务是什么?

wav2vec 2.0 上下文中的对比任务是指框架学习区分输入语音和干扰样本的正确潜在表示的方法。

在实验中使用 wav2vec 2.0 取得了哪些 WER 结果?

使用 wav2vec 2.0 进行的实验在 Librispeech 的干净/其他测试集上使用完整标记数据实现了 1.8/3.3 WER,在对 53000 小时的未标记数据进行预训练后,仅使用 10 分钟的标记数据就实现了 4.8/8.2 WER。