GLM-130B vs ggml.ai

Al comparar GLM-130B vs ggml.ai, ¿cuál herramienta AI Large Language Model (LLM) brilla con más intensidad? Examinamos precios, alternativas, votos positivos, características, opiniones, y más.

Entre GLM-130B y ggml.ai, ¿cuál es superior?

Cuando ponemos GLM-130B y ggml.ai uno al lado del otro, ambas siendo herramientas impulsadas por inteligencia artificial en la categoría de large language model (llm), GLM-130B es el claro ganador en términos de votos positivos. GLM-130B ha sido votado positivamente 7 veces por usuarios de aitools.fyi, y ggml.ai ha sido votado positivamente 6 veces.

¿No es lo tuyo? ¡Vota por tu herramienta preferida y agita las cosas!

GLM-130B

¿Qué es GLM-130B?

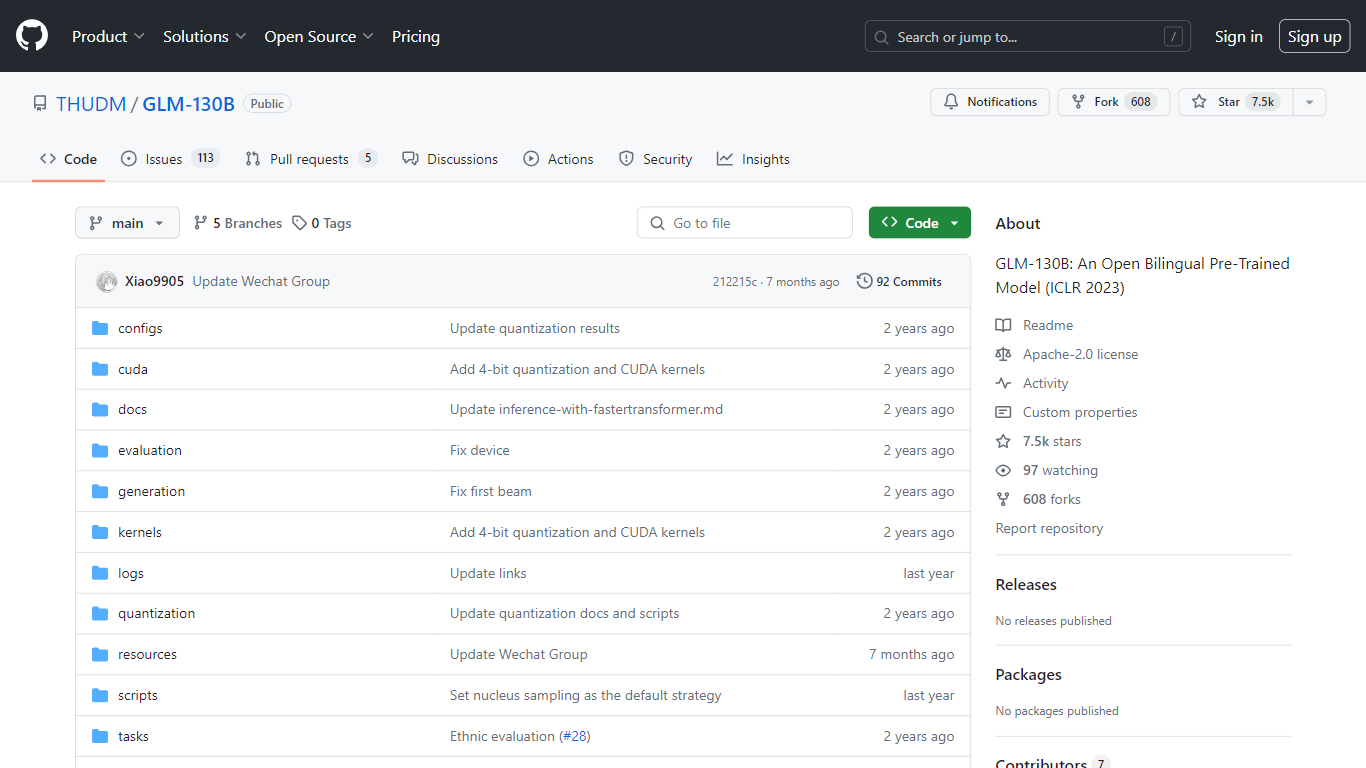

GLM-130B, presentado en ICLR 2023, representa un innovador modelo bilingüe abierto preentrenado que destaca por sus impresionantes 130 mil millones de parámetros. Desarrollado para modelado denso bidireccional tanto en inglés como en chino, el GLM-130B aprovecha el algoritmo del Modelo de lenguaje general (GLM) para el entrenamiento previo y está optimizado para ejecutar tareas de inferencia en una configuración de servidor único, ya sea el A100 (40G * 8). o el V100 (32G * 8). Además, su compatibilidad con la cuantificación INT4 significa que los ya modestos requisitos de hardware se pueden reducir aún más, permitiendo que un servidor con 4* RTX 3090 (24G) admita el modelo con una mínima degradación del rendimiento.

Como parte de su proceso de entrenamiento, el GLM-130B ha digerido un extenso conjunto de datos que consta de más de 400 mil millones de tokens de texto, divididos equitativamente entre chino e inglés. Cuenta con soporte bilingüe excepcional, rendimiento superior en varios conjuntos de datos en comparación con sus contrapartes y ofrece tiempos de inferencia rápidos. Además, este repositorio también promueve la reproducibilidad al facilitar código fuente abierto y puntos de control de modelos para más de 30 tareas.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

GLM-130B Votos positivos

ggml.ai Votos positivos

GLM-130B Características principales

Soporte bilingüe: GLM-130B atiende a modelos en inglés y chino.

Alto rendimiento: Los puntos de referencia completos muestran que el GLM-130B supera a los modelos rivales en diversos conjuntos de datos.

Inferencia rápida: Utiliza SAT y FasterTransformer para una inferencia rápida en un único servidor A100.

Reproducibilidad: Resultados consistentes en más de 30 tareas, gracias al código fuente abierto y los puntos de control del modelo.

Compatibilidad multiplataforma: Se adapta a una variedad de plataformas, incluidas NVIDIA, Hygon DCU, Ascend 910 y Sunway.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

GLM-130B Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

GLM-130B Tipo de tarificación

- Free

ggml.ai Tipo de tarificación

- Freemium