Última actualización 10-23-2025

Categoría:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

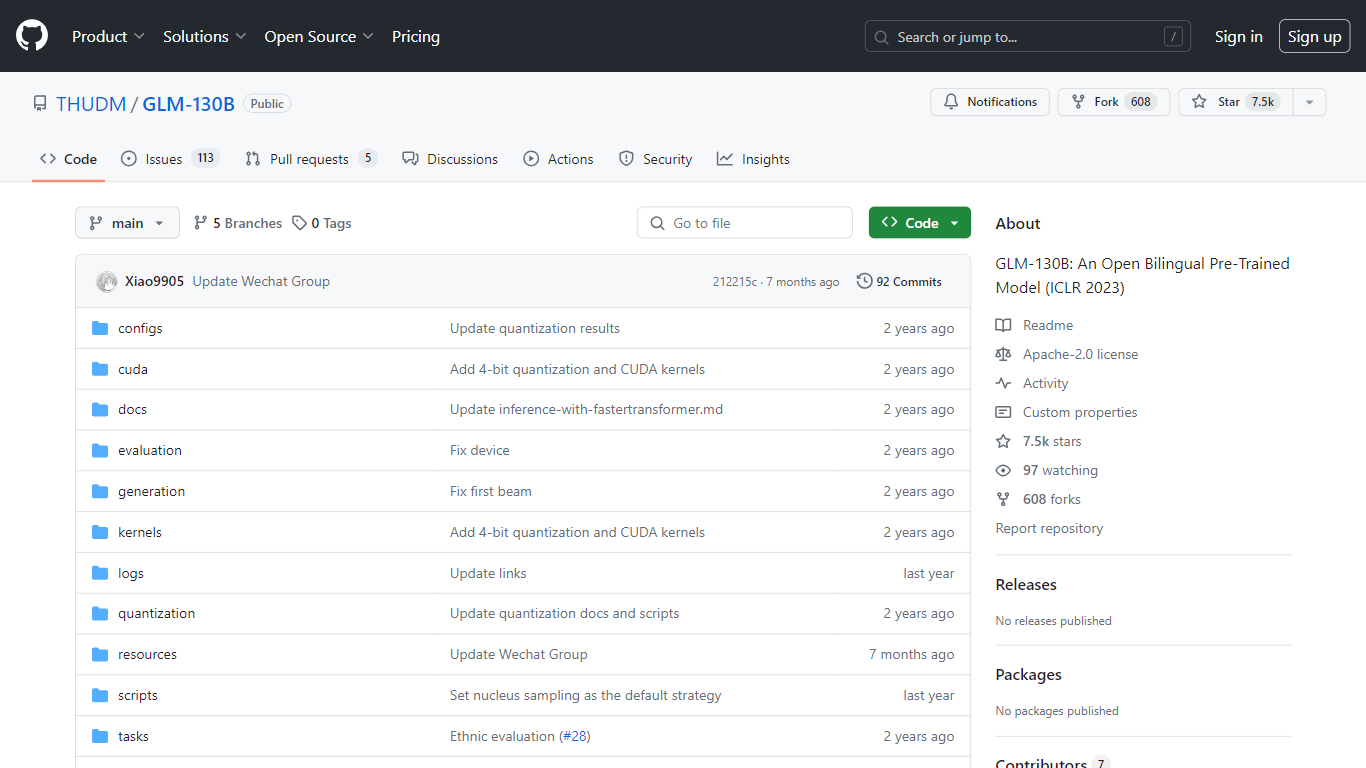

GLM-130B

GLM-130B, presentado en ICLR 2023, representa un innovador modelo bilingüe abierto preentrenado que destaca por sus impresionantes 130 mil millones de parámetros. Desarrollado para modelado denso bidireccional tanto en inglés como en chino, el GLM-130B aprovecha el algoritmo del Modelo de lenguaje general (GLM) para el entrenamiento previo y está optimizado para ejecutar tareas de inferencia en una configuración de servidor único, ya sea el A100 (40G * 8). o el V100 (32G * 8). Además, su compatibilidad con la cuantificación INT4 significa que los ya modestos requisitos de hardware se pueden reducir aún más, permitiendo que un servidor con 4* RTX 3090 (24G) admita el modelo con una mínima degradación del rendimiento.

Como parte de su proceso de entrenamiento, el GLM-130B ha digerido un extenso conjunto de datos que consta de más de 400 mil millones de tokens de texto, divididos equitativamente entre chino e inglés. Cuenta con soporte bilingüe excepcional, rendimiento superior en varios conjuntos de datos en comparación con sus contrapartes y ofrece tiempos de inferencia rápidos. Además, este repositorio también promueve la reproducibilidad al facilitar código fuente abierto y puntos de control de modelos para más de 30 tareas.

Soporte bilingüe: GLM-130B atiende a modelos en inglés y chino.

Alto rendimiento: Los puntos de referencia completos muestran que el GLM-130B supera a los modelos rivales en diversos conjuntos de datos.

Inferencia rápida: Utiliza SAT y FasterTransformer para una inferencia rápida en un único servidor A100.

Reproducibilidad: Resultados consistentes en más de 30 tareas, gracias al código fuente abierto y los puntos de control del modelo.

Compatibilidad multiplataforma: Se adapta a una variedad de plataformas, incluidas NVIDIA, Hygon DCU, Ascend 910 y Sunway.

¿Qué es el GLM-130B?

GLM-130B es un modelo denso bilingüe y bidireccional con 130 mil millones de parámetros, previamente entrenado utilizando el algoritmo Modelo de lenguaje general (GLM).

¿Con cuántos datos se entrenó el GLM-130B?

El modelo se entrenó con más de 400 mil millones de tokens de texto, 200 mil millones de cada uno para texto en chino y otro en inglés.

¿Se pueden reproducir los resultados producidos por GLM-130B?

Sí, todos los resultados de más de 30 tareas se pueden reproducir fácilmente utilizando el código fuente abierto y los puntos de control del modelo proporcionados.

¿El GLM-130B admite múltiples plataformas de hardware?

GLM-130B no solo es compatible con NVIDIA sino también con Hygon DCU, Ascend 910 y, próximamente, con plataformas Sunway para entrenamiento e inferencia.

¿Cuál es el objetivo principal del repositorio GLM-130B?

El repositorio se centra principalmente en la evaluación de GLM-130B, lo que respalda la inferencia rápida del modelo y la reproducibilidad de los resultados.