phi-2 vs ggml.ai

Explora el enfrentamiento entre phi-2 vs ggml.ai y descubre qué herramienta AI Large Language Model (LLM) gana. Analizamos votos positivos, características, opiniones, precios, alternativas, y más.

En un enfrentamiento entre phi-2 y ggml.ai, ¿cuál se lleva la corona?

Al contrastar phi-2 con ggml.ai, ambas son herramientas excepcionales operadas por inteligencia artificial en la categoría de large language model (llm), y al colocarlas lado a lado, podemos notar varias similitudes y divergencias cruciales. El conteo de votos positivos revela un empate, con ambas herramientas obteniendo la misma cantidad de votos positivos. ¡Cada voto cuenta! Emite el tuyo y contribuye a la decisión del ganador.

¿Crees que nos equivocamos? ¡Emite tu voto y muéstranos quién manda!

phi-2

¿Qué es phi-2?

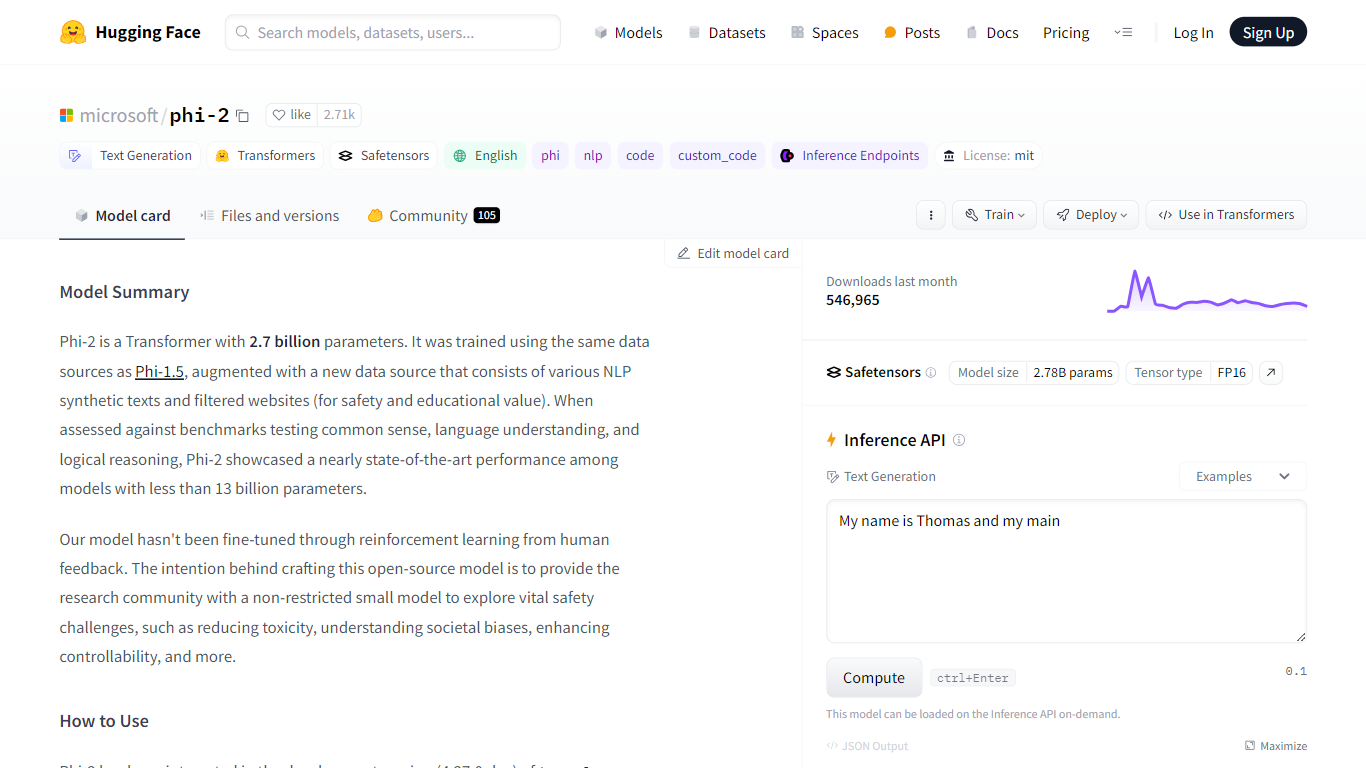

Phi-2 de Microsoft, alojado en Hugging Face, representa un salto adelante en el campo de la inteligencia artificial con sus sustanciales 2.700 millones de parámetros. El modelo basado en Transformer, Phi-2, fue entrenado meticulosamente en un conjunto de datos diverso que abarca tanto textos sintéticos de PNL como fuentes web cuidadosamente filtradas para garantizar la seguridad y el valor educativo. Phi-2 sobresale en los puntos de referencia de sentido común, comprensión del lenguaje y razonamiento lógico, estableciendo un alto estándar para los modelos de su clase.

Esta herramienta de vanguardia está diseñada principalmente para la generación de texto en inglés, lo que proporciona un recurso potente para tareas de codificación y PNL. A pesar de sus capacidades, se recomienda Phi-2 como base para un mayor desarrollo en lugar de una solución llave en mano, y se anima a los usuarios a estar atentos a posibles sesgos y verificar la precisión de los resultados. El modelo está disponible para integración con la última biblioteca de transformadores y lleva la licencia permisiva del MIT, lo que promueve la ciencia abierta y la democratización de la IA.

ggml.ai

¿Qué es ggml.ai?

ggml.ai está a la vanguardia de la tecnología de inteligencia artificial y ofrece poderosas capacidades de aprendizaje automático directamente al borde con su innovadora biblioteca de tensores. Creado para admitir modelos grandes y alto rendimiento en plataformas de hardware comunes, ggml.ai permite a los desarrolladores implementar algoritmos de IA avanzados sin la necesidad de equipos especializados. La plataforma, escrita en el eficiente lenguaje de programación C, ofrece soporte de cuantificación de números enteros y flotantes de 16 bits, junto con diferenciación automática y varios algoritmos de optimización integrados como ADAM y L-BFGS. Ofrece un rendimiento optimizado para Apple Silicon y aprovecha los elementos intrínsecos de AVX/AVX2 en arquitecturas x86. Las aplicaciones basadas en web también pueden explotar sus capacidades a través de WebAssembly y la compatibilidad con WASM SIMD. Con sus asignaciones de memoria de tiempo de ejecución cero y la ausencia de dependencias de terceros, ggml.ai presenta una solución mínima y eficiente para la inferencia en el dispositivo.

Proyectos como susurro.cpp y llama.cpp demuestran las capacidades de inferencia de alto rendimiento de ggml.ai, con susurro.cpp proporcionando soluciones de voz a texto y llama.cpp centrándose en la inferencia eficiente del modelo de lenguaje grande LLaMA de Meta. Además, la empresa agradece las contribuciones a su código base y admite un modelo de desarrollo de núcleo abierto a través de la licencia MIT. A medida que ggml.ai continúa expandiéndose, busca desarrolladores talentosos de tiempo completo con una visión compartida de la inferencia en el dispositivo para unirse a su equipo.

Diseñado para llevar la IA al límite, ggml.ai es un testimonio del espíritu de juego e innovación en la comunidad de IA.

phi-2 Votos positivos

ggml.ai Votos positivos

phi-2 Características principales

Arquitectura del modelo: Phi-2 es un modelo basado en Transformer con 2,7 mil millones de parámetros, conocido por su desempeño en la comprensión del lenguaje y el razonamiento lógico.

Cómo utilizar: Los usuarios pueden integrar Phi-2 con la versión de desarrollo de la biblioteca de transformadores asegurándose de que se utilice

trust_remote_code=Truey verificando la versión correcta de los transformadores.Usos previstos: Ideal para formatos de control de calidad, chat y código, Phi-2 es versátil para diversas indicaciones, aunque sus resultados deben verse como puntos de partida para el refinamiento del usuario.

Limitaciones y precauciones: Si bien es poderoso, Phi-2 tiene sus limitaciones, como posible generación de códigos o hechos inexactos, sesgos sociales y verbosidad, que los usuarios deben tener en cuenta.

Entrenamiento y conjunto de datos: El modelo se entrenó en un colosal conjunto de datos de tokens de 250 mil millones, utilizando GPU 96xA100-80G durante dos semanas, lo que demuestra su destreza técnica.

ggml.ai Características principales

Escrito en C: Garantiza un alto rendimiento y compatibilidad en una variedad de plataformas.

Optimización para Apple Silicon: Ofrece procesamiento eficiente y menor latencia en dispositivos Apple.

Compatibilidad con WebAssembly y WASM SIMD: Facilita que las aplicaciones web utilicen capacidades de aprendizaje automático.

Sin dependencias de terceros: Ofrece una base de código ordenada y una implementación conveniente.

Compatibilidad con salida de lenguaje guiado: Mejora la interacción persona-computadora con respuestas más intuitivas generadas por IA.

phi-2 Categoría

- Large Language Model (LLM)

ggml.ai Categoría

- Large Language Model (LLM)

phi-2 Tipo de tarificación

- Freemium

ggml.ai Tipo de tarificación

- Freemium