LiteLLM

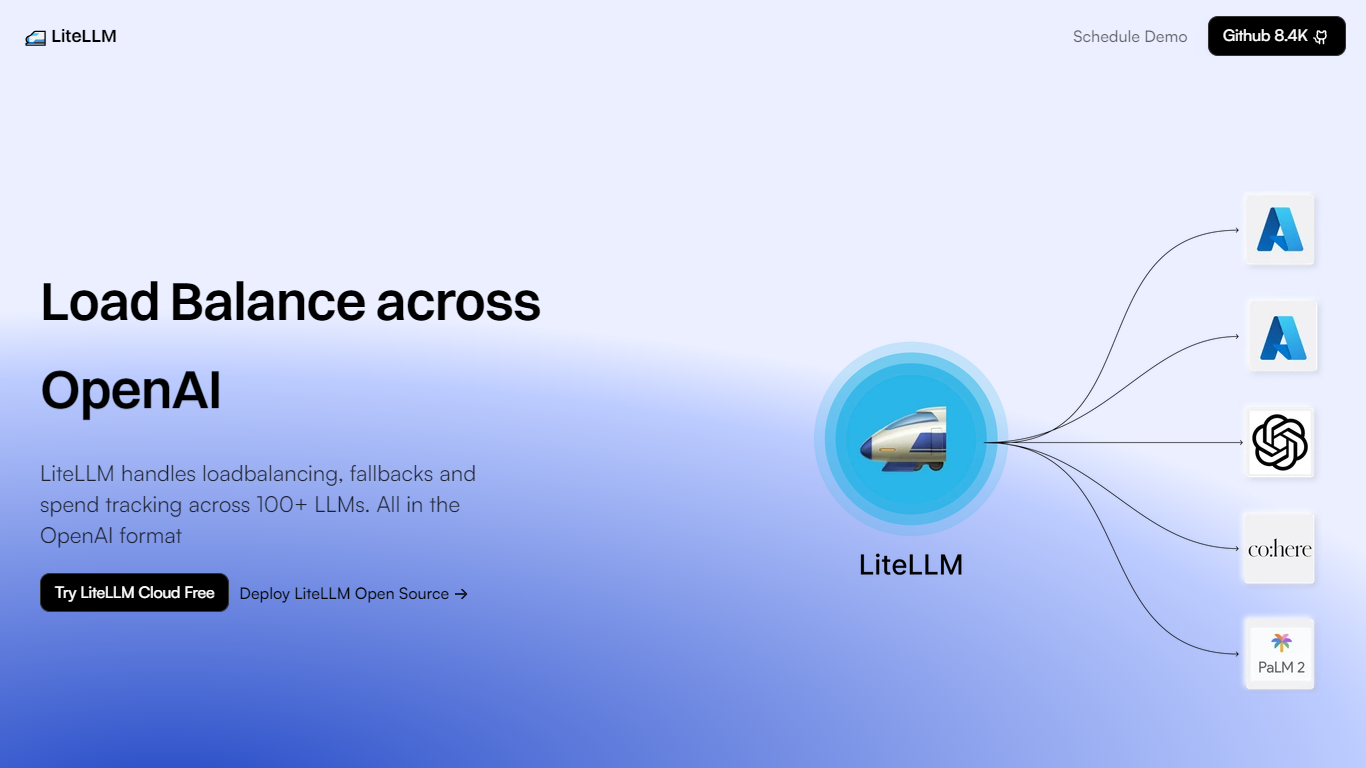

LiteLLM 是一个创新平台,专门为企业和开发人员有效管理大型语言模型 (LLM)。它通过提供负载平衡、后备解决方案和 100 多种不同 LLM 的支出跟踪,同时保持标准 OpenAI 格式兼容性,简化了与这些模型相关的复杂任务。

这使得集成和操作多个 LLM 更加高效、可靠和经济高效,因为它提供了添加模型、平衡不同计算资源之间的负载、创建访问控制密钥以及跟踪支出以更好地管理预算等功能。借助 LiteLLM,客户可以选择免费试用他们的云服务或部署他们的开源解决方案。

该平台由一个强大的社区支持,从其 GitHub 存储库中可以看出,该存储库已获得 8.4k 颗星、超过 40,000 次 Docker 拉取和超过 2000 万个请求,正常运行时间为 99%。超过 150 名贡献者的帮助确保 LiteLLM 不断发展并满足各个行业希望利用 LLM 功能的用户的需求。

负载平衡:在 Azure、Vertex AI 和 Bedrock 等各种平台之间有效地分配 LLM 任务。

后备解决方案:通过后备机制确保服务的连续性。

**支出跟踪:**监控和管理 LLM 运营的支出。

**OpenAI 格式兼容性:**维护标准 OpenAI 格式,实现无缝集成。

**社区支持:**由超过 150 名贡献者组成的强大社区提供支持,并提供资源和文档。

1) LiteLLM 专业是什么?

LiteLLM 专门为 100 多种大型语言模型提供负载平衡、后备解决方案和支出跟踪。

2) LiteLLM 是否提供免费试用或开源解决方案?

是的,LiteLLM 提供其云服务的免费试用,并允许部署开源解决方案。

3) 就正常运行时间而言,LiteLLM 的可靠性如何?

LiteLLM 拥有可靠的 99% 正常运行时间,确保服务持续可用。

4) 我如何开始使用 LiteLLM 或了解更多有关其社区的信息?

您可以联系 LiteLLM 团队获取演示或从 GitHub 下载,它在 GitHub 上有超过 8.4k 颗星,表明社区参与度很高。

5) LiteLLM 已满足多少请求?

LiteLLM 已处理了超过 2000 万个请求,反映了其处理 LLM 操作的能力和稳健性。