PaLM-E

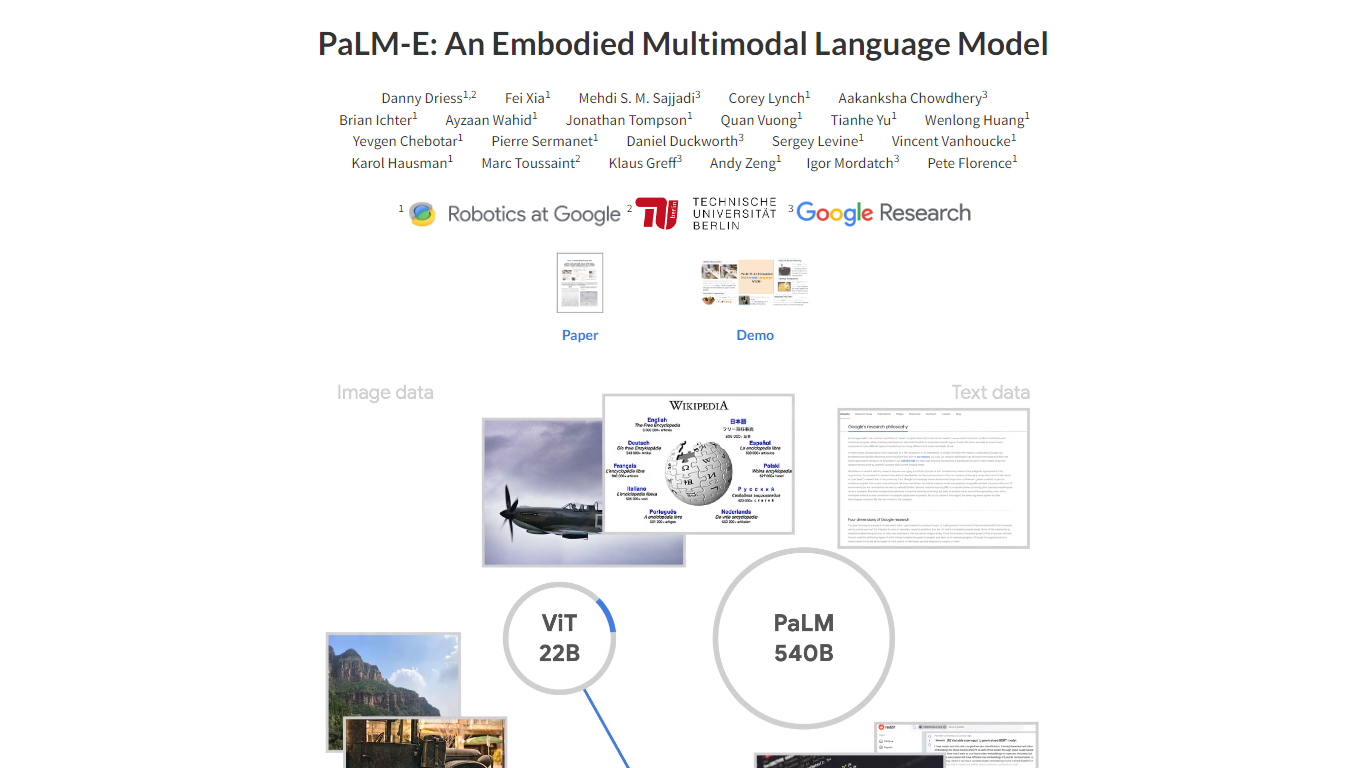

PaLM-E 项目引入了一种创新的体现多模态语言模型,它将现实世界的传感器数据与高级机器人任务的语言模型相集成。 PaLM-E 是“基于投影的语言模型体现”的缩写,它将文本输入与连续的感官信息(例如视觉和状态估计数据)融合在一起,以在物理世界中创建全面的理解和交互。

PaLM-E 旨在帮助完成机器人操作规划、视觉问答和字幕等任务,展示了针对跨领域的各种任务进行训练的大型多模态语言模型的潜力。该模型拥有最大的迭代 PaLM-E-562B,拥有 5620 亿个参数,不仅在机器人任务中表现出色,而且在 OK-VQA 等视觉语言任务中实现了最先进的性能,同时保持了稳健的通用语言技能。

端到端训练: 将传感器模式与多模式句子中的文本集成,与预先训练的大型语言模型一起进行训练。

**体现的多模态功能:**结合视觉、语言和状态估计来解决各种现实世界的任务。

多种观察方式: 适用于不同类型的传感器输入,适应多种机器人实施例。

正迁移学习: 从跨不同语言和视觉语言数据集的训练中受益。

可扩展性和专业化: PaLM-E-562B 型号专注于视觉语言性能,同时保留广泛的语言功能。

PaLM-E 项目的目标是什么?

PaLM-E 项目旨在通过将现实世界的连续传感器模式与语言模型相集成,使机器人能够理解并执行复杂的任务。

PaLM-E-562B型号有何成就?

PaLM-E-562B 模型拥有 5620 亿个参数,在 OK-VQA 等视觉语言任务上展示了最先进的性能,同时保留了多种语言能力。

PaLM-E 代表什么?

PaLM-E代表Projection-based Language Model Embodied,其中PaLM指的是使用的预训练语言模型。

PaLM-E 是否从迁移学习中受益?

是的,PaLM-E 通过在不同的互联网规模语言、视觉和视觉语言领域进行培训,实现了积极的迁移学习优势。

PaLM-E 接受过执行哪些任务的培训?

机器人操作规划、视觉问答和字幕是 PaLM-E 接受过训练的一些任务。