phi-2

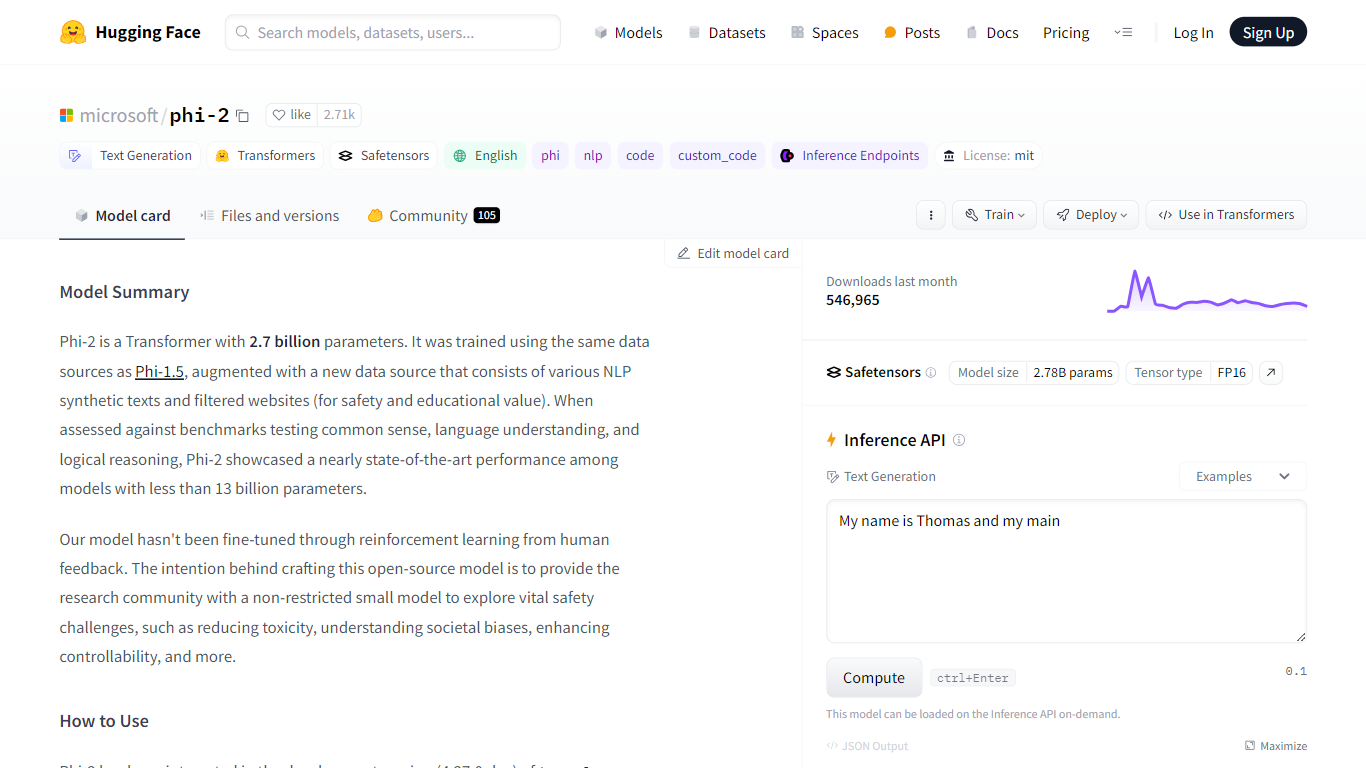

Hugging Face 上托管的微软 Phi-2 拥有 27 亿个参数,代表着人工智能领域的一次飞跃。基于 Transformer 的模型 Phi-2 在包含合成 NLP 文本和仔细过滤的网络资源的多样化数据集上进行了精心训练,以确保安全性和教育价值。 Phi-2 在常识、语言理解和逻辑推理方面表现出色,为同类模型树立了高标准。

这个尖端工具主要是为英语文本生成而设计的,为 NLP 和编码任务提供了强大的资源。尽管 Phi-2 功能强大,但仍建议将其作为进一步开发的基础,而不是交钥匙解决方案,并鼓励用户对潜在偏差保持警惕并验证输出的准确性。该模型可与最新的 Transformers 库集成,并获得 MIT 许可,促进人工智能的开放科学和民主化。

模型架构: Phi-2 是一个基于 Transformer 的模型,拥有 27 亿个参数,以其在语言理解和逻辑推理方面的性能而闻名。

如何使用: 用户可以通过确保使用“trust_remote_code=True”并检查正确的变压器版本,将 Phi-2 与变压器库的开发版本集成。

预期用途: Phi-2 非常适合 QA、聊天和代码格式,可用于各种提示,尽管其输出应被视为用户细化的起点。

限制和警告: 虽然 Phi-2 功能强大,但也有其局限性,例如潜在的不准确代码或事实生成、社会偏见和冗长,用户应该牢记这些。

训练和数据集: 该模型在巨大的 250B 代币数据集上使用 96xA100-80G GPU 进行了两周的训练,展示了其技术实力。

1) 什么是 Phi-2?

Phi-2 是一个 Transformer 模型,拥有 27 亿个参数,在常识、语言理解和逻辑推理方面表现出色。

2) Phi-2 打算如何使用?

该模型最适合 QA、聊天和代码格式,并且可以与 Transformer 库集成。

3) Phi-2 有哪些限制?

尽管进行了彻底的训练,该模型可能会生成不准确的代码或事实,用户应将输出视为建议。

4) Phi-2 是否经过微调?

Phi-2 尚未根据人类反馈进行微调,但可与 Transformer 的开发版本 (4.37.0.dev) 集成。

5) Phi-2 可以开源使用吗?

是的,该模型已获得 MIT 许可,促进开源和开放科学社区的贡献。