Última actualización 02-10-2024

Categoría:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

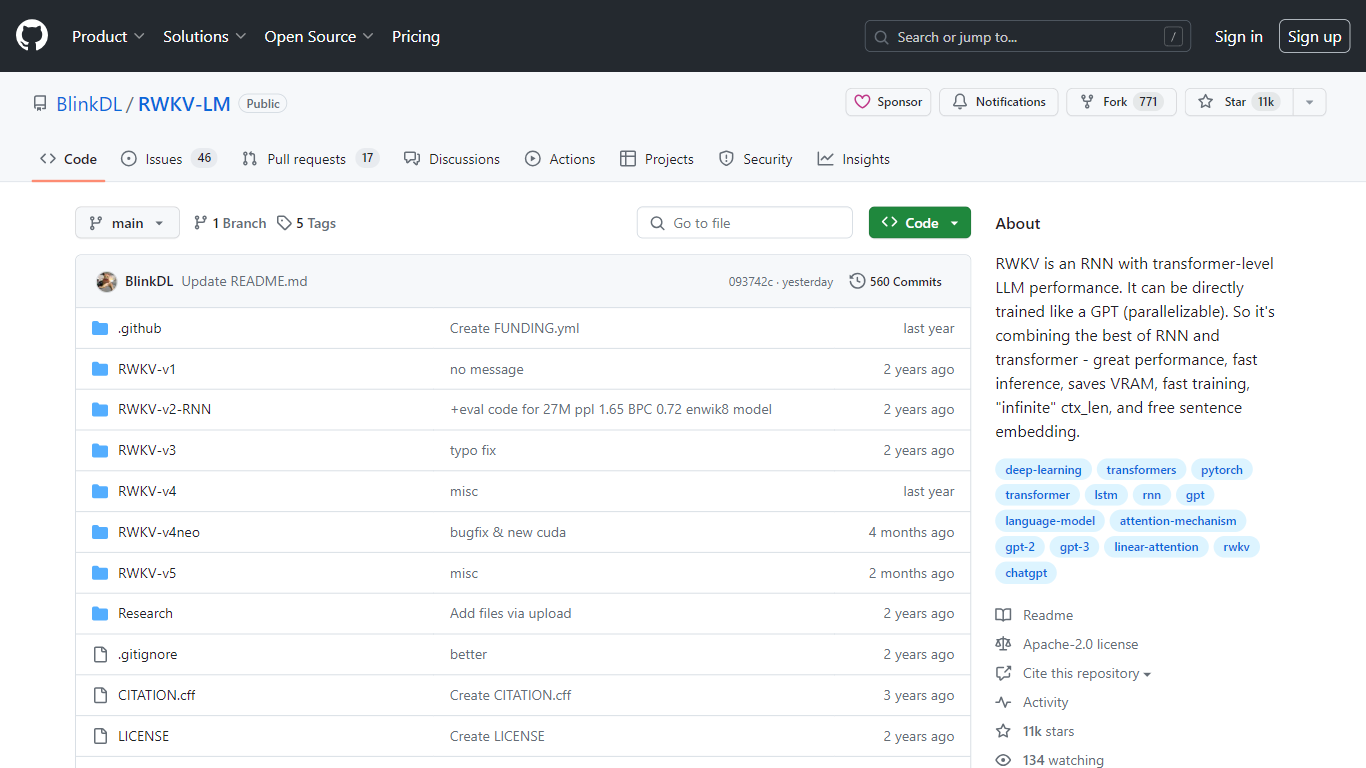

RWKV-LM

RWKV es un innovador modelo de lenguaje basado en RNN que ofrece el rendimiento excepcional de los modelos de lenguaje grande (LLM) a nivel de transformador. Esta notable fusión de la simplicidad de RNN con la eficiencia del transformador crea un modelo altamente paralelizable, similar a los modelos GPT. RWKV no solo es rápido en inferencias, sino que también demuestra velocidades de entrenamiento convenientes y al mismo tiempo es eficiente en memoria, conservando así la valiosa VRAM.

Admite una longitud de contexto "infinita", lo que le permite manejar secuencias de datos muy largas sin problemas. Además, los usuarios se benefician de capacidades gratuitas de incrustación de oraciones, lo que mejora su utilidad para una amplia gama de aplicaciones de procesamiento de lenguaje natural. Como proyecto con licencia Apache-2.0, se presenta como un repositorio público en GitHub, lo que invita a la colaboración y el desarrollo continuo.

Gran rendimiento: Ofrece rendimiento LLM a nivel de transformador en una arquitectura RNN más compacta.

Inferencia rápida: Diseñado para respuestas rápidas, lo que lo hace adecuado para aplicaciones en tiempo real.

Ahorro de VRAM: Optimizado para utilizar menos VRAM sin comprometer la eficiencia.

Entrenamiento rápido: Capaz de entrenarse rápidamente, lo que reduce el tiempo necesario para desarrollar modelos robustos.

Longitud de contexto infinita: Se adapta a secuencias extremadamente largas y ofrece flexibilidad para procesar grandes cantidades de datos.

1) ¿Qué es RWKV?

RWKV es un tipo de RNN (red neuronal recurrente) con el alto rendimiento de los modelos de lenguaje grande a nivel de transformador.

2) ¿Se puede entrenar RWKV en paralelo?

Sí, RWKV admite entrenamiento paralelo, similar a los modelos GPT, lo que lo hace altamente efectivo y eficiente en términos de tiempo.

3) ¿Cuáles son las principales ventajas de RWKV sobre los RNN tradicionales?

RWKV sobresale en rendimiento, inferencia rápida, ahorro de VRAM, entrenamiento rápido, manejo de longitudes de contexto "infinitas" y ofrece incrustación de oraciones gratuita.

4) ¿Qué significa longitud de contexto "infinita" en RWKV?

La longitud de contexto "infinita" de RWKV se refiere a su capacidad para procesar secuencias de datos muy largas sin las limitaciones típicas que se encuentran en otros modelos.

5) ¿Cómo encaja RWKV en el panorama del modelado del lenguaje?

RWKV combina los beneficios de los RNN y los transformadores, lo que lo convierte en una herramienta formidable para tareas que requieren comprender y generar lenguaje humano.