Dernière mise à jour 10-23-2025

Catégorie:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

ALBERT

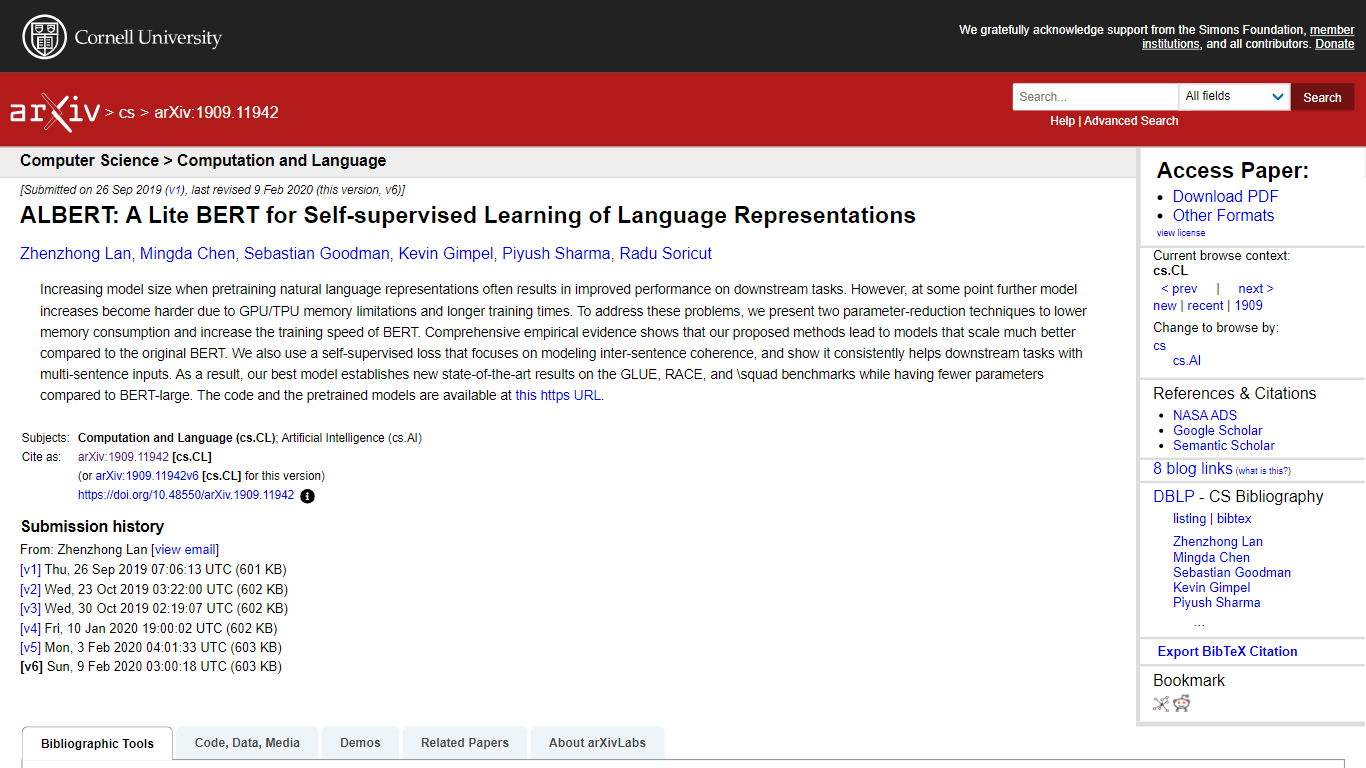

ALBERT, abréviation de « A Lite BERT », est une version optimisée du modèle BERT largement utilisé pour les tâches de traitement du langage naturel. Présenté dans l'article arXiv de Zhenzhong Lan et ses collègues, ALBERT propose deux techniques de réduction de paramètres qui réduisent considérablement la consommation de mémoire et augmentent la vitesse d'entraînement de BERT sans sacrifier les performances.

Cette avancée répond au défi des limitations de la mémoire GPU/TPU et des temps de formation généralement longs associés à l'augmentation de la taille des modèles. L'article démontre, grâce à des preuves empiriques, qu'ALBERT non seulement fonctionne mieux que BERT sur une variété de tests de référence, tels que GLUE, RACE et SQuAD, mais qu'il obtient également des résultats de pointe avec un nombre de paramètres plus petit. La recherche introduit en outre une fonction de perte auto-supervisée qui améliore la capacité du modèle à comprendre la cohérence entre les phrases, conduisant à une amélioration substantielle des tâches nécessitant des entrées multi-phrases. Les auteurs fournissent le code et les modèles pré-entraînés pour ALBERT, les rendant accessibles pour une utilisation généralisée dans la communauté PNL.

Techniques de réduction des paramètres : Techniques qui réduisent la consommation de mémoire et augmentent la vitesse d'entraînement de BERT.

Mise à l'échelle du modèle améliorée : ALBERT évolue mieux que le BERT d'origine, même avec moins de paramètres.

Performances de pointe : Les réalisations incluent de nouveaux scores élevés aux tests GLUE, RACE et SQuAD.

Fonction de perte auto-supervisée : Une nouvelle fonction de perte qui améliore la modélisation de la cohérence inter-phrases.

Modèles Open Source : Les modèles pré-entraînés et la base de code sont accessibles au public pour une utilisation par la communauté.

Qu’est-ce qu’ALBERT ?

ALBERT est une version optimisée de BERT conçue pour l'apprentissage auto-supervisé des représentations linguistiques avec des paramètres réduits pour un apprentissage efficace.

Quels sont les principaux avantages d’ALBERT par rapport au BERT original ?

ALBERT offre une consommation de mémoire réduite, une formation plus rapide, une mise à l'échelle améliorée et des performances de pointe sur les tests de performance, malgré moins de paramètres.

ALBERT peut-il gérer efficacement des tâches avec des entrées multi-phrases ?

Oui, ALBERT inclut une fonction de perte auto-supervisée qui se concentre sur la cohérence inter-phrases, ce qui contribue à améliorer les performances sur les tâches de saisie de plusieurs phrases.

Où puis-je accéder au code et aux modèles pré-entraînés d'ALBERT ?

Le code et les modèles pré-entraînés pour ALBERT sont disponibles sur l'URL du référentiel GitHub fournie.

Quels types de tâches peuvent bénéficier d’ALBERT ?

Les tâches impliquant la compréhension et le traitement du langage naturel, telles que la modélisation du langage, la classification de textes et la réponse à des questions, peuvent bénéficier d'ALBERT.