Dernière mise à jour 10-23-2025

Catégorie:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

ELECTRA

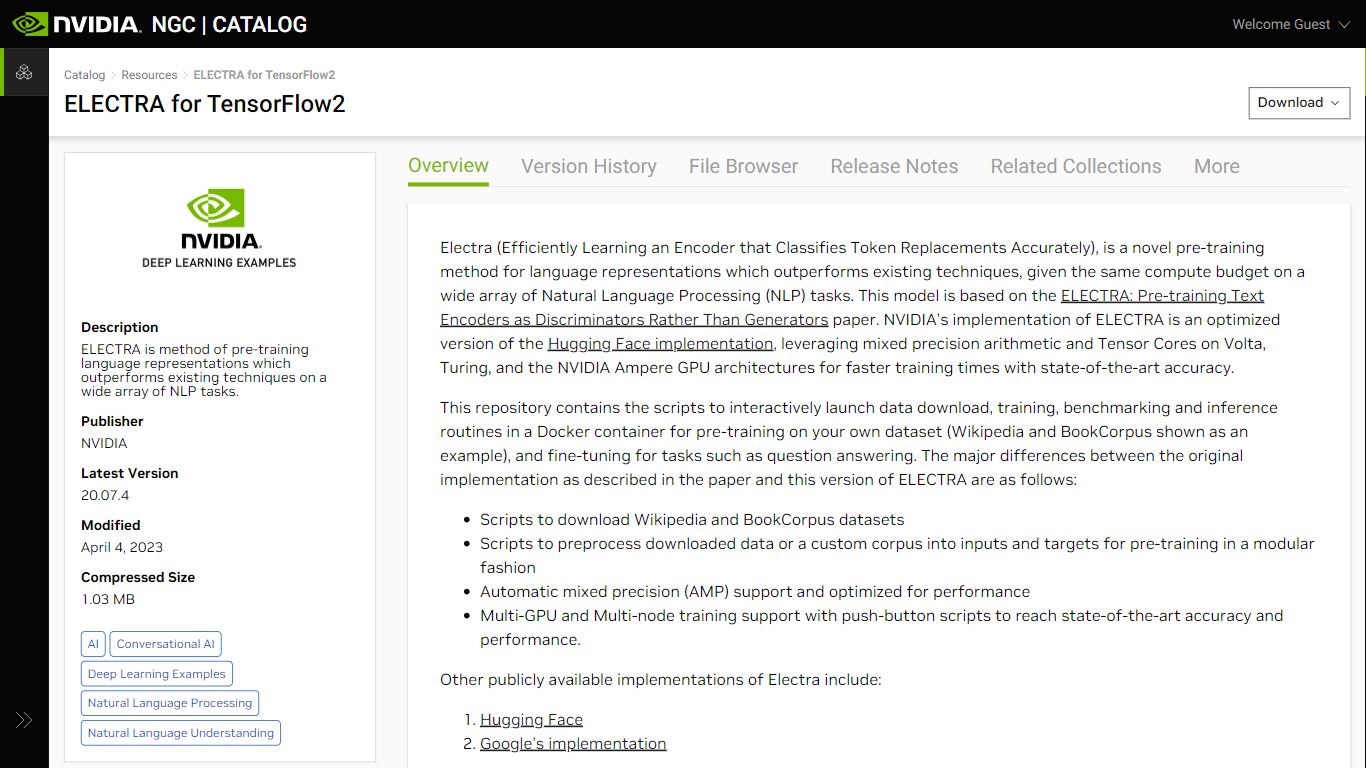

ELECTRA pour TensorFlow2, disponible sur NVIDIA NGC, représente une avancée majeure dans la représentation du langage de pré-entraînement pour les tâches de traitement du langage naturel (NLP). En apprenant efficacement un encodeur qui classe avec précision les remplacements de jetons, ELECTRA surpasse les méthodes existantes dans le même budget de calcul dans diverses applications NLP. Développé sur la base d'un document de recherche, ce modèle bénéficie considérablement des optimisations fournies par NVIDIA, telles que l'arithmétique de précision mixte et l'utilisation de Tensor Core à bord des architectures GPU Volta, Turing et NVIDIA Ampere. Il permet non seulement d'obtenir des temps d'entraînement plus rapides, mais garantit également une précision de pointe.

Comprenant l'architecture, ELECTRA diffère des modèles conventionnels comme BERT en introduisant un cadre générateur-discriminateur qui identifie plus efficacement les remplacements de jetons, une approche inspirée des réseaux contradictoires génératifs (GAN). Cette implémentation est conviviale et propose des scripts pour le téléchargement, le prétraitement, la formation, l'analyse comparative et l'inférence des données, permettant ainsi aux chercheurs de travailler plus facilement avec des ensembles de données personnalisés et d'affiner leurs tâches, notamment la réponse aux questions.

Prise en charge de la précision mixte : vitesse d'entraînement améliorée grâce à l'arithmétique de précision mixte sur les architectures GPU NVIDIA compatibles.

Formation multi-GPU et multi-nœuds : prend en charge la formation distribuée sur plusieurs GPU et nœuds, facilitant ainsi un développement de modèles plus rapide.

Scripts de pré-formation et de réglage fin : comprend des scripts pour télécharger et prétraiter les ensembles de données, permettant une configuration facile pour les processus de pré-formation et de réglage fin., -

Architecture de modèle avancée : intègre un schéma générateur-discriminateur pour un apprentissage plus efficace des représentations linguistiques.

Performances optimisées : exploite les optimisations des cœurs Tensor et de la précision mixte automatique (AMP) pour une formation accélérée du modèle.

Qu’est-ce qu’ELECTRA dans le contexte de la PNL ?

ELECTRA est une méthode de pré-formation pour les représentations linguistiques qui utilise un cadre générateur-discriminateur pour identifier efficacement les remplacements de jetons corrects et incorrects dans les séquences d'entrée, améliorant ainsi la précision des tâches NLP.

Pourquoi la version NVIDIA d'ELECTRA est-elle bénéfique pour la formation ?

La version optimisée d'ELECTRA de NVIDIA est spécialement conçue pour fonctionner sur les architectures GPU Volta, Turing et NVIDIA Ampere, en utilisant leur précision mixte et leurs capacités Tensor Core pour une formation accélérée.

Comment activer la précision mixte automatique dans la mise en œuvre d'ELECTRA ?

Pour activer AMP, ajoutez l'indicateur --amp au script de formation en question. Cela activera la fonctionnalité de précision mixte automatique de TensorFlow, qui utilise des flotteurs de demi-précision pour accélérer le calcul tout en préservant les informations critiques avec des pondérations de pleine précision.

Qu’est-ce que l’entraînement de précision mixte ?

La technique de formation à précision mixte combine différentes précisions numériques dans une méthode de calcul, en particulier FP16 pour le calcul rapide et FP32 pour les sections critiques afin d'éviter la perte d'informations, accélérant ainsi la formation.

Quelle prise en charge est fournie avec ELECTRA de NVIDIA pour TensorFlow2 ?

Des scripts pour le téléchargement et le prétraitement des données sont inclus, ainsi que la prise en charge de la formation multi-GPU et multi-nœuds, ainsi que des utilitaires de pré-formation et de réglage fin à l'aide d'un conteneur Docker, entre autres.