Dernière mise à jour 02-10-2024

Catégorie:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

XLNet

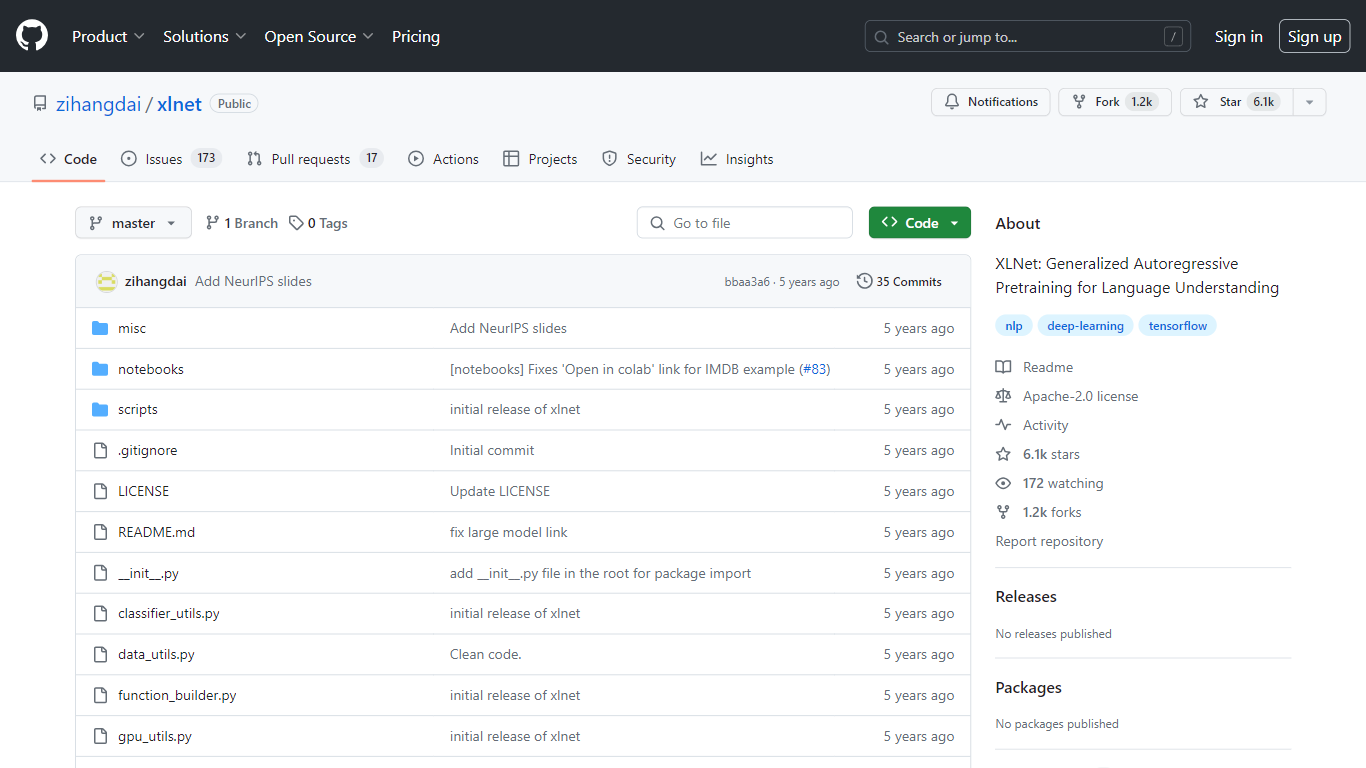

XLNet est une approche révolutionnaire de pré-entraînement linguistique non supervisé développée par des chercheurs, dont Zhilin Yang et Zihang Dai. Il introduit une méthode de pré-entraînement autorégressif généralisé qui permet des performances de pointe sur diverses tâches de compréhension du langage. En tant qu'amélioration par rapport à son prédécesseur, BERT, XLNet intègre l'architecture Transformer-XL, particulièrement apte à gérer les dépendances à longue portée dans le texte. Ce référentiel, géré par Zihang Dai sur GitHub, offre un accès au modèle XLNet, avec du code et de la documentation de support que les chercheurs et les praticiens de l'IA peuvent utiliser et potentiellement contribuer aux progrès continus des modèles de langage.

Préentraînement autorégressif généralisé : exploite une méthode avancée d'apprentissage des représentations linguistiques non supervisé.

Transformer-XL Backbone : utilise cette architecture pour une gestion améliorée des tâches à contexte long.

Résultats de pointe : Atteint des performances de pointe dans de nombreux tests de compréhension du langage.

Application polyvalente : Applicable aux tâches telles que la réponse aux questions et l'analyse des sentiments.

Dépôt actif : Permet les contributions et le développement de la communauté, favorisant ainsi les améliorations continues.

1) Qu’est-ce que XLNet ?

XLNet est une nouvelle méthode d'apprentissage des représentations linguistiques non supervisée, qui surpasse BERT sur divers benchmarks.

2) Quelle technologie XLNet utilise-t-il dans son architecture ?

XLNet utilise Transformer-XL comme architecture sous-jacente, ce qui le rend efficace dans les tâches impliquant un contexte à longue portée.

3) Où puis-je trouver plus d’informations sur les détails techniques de XLNet ?

Articles de recherche fournissant une description détaillée, notamment « XLNet : Préentraînement autorégressif généralisé pour la compréhension du langage » par Zhilin Yang, Zihang Dai et al.

4) Existe-t-il un référentiel GitHub disponible pour XLNet ?

Oui, le référentiel sur GitHub de zihangdai inclut le code nécessaire pour utiliser et contribuer à XLNet.

5) Comment XLNet se compare-t-il à BERT en termes de performances ?

Depuis la dernière mise à jour, XLNet a dépassé les performances de BERT sur 20 tâches et obtenu des résultats de pointe sur 18 d'entre elles.