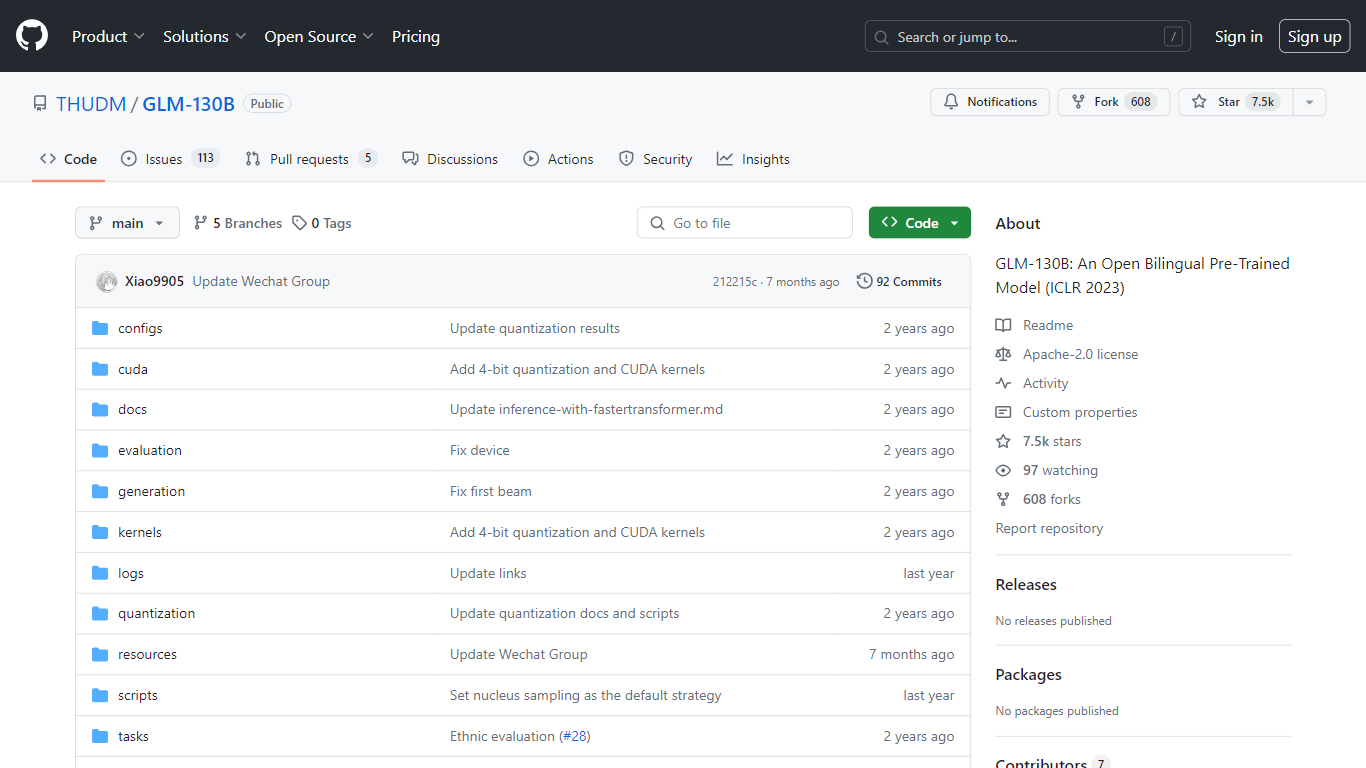

GLM-130B

在 ICLR 2023 上展示的 GLM-130B 代表了一种突破性的开放式双语预训练模型,以其令人印象深刻的 1300 亿个参数而脱颖而出。 GLM-130B 专为中英文双向密集建模而开发,利用通用语言模型 (GLM) 算法进行预训练,并经过优化,可在单个服务器设置上运行推理任务,无论是 A100 (40G * 8)或V100(32G * 8)。此外,它与 INT4 量化的兼容性意味着可以进一步降低本已适度的硬件要求,从而允许具有 4 * RTX 3090 (24G) 的服务器以最小的性能下降来支持该模型。

作为训练过程的一部分,GLM-130B 消化了由超过 4000 亿个文本标记组成的广泛数据集,其中中文和英文均等。与同类产品相比,它拥有卓越的双语支持、跨各种数据集的卓越性能,并提供快速的推理时间。此外,该存储库还通过促进 30 多个任务的开源代码和模型检查点来提高可重复性。

双语支持: GLM-130B 同时支持英语和中文语言型号。

高性能: 综合基准测试显示 GLM-130B 在不同数据集上的性能优于竞争对手模型。

快速推理: 利用 SAT 和 FasterTransformer 在单个 A100 服务器上进行快速推理。

可重复性: 得益于开源代码和模型检查点,30 多项任务的结果一致。

跨平台兼容性: 适应一系列平台,包括 NVIDIA、Hygon DCU、Ascend 910 和 Sunway。

什么是GLM-130B?

GLM-130B 是一种双语、双向密集模型,拥有 1300 亿个参数,使用通用语言模型 (GLM) 算法进行预训练。

GLM-130B 训练了多少数据?

该模型接受了超过 4000 亿个文本标记的训练,其中中文和英文文本各 2000 亿个。

GLM-130B 产生的结果可以重现吗?

是的,可以使用提供的开源代码和模型检查点轻松重现 30 多个任务的所有结果。

GLM-130B支持多种硬件平台吗?

GLM-130B 不仅支持 NVIDIA,还支持 Hygon DCU、Ascend 910 以及即将推出的 Sunway 平台进行训练和推理。

GLM-130B 存储库的主要焦点是什么?

该存储库主要关注 GLM-130B 的评估,支持快速模型推理和结果的可重复性。