最后更新 11-04-2025

总体评分:

5.0 🏆

Reviews:

Join thousands of AI enthusiasts in the World of AI!

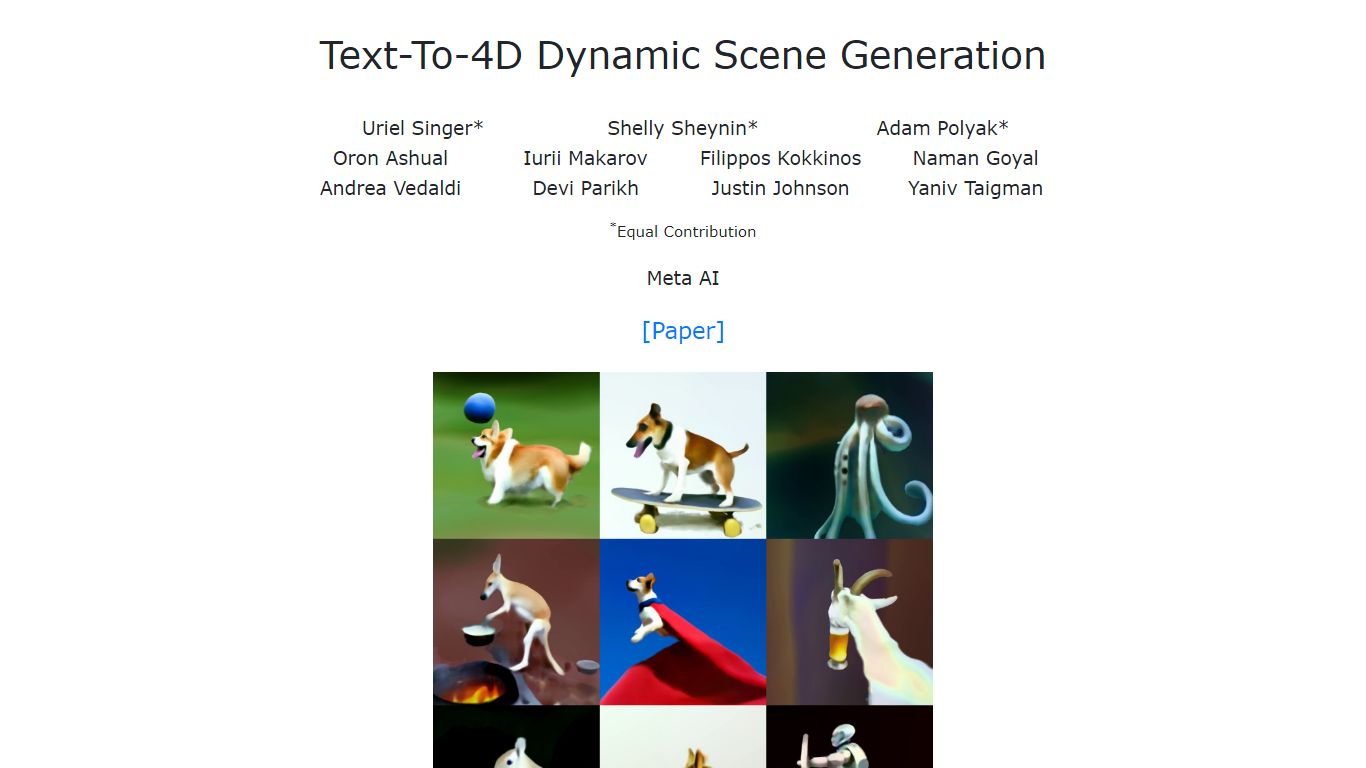

Text-To-4D

Text-To-4D,也被称为 MAV3D(Make-A-Video3D),可以根据简单的文本描述生成三维动态场景。它利用一种为确保场景外观、一致性密度和运动优化的4D动态神经辐射场(NeRF),结合文本到视频的扩散模型实现。这使得创建可以从任何摄像机角度观看的动态视频成为可能,并能够集成到各种3D环境中。

不同于传统的3D生成方法,MAV3D不需要任何3D或4D的训练数据。它依赖于仅在文本-图像对和未标记视频上训练的文字到视频模型,使没有专门数据集的用户也能使用。这一方法为希望通过文本提示生成沉浸式3D动态内容的创作者、开发者和研究人员开启了新的可能性。

该工具面向广泛的用户群体,包括游戏开发者、动画师和虚拟现实内容创作人员,帮助他们无需手动建模或动画即可快速生成动态图景。它结合了文本驱动的生成与3D动态场景输出,具有独特的价值,可用于交互式应用或视觉叙事。

从技术上讲,该方法将4D NeRF与基于扩散的Text-to-Video模型集成,确保运动和外观在时间和空间上的一致性,从而生成平滑、逼真的动态场景,用户可以从多个角度进行探索。系统在之前的内部基础上取得了改进,能够根据文本输入生成更高质量、更连贯的3D视频。

整体而言,Text-To-4D作为首个能从文本生成完全动态3D场景的方法,弥补了文本视频生成与3D场景合成之间的差距,提供了一种灵活且创新的解决方案,用于创建沉浸式内容,无需复杂的3D数据或手动画面。

🎥 从文本提示生成动态3D视频,轻松创作内容

🌐 可从任意摄像角度查看生成的场景,自由探索环境

🛠️ 无需3D或4D训练数据,简化生成过程

⚙️ 结合4D神经辐射场和扩散模型,实现流畅运动

🔗 输出可集成到各种3D环境和应用中

从简单的文本描述创建完全动态的3D场景

无需专门的3D或4D数据集进行训练

生成可从任意角度观看的视频,增强沉浸感

结合文本到视频的扩散技术与4D NeRF,实现运动一致性

支持集成到不同的3D环境和工作流程中

目前仅限于研究级实现,暂无商业计划

可能需要技术专长将输出集成到定制项目中

我可以在没有任何3D建模经验的情况下使用Text-To-4D吗?

可以,Text-To-4D可以直接从文本描述生成3D动态场景,无需任何3D建模技能。

Text-To-4D是否需要3D或4D数据进行训练?

不需要,它使用仅在文本-图像对和无标签视频上训练的文本到视频扩散模型,因此无需3D或4D数据。

我可以从不同角度查看生成的场景吗?

可以,输出视频可以从任意摄像机位置和角度观看,允许灵活探索场景。

Text-To-4D适合商业项目吗?

目前,Text-To-4D主要是一个研究工具,可能需要额外开发才能用于商业用途。

哪些类型的应用可以受益于Text-To-4D?

游戏开发、动画、虚拟现实以及任何需要从文本生成动态3D场景的项目都可以受益。

Text-To-4D如何确保生成场景中的运动一致性?

它通过查询文本到视频扩散模型来优化4D神经辐射场,从而保持外观和运动的一致性。

我可以将Text-To-4D的输出集成到现有的3D环境中吗?

可以,生成的动态视频可以合成到各种3D环境中,以增强内容创作。