Última actualización 10-23-2025

Categoría:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

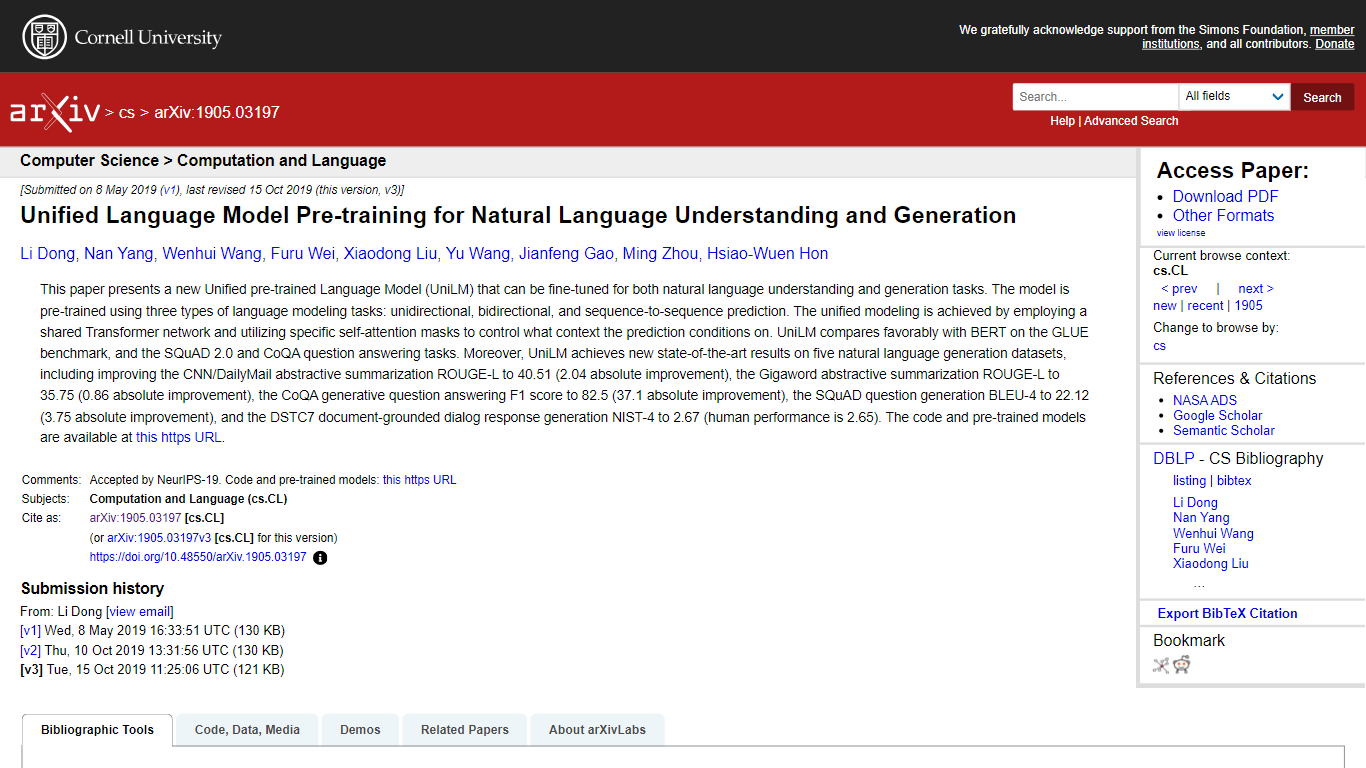

UniLM

Este artículo presenta UniLM, un modelo de lenguaje unificado previamente entrenado, que sirve como un nuevo punto de referencia para las tareas de comprensión del lenguaje natural (NLU) y generación de lenguaje natural (NLG). Es único en el uso de una red Transformer compartida que está previamente entrenada en tareas unidireccionales, bidireccionales y de secuencia a secuencia, empleando máscaras especiales de autoatención para el control de predicción contextual. UniLM supera a BERT en el punto de referencia GLUE y sobresale en respuesta a preguntas de SQuAD 2.0 y CoQA, estableciendo nuevos récords en cinco conjuntos de datos de NLG, incluidas mejoras notables en las tareas de resumen de CNN/DailyMail y Gigaword. Los modelos y el código compartido por los autores ayudan a la comunidad de investigación a avanzar más.

Capacitación previa integral: UniLM está previamente capacitado en tareas de modelado de lenguaje unidireccionales, bidireccionales y de secuencia a secuencia.

Diseño de doble propósito: Optimizado tanto para la comprensión como para la generación del lenguaje natural, lo que lo convierte en una herramienta versátil en PNL.

Control superior de autoatención: Las máscaras de autoatención únicas en la red compartida de Transformer permiten predicciones específicas del contexto.

Excelencia en los puntos de referencia: Logra nuevos resultados de última generación en varios puntos de referencia, superando modelos anteriores como BERT.

Contribución de código abierto: Los autores brindan acceso a modelos y códigos previamente entrenados para uso y mejora de la comunidad.

¿Qué es UniLM?

UniLM significa Modelo de lenguaje unificado preentrenado y está diseñado tanto para tareas de generación como de comprensión del lenguaje natural.

¿Cómo se entrena previamente UniLM?

El modelo está previamente entrenado mediante tareas de modelado de lenguaje unidireccional, bidireccional y de secuencia a secuencia.

¿UniLM funciona mejor que BERT?

Sí, UniLM supera a BERT en el punto de referencia GLUE, así como en las tareas de respuesta a preguntas de SQuAD 2.0 y CoQA.

¿Qué logros ha alcanzado UniLM?

Se lograron nuevos resultados de última generación en cinco conjuntos de datos de NLG, incluidas mejoras en las tareas de resumen de CNN/DailyMail y Gigaword.

¿Dónde puedo encontrar el código y los modelos previamente entrenados para UniLM?

Puede acceder al código y a los modelos previamente entrenados en el repositorio de GitHub proporcionado por los autores.