Dernière mise à jour 10-23-2025

Catégorie:

Reviews:

Join thousands of AI enthusiasts in the World of AI!

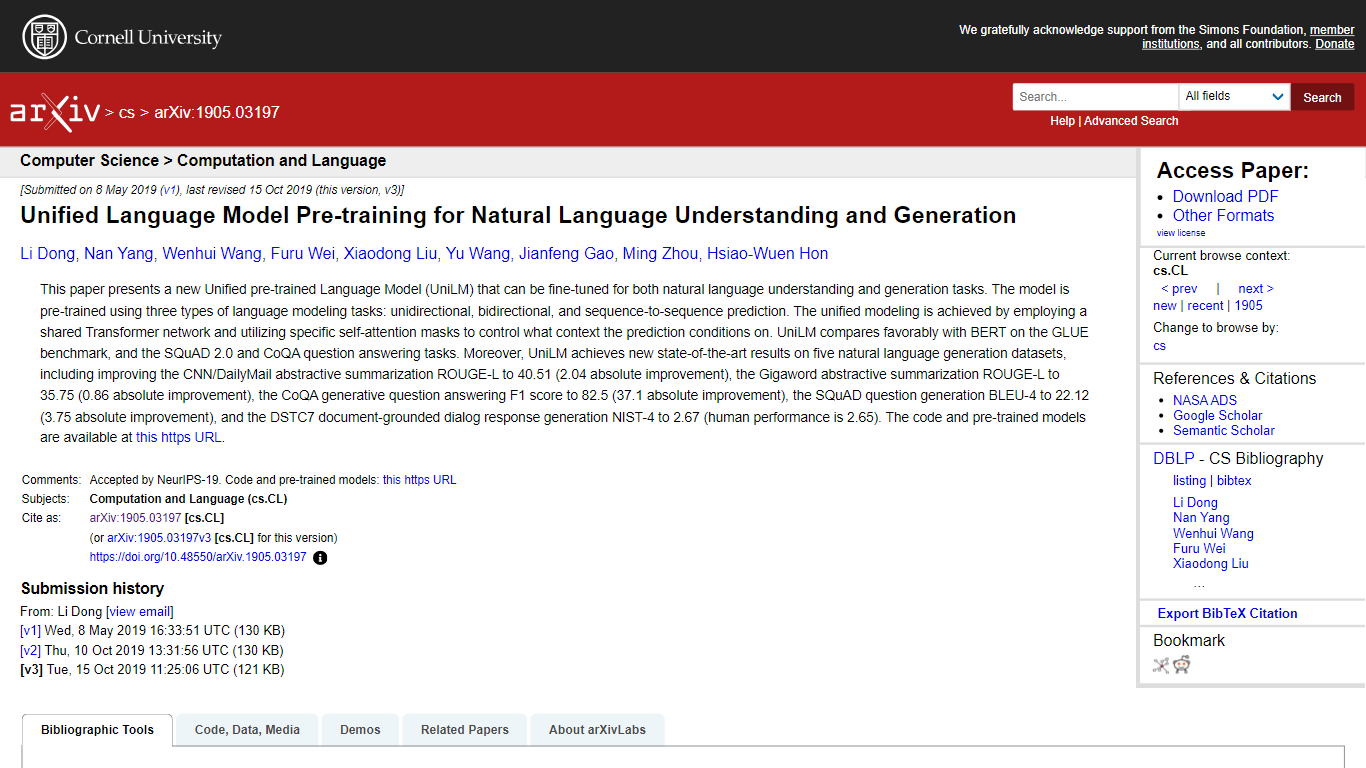

UniLM

Cet article présente UniLM, un modèle de langage unifié pré-entraîné, qui sert de nouvelle référence pour les tâches de compréhension du langage naturel (NLU) et de génération du langage naturel (NLG). Il est unique dans son utilisation d'un réseau Transformer partagé qui est pré-entraîné sur des tâches unidirectionnelles, bidirectionnelles et séquence à séquence, utilisant des masques d'auto-attention spéciaux pour le contrôle de prédiction contextuel. UniLM surpasse BERT dans le benchmark GLUE et excelle dans les réponses aux questions SQuAD 2.0 et CoQA, établissant de nouveaux records dans cinq ensembles de données NLG, y compris des améliorations notables dans les tâches de synthèse CNN/DailyMail et Gigaword. Les modèles et le code partagés par les auteurs aident la communauté des chercheurs à progresser davantage.

Pré-formation complète : UniLM est pré-formé aux tâches de modélisation de langage unidirectionnelles, bidirectionnelles et séquence à séquence.

Conception à double usage : Optimisé à la fois pour la compréhension et la génération du langage naturel, ce qui en fait un outil polyvalent en PNL.

Contrôle supérieur de l'auto-attention : Des masques d'auto-attention uniques dans le réseau Transformer partagé permettent des prédictions spécifiques au contexte.

Excellence de référence : Permet d'obtenir de nouveaux résultats de pointe sur plusieurs références, surpassant les modèles précédents comme BERT.

Contribution Open Source : Les auteurs donnent accès à des modèles et du code pré-entraînés pour une utilisation et une amélioration par la communauté.

Qu’est-ce qu’UniLM ?

UniLM signifie Unified pre-trained Language Model et est conçu à la fois pour la compréhension du langage naturel et les tâches de génération.

Comment se déroule la pré-formation d'UniLM ?

Le modèle est pré-entraîné à l'aide de tâches de modélisation de langage unidirectionnelles, bidirectionnelles et séquence à séquence.

UniLM est-il plus performant que BERT ?

Oui, UniLM surpasse BERT sur le benchmark GLUE ainsi que sur les tâches de réponse aux questions SQuAD 2.0 et CoQA.

Quelles réalisations UniLM a-t-elle réalisées ?

De nouveaux résultats de pointe ont été obtenus sur cinq ensembles de données NLG, notamment des améliorations des tâches de synthèse CNN/DailyMail et Gigaword.

Où puis-je trouver le code et les modèles pré-entraînés pour UniLM ?

Vous pouvez accéder au code et aux modèles pré-entraînés sur le référentiel GitHub fourni par les auteurs.