Drag Your GAN

在综合视觉内容以满足用户需求的领域中,对生成对象的姿势,形状,表达和布局进行精确控制至关重要。控制生成对抗网络(GAN)的传统方法在培训或先前的3D模型期间依赖手动注释,通常缺乏不同应用所需的灵活性,精度和多功能性。

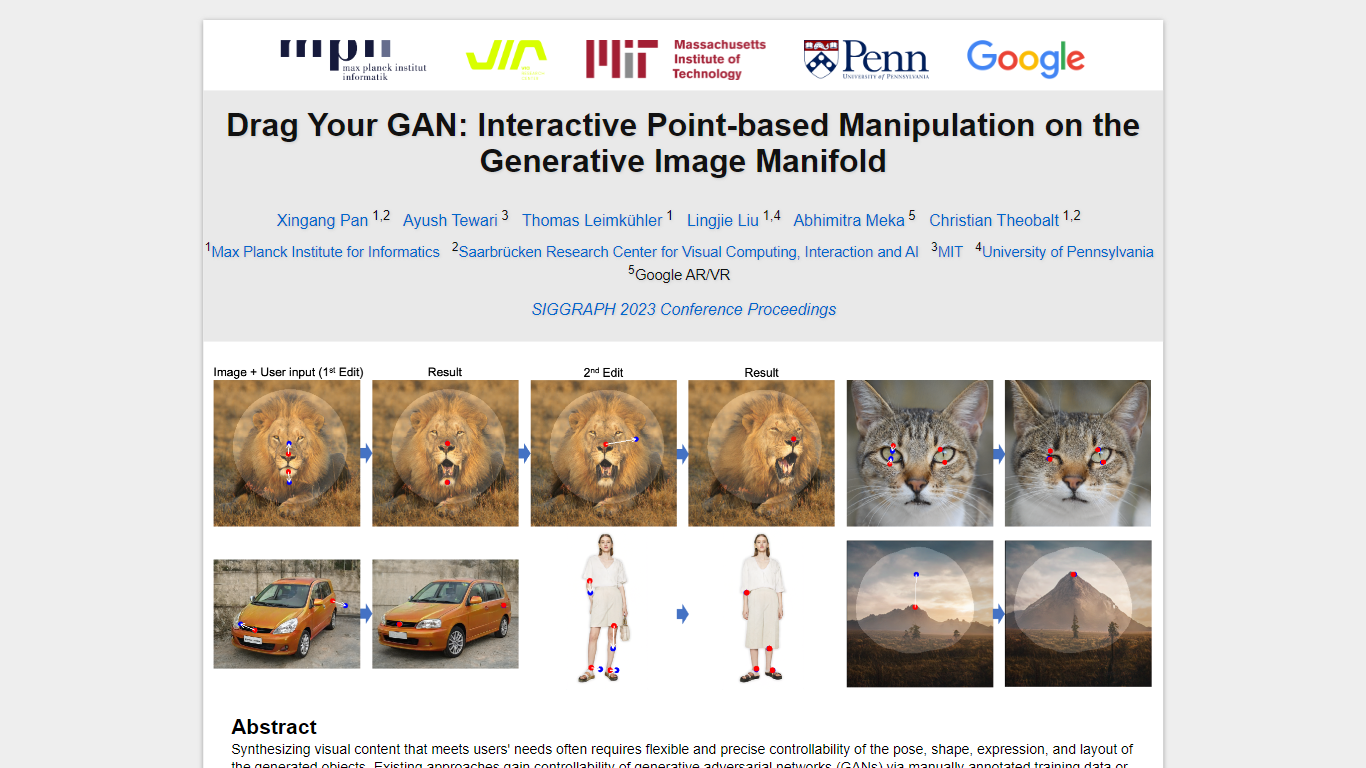

在我们的研究中,我们探索了一种创新且相对未知的GAN控制方法 - 以交互式方式“拖动”特定图像点以精确达到用户定义的目标点的能力(如图1所示)。这种方法导致了Draggan的发展,Draggan是一个新的框架,其中包括两个核心组成部分:

基于功能的运动监督:此组件通过基于功能的运动监督将图像中的点指向其预期的目标位置。

点跟踪:利用歧视性GAN功能,我们的新点跟踪技术不断定位手柄点的位置。

德拉格(Draggan)使用户能够以显着的精度变形图像,从而使姿势,形状,表达和布局在各种类别(例如动物,汽车,人类,人类,景观等)中操纵。这些操作发生在gan的学到的生成图像歧管中,从而产生了现实的输出,即使在遵循对象的刚性的同时,在生成遮挡的内容和变形形状等复杂场景中也是如此。

我们的全面评估涵盖了定性和定量比较,突出了Draggan在与图像操作和点跟踪有关的任务中的现有方法的优越性。此外,我们证明了其在通过gan倒置操纵现实世界图像的能力,展示了其在视觉内容合成和控制领域中各种实际应用的潜力。

定价:

免费

标签:

GANs

Feature-based motion supervision

Point tracking

Image synthesis

Visual content manipulation

Image deformations

Realistic outputs

Machine learning research

Computer vision

Image processing

GAN inversion

使用的技术:

GANs

Debian